ニューラル・ラディアンス・フィールド(神経放射場)を発表します。

を表現するための新しい手法です。

複雑なシーンを実現する

最先端の成果レビュー

の入力画像群が与えられると、合成を行う。

このビジュアライゼーションでは、1つのシーンが

レゴのブルドーザーを最適化する。

シーンの表現を

と定義されるベクトル値関数です。

任意の連続した5次元座標

位置と視界から構成される

方向 このシーンをパラメータ化すると

を完全連結したディープ表現として

ネットワークは、各単一の5d

座標を出力し、対応する

体積密度とビューに依存する

その位置で放射されるRGB輝度

の技術を使用することができます。

レンダリングでこれらの値を合成する

カメラアレイに沿って任意のピクセルをレンダリング

このレンダリングは完全に微分可能です。

シーンに最適化することができます。

の誤差を最小にすることで表現しています。

すべてのカメラレートをレンダリングする場合

標準的なRGB画像の集まりです。

まず、トップクラスの性能との比較を示します。

合成されたレンダリングデータのメソッド

シーン表現ネットワークは、暗黙のうちに

を使用してシーンを表現します。

接続されたニューラルネットワークを使用し、いくつかのラン

マルチビューの整合性に問題がある

を表現することができない。

周波数詳細局所光場

フュージョンでは、事前に学習させたネットワークを使って

各入力ビューを高解像度化

3次元ボリューム 不整合

隣接するボリューム間の

フリッカーアーチファクト 神経ボリューム

コーダは128立方メートルのボクセルグリッドで表示され

ワークフィールドを使用することで、より効果的に

限られたサンプルではありますが

を表現することはできません。

細かいコンテンツ

船のテクスチャーやディテール

このような傾向は、すべての製品で見られます。

合成テストシーン

質的にも量的にも

他の手法より優れている

ここでは、私たちのメソッドの結果を示します。

他の6つのオブジェクトの

リアルにレンダリングされたデータセットで

複雑な形状や非ランバート

を比較します。

で撮影した実際のシーンで

携帯電話の前方カメラ SSRNが使用するのは

リカレントネットワークは、雨の中を行進する

エンコードされたシーンでは、一貫性のない

レンダリングビュー間の外観 lff

複数のレンダリングが混在している

異なる限定された視野

に沿ってちらつくアーチファクトが発生します。

ここで、我々の方法だけが、画像の境界線

複雑なディテールを表現する

の肋骨のようなオクルージョン効果。

このT-REXの骨格標本は、化石になったものです。

さらに実物を見てみましょう。

を可視化することができます。

によって捕捉される依存効果

のような表現があります。

半透明に見えるオリーブ

オイルボトルやスペックル(斑点)部分

この部屋のストーブの映り込みは

テレビとスペキュラリティx'

会議テーブルとシャープな映り込み

この赤い車の鏡面性X'と

ボディとフロントガラスを表現しています。

高品質なシーンジオメトリをキャプチャ

赤い花のディテールのような

と複雑なオクルージョンを持つクリスマス

ツリーの葉とオーナメント

このジオメトリは十分な精度があり

追加のグラフィックスに使用

バーチャルオブジェクトのような

説得力のあるオクルージョンの挿入

効果

ここでは、さらなる成果を可視化します。

実世界のさまざまな

20~50シーンで撮影

入力画像は、ニューラル・ラディアンス・フィールド

をレンダリングすることができます。

シーン全体のリアルな新規ビュー

細かいジオメトリのディテールとリアルな

ビュー依存の反射率効果

このような視覚的な要素をすべて取り込むことができる

の重みだけで複雑な

単純な完全連結ネットワーク

また、360°回転の予備的な結果も示しています。

実景の全方位キャプチャ

<おすすめ記事>

・【科学が証明】第二言語習得論 このおすすめの学習ツールで英語をマスターする

・【株式投資でマネーマシンを作る】管理人のポートフォリオ・スペック

(管理人は米国株式に投資をしているので、英語学習をするようになりました。勉強をする意義があると継続できるし、苦痛が少なくて済むとおもいます)

・テスラの蓄電池(パワーウォール)について

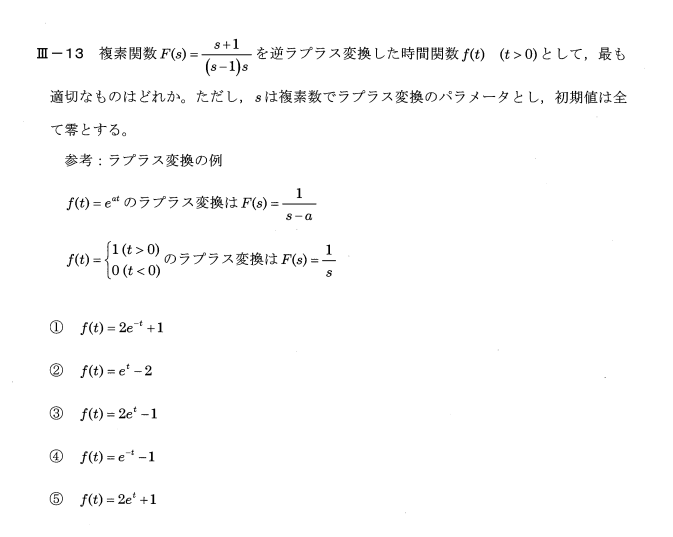

【英語学習 NeRF】NeRF: Neural Radiance Fields(ニューラル・ラディエンス・フィールド)

we present neural radiance fields or

nerf a new method for representing

complex scenes that achieves

state-of-the-art results review

synthesis given a set of input images of

a scene which in this visualization is a

Lego bulldozer we optimize a volumetric

representation of the scene as a

vector-valued function which is defined

for any continuous 5d coordinate

consisting of a location and view

direction we parameterize this scene

representation as a fully connected deep

network that takes each single 5d

coordinate and outputs the corresponding

volume density and view dependent

emitted RGB radiance at that location we

can then use techniques from volume

rendering to composite these values

along a camera array to render any pixel

this rendering is fully differentiable

so we are able to optimize the scene

representation by minimizing the error

of rendering all camera rates from a

collection of standard RGB images we

first show comparisons to top performing

methods on synthetically rendered data

scene representation networks implicitly

represent a scene using a fully

connected neural network as some runs

have issues of multi-view consistency

and are unable to represent high

frequency details local light field

fusion uses a pre trained network to

promote each input view to a high

resolution 3d volume inconsistencies

between adjacent volumes causes

flickering artifacts neural volumes in

coda seen as 128 cubed voxel grid and

use a work field to better allocate

these limited samples however they're

still unable to represent high

resolution content such as the fine

details in the ship's texture and

rigging we see the same trend in all of

our synthetic test scenes our method

both qualitatively and quantitatively

outperforms the other methods

here we show the results of our method

on the six other objects in a

realistically rendered dataset with

complex geometry and non Lambert

materials next we will show comparisons

on real scenes captured with a

forward-facing phone camera SSRN uses a

recurrent network to rain march through

encoded scenes resulting in inconsistent

appearance between rendered views lff

blends between multiple renderings with

different limited fields of view

resulting in flickering artifacts along

image borders here only our method can

represent fine details with complex

occlusion effects such as the ribs in

this fossilized t-rex skeleton now let's

take a look at some additional real

results we can visualize the view

dependent effects captured by our

representation such as the

semi-transparent appearance the olive

oil bottle and speckle areas on the

stove reflections on this room's

television and specularity x' on the

conference table and sharp reflections

and specularity x' on this red car's

body and windshield our representation

captures high quality scene geometry

such as the details on this red flower

and complex occlusions in the Christmas

tree leaves and ornaments

this geometry is precise enough to be

used for additional graphics

applications such as virtual object

insertion with convincing occlusion

effects

here we visualize additional results

across a wide variety of real-world

scenes each captured with only 20 to 50

input images our neural radiance field

representations are able to render photo

realistic novel views of entire scenes

with fine geometry details and realistic

view dependent reflectance effects we're

able to capture all of this visual

complexity in just the weights of a

simple fully connected Network

we also show preliminary results for 360

degree capture of real scenes