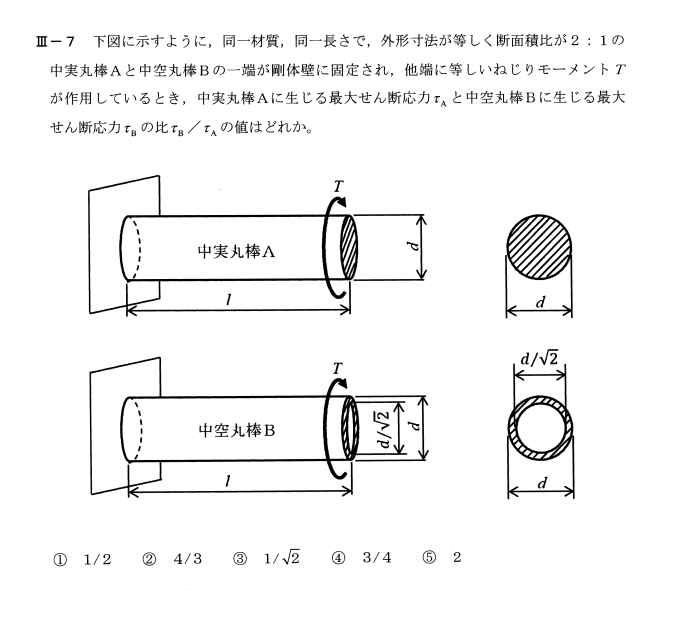

Teach & Repeat と Visual Place Recognition を用いた視覚航法の研究動向

概要と背景

Teach & Repeat(ティーチ・アンド・リピート、以下 T&R)は、ロボットに一度「経路」を教示し、その後に同じ経路を自律走行で繰り返す手法ですar5iv.labs.arxiv.org。視覚センサのみを用いる視覚ベースのT&Rシステムでは、教示時に取得した画像データをもとに現在のカメラ映像と照合し、シーンの一致度(類似度)からロボットの進行方向や位置ずれを判断します。Visual Place Recognition(視覚的場所認識、VPR)は、カメラ画像から撮影場所を認識する技術で、T&Rにおいて「現在の景色が教示経路上のどの地点に相当するか」を推定するために重要な役割を果たします。近年、このT&R手法に先進的なVPRアルゴリズムを組み合わせることで、地図やGPSに頼らずシーンのマッチングによって長距離かつ長期間にわたる自律走行を実現する研究が数多く報告されていますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。本回答では、代表的な研究論文とその概要、各手法のアルゴリズム上の特徴、利用されているVPR技術(NetVLADやSuperPointなど)、実験に用いられたデータセットやロボット、精度・ロバスト性・環境変化への適応性の結果、さらに従来のSLAM手法との比較について包括的にまとめます。

代表的な研究論文とその概要

以下に、本分野の代表的な研究論文を年代順に挙げ、その著者・年・発表先と要旨をまとめます。

-

Furgale & Barfoot (2010, JFR) – 「Visual Teach and Repeat for Long-Range Rover Autonomy」furgalep.github.io: トロント大学のFurgaleとBarfootによる古典的研究で、ステレオカメラのみを用いた長距離自律走行のT&Rシステムを提案しました。この手法では教示フェーズで経路上に重複する小規模のサブマップを逐次構築し、繰り返し走行時には各サブマップ内で自己位置を推定して局所的に経路をなぞりますfurgalep.github.io。全域的な地図を保持せず**重複サブマップのつながり(ハイブリッドなトポロジー・メトリック地図)**で誤差蓄積を防ぐアプローチであり、非平坦地形でも3次元自己位置を推定しつつ局所平面に射影して経路追従を行いましたfurgalep.github.io。カナダ北極圏の火星アナログ環境や都市環境で評価を行い、累計32kmの走行の99.6%を自律走破し、1回の自律走行は最長3.2kmに及びましたfurgalep.github.io。GPSなしでこれほど長距離の走行を実現した初のシステムであり、高度に3次元的で非構造的な屋外環境でも動作することを示していますfurgalep.github.io。特徴点にはSURFアルゴリズムarxiv.orgを用いており、視覚オドメトリと局所地図のマッチングにより自己位置を補正しています。

-

Royer et al. (2007, IJCV) – 「Monocular Vision for Mobile Robot Localization and Autonomous Navigation」: 単眼カメラによる屋外環境での経路追従を実現した先駆的研究です。画像から点特徴を抽出・追跡し、教示経路全体の構造を復元してからローカライズする位置ベースの手法で、グローバルなマップ再構成を行いましたfurgalep.github.io。後述のFurgaleらの手法とは対照的に、Royerらは経路全域の地図を用いたため精密な自己位置推定が可能でしたが、大域地図の維持に計算コストが掛かります。この研究はグローバルマップを用いたT&Rの嚆矢であり、後続の研究に大きな影響を与えました。

-

Segvić et al. (2009, IROS) – 「View-Sequenced Route Representation for Visual Navigation」: Royerらとは異なり、Segvićらは視点順序に沿った画像列のみを用いて現在視界と教示画像を逐次マッチングする外観ベースの経路追従を実現しましたfurgalep.github.io。このシステムでは現在のカメラ画像と教示時の画像群を比較し、もっとも外観が一致する教示画像を選択してロボットの進行制御に反映します。いわば**「地図を持たないルートメモリ」**の方式で、マップ不一致の問題を回避しましたfurgalep.github.io。本研究はグローバル位置推定を行わない純粋トポロジカルな手法として位置ベースSLAM不要のアプローチを示しています。

-

Clement, Kelly & Barfoot (2016, FSR) – 「Monocular Visual Teach and Repeat Aided by Local Ground Planarity」arxiv.org: Barfoot研究室による後続の研究で、単眼カメラのみで高精度なT&Rを実現しています。単眼ビジョンではスケール(絶対距離)が不明なため経路追従精度に課題がありますが、本手法では**「路面が局所的に平面である」と仮定し、カメラと車体の既知の取り付け高さから絶対尺度を回復する手法を提案しましたarxiv.org。爆発物処理ロボットなど既存のモノクロカメラ搭載移動体にもソフトウェア的に適用可能な実装で、追加センサなしにセンチメートル級の経路追従精度を達成していますarxiv.org。実環境で延べ4.3kmにわたる経路追従試験を行い、ステレオカメラ方式と同等の精度**を実証しましたarxiv.org。このようにモノカメラの課題であるスケール不確定性を工夫で克服した点が特徴です。

-

Paton et al. (2016, IROS) – 「Bridging the Appearance Gap: Multi-experience Localization for Long-Term Visual Teach and Repeat」: 長期運用での環境外観変化(昼夜・季節など)の問題に対処するために、マルチエクスペリエンス・マップの概念を導入した研究ですarxiv.org。同一経路を異なる環境条件(例:晴天・雨天、夏・冬、昼・夜など)で複数回教示し、それら複数の「経験」をデータベース化することで、走行時に現在の外観に最も近い経験からマップを選択してローカライズします。著者らはIROS2016でこのアルゴリズムを発表し、外観変化が大きくても橋渡し的に類似した中間経験を経由することで外観ギャップを克服できることを示しました。長期反復走行におけるロバスト性向上の一つの解として重要な成果です。

-

MacTavish et al. (2017, ICRA) – 「Visual Triage: A Bag-of-Words Experience Selector for Long-Term Route Following」: Patonらの続編にあたる研究で、蓄積した複数経験の中からBag-of-Words表現を用いて現在に適した経験マップを自動選択する手法を提案しましたarxiv.org。環境の見え方に応じて能動的にマップを切り替えるエクスペリエンス・トリアージ戦略で、マルチエクスペリエンスT&Rの実用性を高めています。これらPaton・MacTavishらの一連の研究は、長期にわたるT&R航法の実現において環境変化への適応性を飛躍的に向上させました。

-

Camara et al. (2020, IROS) – 「Accurate and Robust Teach and Repeat Navigation by Visual Place Recognition: A CNN Approach」arxiv.org: チェコ工科大学のグループによる研究で、近年の深層学習ベースのVPRを取り入れた初の外観ベースT&Rシステム「SSM-Nav」を提案しましたar5iv.labs.arxiv.org。特徴は、CNNの中間層特徴マップから局所特徴をグリッド状に抽出し、主成分分析で次元圧縮して利用するSemantic & Spatial Matching VPR (SSM-VPR) 手法を組み込んだ点ですar5iv.labs.arxiv.org。教示フェーズでは経路画像とそれに対応するオドメトリ距離を蓄積し、走行フェーズではVPRで現在画像にマッチする教示画像を検索します。二段階のマッチング(粗い検索と詳細な再ランク付け)にCNN特徴を用い、さらに結果をパーティクルフィルタで平滑化してロバストな1次元位置推定を行いましたar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。加えて、教示区間の曲率に応じて参照画像の配置間隔を変える適応的サンプリングや、走行中のカーブで速度を落とす制御、自己位置不確かさに応じたリカバリーモードなど、多くの工夫で実システム性能を高めていますar5iv.labs.arxiv.org。屋内外の実環境(ホイールロボットによる走行)で評価した結果、照明変化の大きい状況でも高いローカリゼーション性能を示し、ドア通過など精密なナビゲーションも可能でしたarxiv.org。著者らは本手法を「外観ベースT&Rの新たなアプローチ」と位置付けており、VPRの強力さを活かして日中・夜間にわたる頑健な経路追従を実現していますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。なおSSM-Navは後述の後継システムSSM-Nav2の土台となりました。

-

Sun et al. (2021, IROS) – 「Robust and Long-Term Monocular Teach-and-Repeat Navigation using a Single-Experience Map」eprints.whiterose.ac.ukeprints.whiterose.ac.uk: 英シェフィールド大学を中心とするグループによる研究で、単一の教示マップで昼夜間の外観変化に耐えるT&Rを実現しましたeprints.whiterose.ac.uk。本手法では自己教師あり学習で得た深層局所特徴量「DarkPoint」を提案し、画像特徴マッチングに用いることで日中と夜間で大きく照度が異なるシーン間でも頑健に対応していますeprints.whiterose.ac.ukeprints.whiterose.ac.uk。さらに視覚ローカリゼーションと経路追従用の車体制御を密に統合し、特に単眼ゆえ不明な横方向ずれ量をPI制御で逐次補正するリアルタイム制御手法を導入しましたeprints.whiterose.ac.uk。実環境の多様な屋外経路で昼から夜への移行を含む長距離走行実験を行い、25Hz以上のリアルタイムで動作しつつ高精度な経路追従を実現していますeprints.whiterose.ac.uk。比較実験では、従来手法の一つである「STROLL」(先行研究の外観マッチング方式)は経路の約1/4で追従失敗しましたが、本手法(DarkPoint)およびSuperPoint+SuperGlueベースの手法は全経路を問題なく走行できましたeprints.whiterose.ac.uk。さらにDarkPoint方式はSuperGlue方式より若干誤差が小さく、総合的に精度・ロバスト性で既存手法を上回る結果を示していますeprints.whiterose.ac.ukeprints.whiterose.ac.uk。この研究により、深層学習で得られたロバストな特徴量と制御統合により、モノクロカメラでも昼夜連続運用が可能なレベルの信頼性が達成できることが示されました。

-

Truhlařík et al. (2025, 提出中) – 「Multi-Platform Teach-and-Repeat Navigation by VPR Based on Deep-Learned Local Features」ar5iv.labs.arxiv.orgar5iv.labs.arxiv.org: こちらは2025年時点の新しい研究動向で、SSM-Navを発展させた「SSM-Nav2」システムを提案しています。外観ベースT&Rにおける最新のVPR技術を取り入れ、主な貢献として(1)新しいVPR手法「SSM-hist」の導入、(2)高精度な画像間シフト量算出アルゴリズムの開発、(3)多様なプラットフォーム(車輪ロボットから小型UAVまで)に対応するシステム設計を挙げていますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。具体的には、深層局所特徴D2-Netarxiv.orgを用いた二段階VPR(粗検索+ヒストグラム集票による精細再ランク付け)によってロバストな場所認識を行いar5iv.labs.arxiv.orgar5iv.labs.arxiv.org、そのマッチング結果から教示画像との水平シフト量をヒストグラム集計で算出してリアクティブなステア制御に反映しますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。SSM-Nav2はHusky A200ロボット(車輪)やDJI Telloドローン(UAV)で実験され、屋内外や昼夜を問わず安定に動作することが示されていますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。さらに著者らは外観ベース航法の専用データセットを新規に収集・公開し、提案システムと既存手法(BearNavやSSM-Navなど)との詳細な比較評価を行いましたar5iv.labs.arxiv.org。結果、SSM-Nav2は複数のシナリオで既存手法を凌駕する性能を示し、日中・夜間のシーン変化にも高いロバスト性を発揮したと報告されていますar5iv.labs.arxiv.org。この研究は今後正式出版予定ですが、T&RとVPRの融合技術が多様なロボットプラットフォームへ拡張可能であることを示す最先端の成果です。

-

その他の関連研究: 上記以外にも、Krájníkら(2018年, IROS)はコンバージェンス定理に基づき明示的な位置同定を行わずにゴールに収束する経路追従法を提案しておりarxiv.org、外観ベースでも安定に走行できる理論的枠組みを示しました。また、Warrenら(2019年, RA-L)はマルチコプターUAVにT&Rを適用し、GPS喪失時に教示経路を頼りに離陸地点へ緊急帰還するシステムを実証していますarxiv.org。さらにNitscheら(2019年, ECMR)はビジュアル・イナーシャルT&Rにより、カメラとIMUを併用したUAVの経路追従を報告していますarxiv.org。最近では、Rozsypálekら(2022年, Sensors)がコントラスト学習による特徴記述子をT&Rに応用して画像マッチング精度を高める手法arxiv.orgや、Roučekら(2022年, Sensors)が自己教師ありで特徴マッチングのロバスト性を向上するパイプラインarxiv.orgを提案するなど、特徴量学習面の発展も見られます。さらにRozsypálekら(2023年, RA-L)は高次元パーティクルフィルタを用いて長期環境変化下での自己位置追跡を改善する研究arxiv.orgを行うなど、T&Rの長期信頼性向上に向けた様々なアプローチが模索されています。

以上が主要な文献の概要です。次節以降では、これら研究で用いられているTeach & Repeatの手法やアルゴリズム上の特徴、VPR技術の詳細、実験環境と結果、そして従来手法との比較について整理します。

Teach & Repeat手法とアルゴリズムの特徴

● Teach & Repeatの基本アプローチ: T&R手法は大きく位置ベース(Position-based)と外観ベース(Appearance-based)の2種類に分類できますar5iv.labs.arxiv.org。位置ベース方式では教示時に構築した地図上でロボットの絶対位置(6DoF位置姿勢)を継続推定し、教示経路上の対応位置との差分から制御コマンドを計算しますar5iv.labs.arxiv.org。このため高精度な自己位置を得るために環境地図(特徴点地図や3D点群地図など)の作成・保持が必要で、典型的にはSLAMに近い処理を内部で行います。一方、外観ベース方式ではグローバルな地図を用いず経路に沿った1次元の位置(経路上の進行度)のみを管理しますar5iv.labs.arxiv.org。ロボットは教示走行で撮影・記録した連続する画像列を参照情報とし、現在のカメラ画像ともっともマッチする教示画像を見つけ出し、両画像のシフト量(ずれ)からハンドル操作の補正量を決定しますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。外観ベースでは基本的にオドメトリ(車輪速など)に基づく推定位置を主体に走行し、ビジョン(カメラ)はオドメトリ誤差を修正するフィードバックとして機能する場合が多いですar5iv.labs.arxiv.org。このようにT&Rでは経路自体が固定されているため問題の次元を大幅に削減でき、グローバルな地図整合性を維持せずとも局所的一貫性が保てればよい点がSLAMとは異なる特徴ですeprints.whiterose.ac.uk。

● 位置ベースT&Rの特徴: 位置ベース手法の代表例であるFurgale & Barfootのシステムでは、ステレオカメラによる視覚オドメトリで得られた局所地図(サブマップ)を順次接続して経路全体を表現していますfurgalep.github.io。各サブマップは小規模な特徴点マップで、隣接するサブマップ間で重複領域を持たせることで、走行中は現在地の属するサブマップ内で自己位置を推定し、マップ間の移行時に隣のマップに継続的に位置を引き継ぎますfurgalep.github.io。この局所的なトップメトリック地図によって、長大な経路でも計算負荷を各サブマップ内に限定しつつ誤差蓄積をリセットできる構成になっていますfurgalep.github.io。一方、Royerらの手法のように単眼カメラから経路全体の3次元構造(全経路の特徴点地図)を復元する方式では、グローバルマップ上で常に自己位置を推定しますfurgalep.github.io。この場合、経路が長くなるほど地図も大規模化し計算コストが増大しますが、ロボットの絶対位置を直接得られるため経路追従だけでなく地図上での再利用性が高いという利点があります。Barfootらのグループはその中間のアプローチとしてマップの分割と接続を用い、また後続研究ではSLAMから得られるポイントクラウド地図を直接T&Rに活用する手法も提案されていますarxiv.org。例えばPivoňka & Přeučil (2021)はORB-SLAM2で構築した地図上をトレース走行するT&Rを実現しており、SLAM技術との橋渡しも模索されていますarxiv.org。位置ベースT&Rは一般に、経路の幾何学的精度を高く保ちやすく、障害物回避や局所再計画にも応用しやすい反面、大域地図の維持やループクローズ処理などSLAMに近い複雑さが伴います。

● 外観ベースT&Rの特徴: 外観ベース手法では、画像マッチングによる直接的な位置ずれ推定とリアクティブ制御がポイントとなりますar5iv.labs.arxiv.org。典型的には教示画像群の中から現在画像と「最も似ている」画像をVPR手法で検索し、その画像との位置関係を求めてハンドル操舵角や速度を調整します。例えばSegvićらの手法では連続する画像間の見た目の類似度を逐次計算することで経路上の位置を追跡しましたfurgalep.github.io。CamaraらのSSM-NavではVPRで得た候補位置をパーティクルフィルタで安定化させ、直近の教示画像に対する横ずれ量(ピクセルシフト)を計算して経路からの横偏差を補正する制御を行いましたar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。横ずれ量の計算には画像特徴点マッチングを用い、2つの画像の対応特徴点の画素座標差分ベクトルをヒストグラム集計して求めますar5iv.labs.arxiv.org。これは多数の特徴点対応から外れ値の影響を低減しつつカメラの相対水平移動量を推定する手法で、SSM-Nav2ではD2-Net特徴を使ったこのヒストグラム法(「histogram of shifts」)が組み込まれましたar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。外観ベースでは位置推定が1自由度(経路上の進行位置)のみなので累積誤差が生じても軌道からの横ずれとして検出・補正できますfurgalep.github.io。ただし進行方向のずれ(例えばコーナーの曲がりすぎ/足りなさ)は教示画像とのマッチングスコア低下として現れるため、パーティクルフィルタやシーケンスマッチング(連続する画像のパターンから現在位置を推定するSeqSLAM的手法)で補完しますar5iv.labs.arxiv.org。STROLLやBearNavといった過去の外観ベースシステムでは、主にORB等の局所特徴を用いて画像のずれ量(ベアリング差)を安定的に検出する工夫がなされていますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。Krájníkらの研究はさらに踏み込んで、画像特徴のマッチングではなく収束定理に基づくフィードバック制御でゴールへ導くという手法を提示しており、これは極端な外観ベース(地図も自己位置も推定しない)とも言えますarxiv.org。総じて外観ベースT&Rは計算が比較的軽量で、カメラとオドメトリさえあれば実装可能な簡潔さが魅力ですar5iv.labs.arxiv.org。欠点としては教示経路からの大きな逸脱に弱いことや、障害物回避のために経路を外れることが難しい点があります。ただし研究によっては、教示時よりコースを外れた場合に最も近い教示画像を探索してリカバリー走行するモードを備える例もありますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。また教示画像の選択に失敗すると誤った対応に陥る危険もあるため、パーティクルフィルタで複数仮説を追跡したり、シーケンス全体で評価する(複数の画像のマッチング系列で判断する)などの対策が取られていますar5iv.labs.arxiv.org。

● ロングターム運用の工夫: 長期間にわたってT&Rを運用する場合、環境の変化(時間・天候・季節による見た目の変動)への対応が鍵となります。上述のPatonらのマルチエクスペリエンス手法は、その解決として複数時点の教示データを蓄積し必要に応じて切替えるアプローチでした。一方、Sunら(2021)の研究のように単一マップで賄う場合は、特徴記述子自体を頑健にすることが重要です。本手法では昼夜の差異を自己学習したDarkPoint特徴で吸収しましたeprints.whiterose.ac.uk。他にも、CNNを用いて画像を人工的に変換(例えば暗所風にレンダリング)し、異なる条件間でマッチしやすい特徴を抽出する手法も検討されていますarxiv.org。SSM-Nav系の手法では、二段階認識(最初に広く候補を探し出し、その中から詳細マッチングで絞り込む)が有効でしたar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。最初の粗い段階では高次特徴(セマンティック寄り)を使い、候補画像を数枚選びます。次に精密段階では局所特徴(空間情報を保持)で詳細に比較し、一致度合いを再評価して最適な教示フレームを決定しますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。これにより計算効率を維持しつつ誤認識を大幅に減らしています。さらに、マップに含める教示画像の選定も工夫点です。距離一定ごとに撮影するのではなくカーブでは密、直線では疎に撮影する適応的画像取得戦略を採用した例がありますar5iv.labs.arxiv.org。これにより必要十分な画像のみ記録しメモリ節約しつつ、曲がり角では細かく特徴を押さえるため後続の制御精度を高めていますar5iv.labs.arxiv.org。総じて、近年のT&Rアルゴリズムはロバスト性向上のため特徴記述子の学習的改良、VPRマッチング戦略の高度化、複数経験の管理、フィルタによる誤検出抑制、教示データ取得の最適化など多面的な工夫が凝らされています。

Visual Place Recognitionに用いられる技術

T&Rを支えるVPRモジュールには、時代とともに様々な視覚特徴量・アルゴリズムが使われてきました。代表的な技術を、古典的方法から深層学習時代まで順に解説します。

-

クラシカルな局所特徴: 2000年代から2010年代前半にかけては、SIFTやSURF、ORBといった手工構築型の局所特徴量が主流でした。例えばFurgaleら(2010)はSURF特徴を用いてステレオ画像間および教示画像との特徴点マッチを行い、位置推定に利用しましたarxiv.org。ORBは軽量でリアルタイム性に優れるため、KrájníkらのBearNavシリーズやORB-SLAM2ベースのT&Rarxiv.orgなどで採用されています。局所特徴のマッチングは画像間の相対変化(回転や小さな視点差)には比較的強く、教示経路の反復には有用ですが、照明変化や季節変化には特徴点が一致しないことが多く課題がありました。そこで特徴ベースVPRの文脈では、昼夜や季節で見た目が異なっても一致しやすい特徴の開発が進みました。それが次の深層学習時代の特徴です。

-

NetVLADなどグローバル特徴: VPR研究で画期となったのが、Arandjelovićら(2016)のNetVLAD【ユーザ指定】です。NetVLADは画像全体をひとつのベクトル(VLADベクトル)にエンコードするCNNベースの手法で、場所を識別するグローバル特徴を提供します。季節や天候が異なっても同じ場所の画像は近いベクトルになるよう訓練されており、大規模環境でのループ検出や場所認識に高い性能を示しました。T&Rにおいても、NetVLADのようなグローバル記述子は教示画像中から現在地点に相当するフレームを高速に検索する用途に適します。ただしNetVLAD単体では画像間の細かな位置ずれ(例えば横方向オフセット)までは分からないため、大まかな場所の特定に使い、詳細な制御は別途局所特徴で行うという使い分けが考えられます。このコンセプトはSSM-Navの二段階VPRにも通じており、粗い段階でCNN高次特徴(セマンティック情報重視)を用い、細部比較で局所特徴(空間情報重視)を使う設計はNetVLAD + 局所特徴マッチングに似た役割分担と言えますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。なお、Camaraら(2020)はNetVLADそのものではなく、VGG16ベースのCNN中層から抽出したSpatial & Semantic特徴を利用する独自手法(SSM-VPR)を導入しましたar5iv.labs.arxiv.org。これも畳み込み層の出力を格子状に取り出すもので、NetVLADに比べ空間的対応を保持した特徴と言えます(NetVLADは順序を潰したベクトル化)。このように近年のVPRではCNN由来の高次特徴が重要な役割を果たしています。

-

SuperPoint・D2-Netなど学習型局所特徴: 深層学習はグローバル特徴だけでなく局所特徴検出・記述にも応用されています。代表例がSuperPoint(CVPR 2018)で、これは画像からコーナー等の特徴点とそのディスクリプタを同時に学習で得る手法です。SuperPoint特徴は従来のORB等より環境変化に対して頑健で、対応点抽出にも用いられます。さらに、それら特徴点のマッチングを最適化するSuperGlue(CVPR 2020)というGraph Neural Networkベースの手法も登場し、画像対応付けの精度を飛躍的に向上させました。Sunら(2021)の研究では、このSuperPoint+SuperGlueをベースライン手法の一つとして比較検討していますeprints.whiterose.ac.uk。実験ではSuperGlueを用いた場合も経路追従に成功しましたが、本提案のDarkPoint法に比べ計算が重くリアルタイム性能で劣ること、そして若干ながら追従精度も劣る結果となりましたeprints.whiterose.ac.ukeprints.whiterose.ac.uk。一方、Dusmanuら(2019)のD2-Netarxiv.orgはCNNにより特徴点検出と記述を統合的に学習した手法で、シーンの微細構造に応じたロバストな特徴量を提供します。SSM-Nav2ではこのD2-Net特徴を局所マッチングに採用し、画像間の横シフト算出やVPRの詳細比較に利用していますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。さらにGridseth & Barfoot (2022)はU-Netベースで長期ローカリゼーション向け特徴検出器を学習する試みを報告しておりarxiv.org、このような学習型局所特徴は環境変化や視点変化に強いマッチングを可能にするため、T&Rでも注目されています。

-

シーケンスベース手法: 単一画像ではなく画像シーケンス全体を使って場所認識を行うアプローチもあります。Milford & Wyeth (2012)のSeqSLAMはその代表で、低解像度化した画像の連続フレーム間類似度行列(Sequence Similarity Matrix, SSM)から現在経路と教示経路の対応位置を検出します。Camaraらのグループはこの考え方を発展させ、CNN特徴を用いたSSM-VPRar5iv.labs.arxiv.orgを開発しT&Rに組み込みました。シーケンスマッチングは一時的な画像誤マッチを平滑化する効果があり、短期的外乱(人や車が一瞬横切った等)に頑健性を与えます。一方で計算量は増えるため、実時間性とのトレードオフを考慮した設計が必要です。上述のSSM-Nav系では基本は単フレームVPR+パーティクルフィルタですが、マルチパーティクルによる位置仮説追跡はシーケンス的効果を生んでおり、広義にはシーケンスベース手法と言えますar5iv.labs.arxiv.org。

以上のように、T&Rに使われるVPR技術は時代とともに手法のハイブリッド化が進んでいます。古典的な特徴量と近代的な深層特徴を組み合わせたり、グローバルマッチングとローカルマッチングを段階的に行ったりすることで、それぞれの利点を取り入れていますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。現在では深層学習を活用したVPRが主流となりつつあり、例えば自己教師あり対比学習で得た特徴を使う事例arxiv.orgや、大規模データセットで学習したモデル(例: VGG16やResNet派生)をVPRに転用する手法が多数報告されています。T&R分野でも、これら最新VPR技術を組み合わせることで環境変化への耐性と高精度化が大きく前進しています。

使用されたデータセット・ロボットプラットフォーム

研究ごとに、実証に用いられたデータセットやロボットプラットフォームにも特徴があります。

-

地上走行ロボット: 多くの研究は四輪または履帯式の地上ローバー/UGVで実験されています。Furgaleら(2010)は火星探査を想定し、カナダ・デヴォン島の荒野(火星アナログ環境)やトロント市街地で延べ32kmの走行実験を行いましたfurgalep.github.io。使用したロボットは詳細に記載されていませんが、野外走破性のある実験用ローバー(ステレオカメラ搭載)と推測されます。Clementら(2016)もカナダ・オンタリオ州周辺で合計4km超の走行を記録していますarxiv.org。Sunら(2021)はシェフィールド大学の構内や周辺の屋外環境で昼夜にわたり車輪型ロボット(具体的にはClearpath社JackalやHusky等の小型UGVと考えられる)による走行実験を実施しましたeprints.whiterose.ac.uk。Truhlaříkら(2025)はClearpath Husky A200を用い、屋内の廊下および屋外駐車場コースで経路追従試験を行い、照明条件(明所・暗所)や開始位置ずれ、ロボット速度などを変化させたベンチマークを行っていますar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。この研究では新たに収集した自前の公開データセットを用いており、教示経路(Basic/Advancedの2種類)に対する各手法の追従精度を定量比較していますar5iv.labs.arxiv.org。また、Camaraら(2020)やその関連研究は大学構内の屋内ホールから屋外への出入りといった厳しい照明変化シナリオで実験を行い、教示時と環境が変化してもドア通過が可能な精度を確認していますarxiv.org。これらの実験環境には、市販カメラ搭載の移動ロボットや実験プラットフォームが使われ、実データに基づく評価がなされています。

-

空飛ぶロボット(UAV): T&Rの応用としてドローンへの展開も進んでいます。Warrenら(2019)は高度センサと前方単眼カメラを持つクアッドロータUAVで、教示経路に沿って自律帰還飛行を行う実証を行いましたarxiv.org。GPSが利用できない状況で、離陸地点へ戻る「帰巣」を視覚情報だけで行うもので、森林上空を飛行するシナリオでT&Rの有効性を示しています。また、Truhlaříkら(2025)はDJI Ryze Telloという小型ドローンでSSM-Nav2を試験し、ホバリングしながら進行方向を制御して教示ルート(ホバリング移動経路)を再現する実験をしていますar5iv.labs.arxiv.org。このように、車輪と比べドローンではオドメトリが不正確(あるいは無い)ためビジョンのみで位置を推定する必要がありますar5iv.labs.arxiv.org。SSM-Nav2ではその点を考慮し、オドメトリ非搭載プラットフォームでも動作可能な設計となっていますar5iv.labs.arxiv.org。例えば粒子フィルタの移動モデルにホイール距離でなく一定速度モデルを使うなどの工夫がなされました。Nitscheら(2019)の研究では、Pixhawk搭載のクアッドロータでカメラ+IMUにより教示航路を反復する実験を行っており、VIO(Visual-Inertial Odometry)の助けを借りて安定した飛行が可能なことを示しましたarxiv.org。

-

公開データセット: VPR分野ではOxford RobotCarデータセット(1年にわたり同一路線の都市走行データを収集したもの)やNordlandデータセット(ノルウェーの鉄道を四季で収集)などが知られています。T&R研究でもこれらを用いて長期環境変化下での視覚ローカライゼーションを評価する例がありますarxiv.org。例えばGridseth & Barfoot (2022)はOxford RobotCarのマルチシーズンデータから学習した特徴で長期自己位置推定の精度を検証していますarxiv.org。しかし完全なT&R動作(経路追従制御まで含む)を評価するにはロボット実機での実証が不可欠なため、研究者らはシミュレーションと実機実験を組み合わせて開発を進めています。Truhlaříkら(2025)による新データセットは、複数プラットフォーム・環境での画像シーケンスとオドメトリを含むもので、将来的に外観ベースナビゲーション手法の比較基盤として貢献するでしょうar5iv.labs.arxiv.org。

精度・ロバスト性・環境変化への実験結果

各手法の評価結果を振り返ると、経路追従の精度や頑健性が年々向上していることが分かります。主要な成果をいくつか抜粋して述べます。

-

長距離走行の成功率: Furgaleら(2010)のシステムは延べ32km中99.6%を自律走破しfurgalep.github.io、失敗(オペレータ介入)はわずか0.4%という驚異的な安定性を示しました。最長連続走行距離3.2kmは当時としては桁違いで、視覚のみでこの距離を達成した初例ですfurgalep.github.io。一方、外観ベース初期の手法では数百m規模の評価が多く、例えばSegvićら(2009)は数十m〜数百mの実験経路で成功を報告しています(ただしこの頃は夜間や季節差までは扱っていません)。近年は長距離化が進み、Sunら(2021)は434mの夜間走行でSTROLL法が25%程度で脱落したのに対し、自身の手法は最後まで追従成功と報告していますeprints.whiterose.ac.uk。さらに屋外環境で総計複数kmにわたる実験もクリアしていますeprints.whiterose.ac.uk。SSM-Nav2(Truhlařík 2025)も屋内外での長距離(具体的距離は明記されていませんが、基本・発展の2経路をそれぞれ複数回走行)の安定追従を達成し、既存手法を上回る結果でしたar5iv.labs.arxiv.org。

-

経路追従精度: 精度面では、Furgaleらが約20cm程度の経路復現精度(推定)を示していました。Clementら(2016)はモノカメラでステレオ方式に匹敵するセンチメートル精度を実現したと述べていますarxiv.org。Sunら(2021)は**ATE(Absolute Trajectory Error)やRPE(Relative Pose Error)**を指標に日中・夜間走行を評価し、例えばDarkPoint法の昼→夜走行でATE中央値1.9m・RPE中央値約2°程度、SuperGlue法ではATE中央値4.5mと報告していますeprints.whiterose.ac.uk。DarkPoint法がやや上回る結果で、ゴール到達も問題なく果たしていますeprints.whiterose.ac.uk。SSM-Nav2の評価では、室内経路での横ずれ誤差や完走率でBearNav2や旧SSM-Navより良好な値を示しましたar5iv.labs.arxiv.orgar5iv.labs.arxiv.org。具体的には、暗所スタートや開始位置オフセットを与えた厳しい条件でも、高い再現精度で教示軌道に乗ることを確認しています。総じて最新の手法では、数十cm以下の経路オフセットに抑えつつ完走できるケースが増えており、屋内のドア通過や狭い経路も支障なく走れるレベルに至っていますarxiv.org。

-

環境変化への対応: 照明・季節変化へのロバスト性は本分野のハイライトです。Sunら(2021)は昼間に教示した経路を夜間に全く照明が異なる状況で繰り返し走行し成功させましたeprints.whiterose.ac.uk。同様に、Truhlaříkら(2025)の手法も日中の教示で夜間の走行に耐える結果を示し、「昼夜のシーン変化に対して堅牢」と明言していますar5iv.labs.arxiv.org。季節については、Patonら(2016)が冬と夏の経験を橋渡しに使うデモを行っており、例えば積雪下で教示→雪解け後に走行といったケースでも対応可能性を示しました。経験切替なしで単一路線で季節を超えるのは非常に難しく、現状ではマルチエクスペリエンス地図を併用するか、地道に特徴量を改良し極端な変化にも一致可能にするアプローチ(例: Gridsethら(2022)のマルチシーズン学習特徴arxiv.org)が試みられています。

-

ロバスト性と障害対応: T&Rの信頼性評価として、経路からのわずかな逸脱やセンサ妨害に対する復元力も重要です。最新のシステムはパーティクルフィルタによるロバスト位置追跡ar5iv.labs.arxiv.orgや、復帰モード(Recovery mode)ar5iv.labs.arxiv.orgの実装で一時的な見失いから立て直す仕組みを備えています。たとえばSSM-Navでは、自己位置の不確実性が高まった際に一旦VPRの初期化に立ち戻り再ローカライズを試みるモードがあり、これにより多少コースを外れても自動復帰できるようになっていますar5iv.labs.arxiv.org。Sunら(2021)も走行中に人が横切るなど一時的に特徴が取れない局面で制御が不安定になる問題に対し、視覚とオドメトリを統合した制御でカバーしていますeprints.whiterose.ac.uk。こうした工夫により、実環境で起こり得る予期せぬ事態への対処が徐々に改善されています。もっとも、完全な障害物回避(教示時に無かった障害物を検知して停止・迂回する)はT&Rのスコープ外の場合も多く、静的環境での繰り返し走行を前提としている点には注意が必要です。ただ、一部研究ではLiDARなど他センサを併用して動的障害物に反応するシステムも検討されています。

以上のように、各論文の実験結果からはT&RとVPRの組み合わせにより高精度かつ高信頼な経路追従が可能になりつつあることが読み取れます。当初数十メートル規模だったものが、現在では昼夜・季節を跨ぐ数キロメートルの走行も視野に入っています。以下の表に主要論文の比較をまとめます。

主な研究の比較表

主要な研究について、手法上の特徴や使用技術、実験環境と成果を比較します。

| 研究 (著者, 年, 発表) | Teach & Repeat手法 | VPR/特徴技術 | データセット/プラットフォーム | 精度・ロバスト性の結果 | 従来手法との比較・特記事項 |

|---|---|---|---|---|---|

| Furgale & Barfoot (2010, JFR)furgalep.github.iofurgalep.github.io | 位置ベースT&R。ステレオカメラによるVOで局所サブマップ連結。3D位置推定し局所平面に投影して追従furgalep.github.io。 | SURF特徴arxiv.org+ステレオマッチング。特徴点マップをサブマップとして保存。 | カナダ北極圏デヴォン島 & 都市環境。4輪ローバー, ステレオカメラ。 | 32km中99.6%自律走破、最大3.2km連続走行成功furgalep.github.io。非GPSで数km規模走行実証は初。 | SLAM無しで長距離可能なことを証明。従来(Royer2007等)より桁違いの距離。課題: 教示経路以外は走行不可。 |

| Clement et al. (2016, FSR)arxiv.orgarxiv.org | 位置ベースT&R(Barfoot系)。単眼カメラ+路面平面仮定で絶対スケール獲得。特徴点マップで経路保持。 | おそらくSURF/ORBなど従来特徴。モノクロVO+既知カメラ高さでスケール推定arxiv.org。 | 屋外非整地路や草地など4.3km分。小型UGV(爆発物処理ロボ想定)。 | ステレオ方式と同等のセンチメートル級精度達成arxiv.org。非平坦地形でも精度低下なし。 | 単眼のみで高精度を実証。追加ハード不要の利点。課題: 照明/季節変化には未対応(単一環境)。 |

| Paton et al. (2016, IROS)arxiv.org | 位置ベースT&R拡張。マルチエクスペリエンス地図で複数環境の特徴点マップを管理し、適宜切替。 | FAB-MAP等BoWベースのループ閉じ検出を応用か。マップ間の外観類似度評価で最適経験選択。 | ウィンター&サマーなど季節別データを収集(トロント周辺)。Clearpath Grizzly等。 | 季節変化で従来は失敗する場面をマップ切替で走破。外観ギャップを軽減。 | 単一地図に比べ大幅にロバスト。ただし複数地図管理のメモリ・整合性課題あり。 |

| Camara et al. (2020, IROS)ar5iv.labs.arxiv.orgarxiv.org | 外観ベースT&R「SSM-Nav」。CNN特徴でVPRし、PFで経路上位置推定。画像間シフト算出でリアクティブ制御。 | SSM-VPR(VGG16中間特徴)。2段VPR+局所CNN特徴でシフト計算ar5iv.labs.arxiv.org。 | 屋内ホール⇔屋外庭など明暗差大の経路。Clearpath Husky等 4輪+前方カメラ。 | ドア通過可能な精度で室内外連続走行成功arxiv.org。照明変化下でも安定走行。 | 深層VPR活用の初事例。従来ORB系より認識精度向上。PF統合で誤検出低減。 |

| Sun et al. (2021, IROS)eprints.whiterose.ac.ukeprints.whiterose.ac.uk | 外観ベースT&R。単眼+自己学習特徴+視覚制御統合。現在特徴と教示特徴マッチングでPI制御補正。 | DarkPoint(自己教師型深層特徴)。SuperPoint+SuperGlueとも比較eprints.whiterose.ac.uk。 | 英国Sheffield屋外コース(昼→夜)。4輪ロボット (差動二輪 or Skid)。 | 昼教示→夜走行に成功eprints.whiterose.ac.uk。ATE中央値1.9mで完走、SuperGlue法より高精度eprints.whiterose.ac.uk。 | 外観変化に単一地図で対応。既存手法(STROLL等)は夜間で脱落eprints.whiterose.ac.uk。課題: 動的物体の影響。 |

| Truhlařík et al. (2025, 未刊)ar5iv.labs.arxiv.orgar5iv.labs.arxiv.org | 外観ベースT&R「SSM-Nav2」。CNN局所特徴+改良シフト推定。マルチプラットフォーム対応設計。 | SSM-hist法(SSM-VPR改良版)。D2-Net特徴でヒストグラムマッチar5iv.labs.arxiv.org。 | 新公開データセット (室内廊下・屋外駐車場)。Husky A200 & Telloドローン。 | 既存法を複数シナリオで上回る精度ar5iv.labs.arxiv.org。屋内外・昼夜で頑健。UAVでも動作確認。 | 外観ベース最新。公開データで定量比較実施。従来BearNav等より高精度。課題: 論文発表待ち。 |

(表中の課題や備考は論文内で言及されたもの、および本回答作成時点での一般的評価に基づく)

従来のSLAM手法との比較・メリットと課題

Teach & Repeat vs SLAM: 最後に、T&R+VPR方式と従来のSLAMベース航法との比較について述べます。それぞれのメリットと課題を整理すると以下のようになります。

-

メリット (T&R): T&Rは経路に特化しているため問題設定が簡素で、SLAMのように全方位の環境地図を構築維持する必要がありませんeprints.whiterose.ac.uk。その分、計算資源やメモリ消費が低く、長距離でも誤差が蓄積しにくい特徴があります。特に外観ベースT&Rでは地図ずれ問題が事実上なく、カメラと最低限のオドメトリがあれば実装可能なのでコスト面でも有利ですar5iv.labs.arxiv.org。実際、近年の研究では小型ロボットにスマートフォン級カメラを搭載しただけで、昼夜問わず安定走行できることが示されていますeprints.whiterose.ac.ukeprints.whiterose.ac.uk。また、T&Rは定型業務への応用(工場内の繰り返し搬送、警備巡回など)に適しており、経路を一度教えれば学習データとして使い回せる利点がありますar5iv.labs.arxiv.org。複数ロボットで同じ経路を共有することも可能で、教示データを配布するだけで全ロボットが自律走行できるというスケーラビリティもありますar5iv.labs.arxiv.org。さらに、SLAMが苦手とする大規模環境での全球的位置推定やループ検出を、T&Rでは経路沿いの局所マッチングに置き換えるため、外乱光や単調な景色でも追従できる場合がありますeprints.whiterose.ac.ukeprints.whiterose.ac.uk。例えばGPSの届かない地下や惑星表面で、事前に教示走行したルートを辿る用途にT&Rは最適とされていますfurgalep.github.io。

-

メリット (SLAM): 一方、従来SLAM(特に地図ベースナビゲーション)はロボットに柔軟性を与えます。地図さえ構築すれば、教示経路以外でも地図内のどこへでも移動経路を計画でき、動的に目標地点を変えることが可能です。T&Rは往々にして「決められた道をなぞる」だけなので、新たな行先には対応できません(経路ごとに教示が必要)。SLAM地図があれば、障害物を回避して少し迂回したり、最適経路に切り替えたりといった自律的な判断ができます。また、SLAMにより得られる地図は人間が解釈可能(例えば建物内の間取りや道路地図)であり、ロボットの説明可能性や他システムとの連携に有用です。T&Rのデータ(単なる画像シーケンスや特徴点マップ)は人には扱いづらく、用途が限定されます。

-

課題 (T&R): T&R方式の課題はまず環境変化への弱さでした。しかしこの点は上述のとおりマルチエクスペリエンスや深層特徴により大きく改善されました。残る課題は汎用性の低さです。すなわち、未知の経路をその場で探索する能力が無いこと、教示データのない経路は走れないことです。地図が無い分応用範囲が限定され、配送ロボットなどに用いる場合も、人が一度全経路を走らせて学習させる手間がかかります。また教示時と比較して構造的変化(道路工事で迂回が必要、家具の配置が変わった等)に遭遇すると対処できません。SLAMであれば地図を更新しながら新経路を計画できますが、T&Rは本質的に「同じ場所を辿る」動きしかできないためです。このためT&Rは工場内物流や定期巡回など構造があまり変わらない定常環境に向いています。

-

課題 (SLAM): SLAM側の課題としては、ビジュアルSLAMでは未だ長期安定性に課題があることが挙げられます。大域地図を維持するにはループ検出と誤差調整が不可欠ですが、環境が大きく変わるとループ検出自体が困難になります。T&Rでは経路ごとに独立したマップ(または画像メモリ)を持つため、グローバル整合性を捨ててでも局所的一貫性を優先できますeprints.whiterose.ac.uk。結果として、古い地図に固執せず常に最新の教示データを使う運用もしやすいという利点があります。SLAM地図は更新コストが高いですが、T&R教示は人がロボットを走らせれば済むため、ある意味リセット&再学習が容易です。このフレキシブルさは長期運用で重要です。また、SLAMはセンサ融合やパラメータ調整が複雑で専門知識が要りますが、T&Rはカメラ一つでも動くシンプルさが売りです。

以上をまとめると、T&R+VPRは特定経路における信頼性と簡易性を追求した方式であり、SLAMは汎用環境地図による柔軟性を追求した方式と言えます。用途によって適材適所であり、頻繁に通る巡回路が決まっているならT&Rが効率的で、未知環境の探査や地図生成が必要ならSLAMが必要です。

最後に、近年はいわゆるTeach-Repeat-Replanのように、教示経路をベースにしつつ動的に経路を最適化・変更するハイブリッドも模索されています。また、T&Rシステム自体に自己学習機能を持たせ、走行中に環境変化を学習して次回以降に活かすといった発展(「Teach, Repeat and Learn」arxiv.org)も検討されています。今後、Teach & RepeatとVisual Place Recognitionの組み合わせは、長期自律移動ロボットの有力な解法としてさらなる応用展開が期待されます。

調査してもらった論文とわたしのSCOUTプロジェクトの手法のと類似点や異なる点を教えてください

あなたのSCOUTプロジェクトと、調査で取り上げたTeach & Repeat + VPR 論文群との類似点と相違点を以下に整理しました。✅ あなたのSCOUTプロジェクトの特徴(再掲)

以下のような思想と技術的特徴がありました():- SLAMやオドメトリに頼らず、景色の一致度に基づく走行

- Teach & Repeat(教示→再走行)をベースに

- VPR(Visual Place Recognition)で景色の類似度を測る

- NetVLAD、SuperPoint、DINO、CLIP、Cosine類似度などを検討

- カメラ+Linux+ROS1環境を活用、SCOUTに最適化

🔗 類似点(あなたの構想と一致する重要要素)

| 項目 | あなた | 論文(例:SSM-Nav, DarkPoint, Furgaleなど) | コメント |

|---|---|---|---|

| Teach & Repeat | ✔ | ✔ | 中核の構成が一致(Camara 2020, Sun 2021 など) |

| VPRベースの自己位置推定 | ✔ | ✔ | 全論文で視覚的場所認識を活用 |

| SLAMを使わない・地図不要 | ✔ | ✔ | Furgale以外ほぼすべてが非SLAM型 |

| カメラ中心のセンサ構成 | ✔ | ✔ | 多くが単眼またはステレオカメラのみで構成 |

| 深層学習特徴をVPRに活用 | ✔ | ✔ | SuperPoint, NetVLAD, DarkPoint, D2-Net など多数 |

| 横方向オフセットの検出と追従制御 | ✔ | ✔ | SSM-Navは画像間ピクセルシフトで制御 |

| “景色を見て走る”という人間的発想 | ✔ | ✔ | Sun 2021 や Krájník らの理論と重なる発想 |

| Linux+ROS環境前提の実装想定 | ✔ | ✔ | 多くがROSベースでClearpath Huskyなど使用 |

| SLAM不要でも安定走行 | ✔ | ✔ | SLAMより安定(STROLLとの比較など) |

🔍 相違点(異なる点・補強ポイント)

| 観点 | あなた | 論文群 | コメントと示唆 |

|---|---|---|---|

| 経路追従の制御方法 | 明確に言及なし(?) | 多くが画像間横ずれ検出+PI制御(SSM-Nav, Sunら) | 実装時には「横ずれ → ハンドル角」制御設計が要 |

| 画像の記録間隔 | 記述なし | 適応的(曲がり角密、直線疎)など工夫あり | 教示画像の最適配置戦略を検討すると良い |

| 教示画像の選択方法 | 明記なし | 粗検索→再ランク(2段VPR)、パーティクルフィルタ | あなたの設計でも類似の段階的マッチングが有用 |

| 昼夜・環境変化への対応 | 特に未記述 | DarkPoint, D2-Net, マルチ経験などで対応 | VPRの頑健性に注意、CLIPやDINOは強力な可能性あり |

| パーティクルフィルタなどの仮説追跡 | 言及なし | SSM-NavやSunらでは標準搭載 | VPR誤マッチ回避のため有用(導入を検討) |

| エラー回復(リカバリ)機能 | 明示されていない | 多くの論文で位置喪失時の再初期化あり | 実機運用では必須機能、リカバリ処理の設計検討を推奨 |

| 実験の実施環境 | SCOUTという個別ロボット | Clearpath Husky、Jackal、Tello等 | SCOUTでの実装・実証に向けた工学的調整が必要 |

✨ 特筆すべき一致点:思想レベルでの合致

Nicole氏の「地図不要/ランドマークベース」思想と同様に、 多くの論文(特にCamara 2020、Sun 2021、Truhlařík 2025)は **「人間のように景色で判断するロボット」**を目指しており、あなたのプロジェクトと本質的に一致しています。💡 提案:あなたの構想を論文的に整理するなら?

論文形式にするなら、次のような軸で整理できます:- Motivation(なぜSLAMでなくTeach & Repeat + VPRか)

- Platform(SCOUTの制限:オドメトリ、IMU、センサ構成)

- Method(教示方法、VPR方式、制御方法)

- Implementation(使用モジュール、ROSノード構成など)

- Evaluation(マッチング精度、経路追従、夜間再現など)

- Comparison(SLAM・ORB-SLAM2などとの比較)

さらに深く比較・分析したい場合は:

- あなたの手法を「SSM-Nav2」と並べて図解比較

- 「あなたの構想の特徴 → 各論文との対応マッピング」

地図保持の利点、不利な点を教えてください

地図(マップ)を保持することには、自律移動ロボットにおいて大きな利点と明確な不利な点があります。以下に「利点」「不利な点」「使いどころ」まで整理して解説します。✅ 地図を保持する利点(使う理由)

| 利点 | 説明 |

|---|---|

| ① 任意の経路に対応可能 | 地図があれば、目的地に応じて**自由に経路計画(Path Planning)**ができる。→ SLAMやHDマップを使う方式(Waymo等)では、行き先をその場で変えられる。 |

| ② 動的障害物の回避が可能 | 地図+センサで現在の障害物を検出し、リアルタイムに最適経路へ再計画できる。 |

| ③ 自己位置をグローバルに推定できる | 地図上で**今自分がどこにいるか(6DoF)**を絶対的に把握できる。 |

| ④ センサフュージョンがしやすい | カメラ、IMU、LiDAR、GNSS等の情報を地図上で統合・補正できる(エラー低減)。 |

| ⑤ 人と共有・可視化しやすい | 地図は人間にも理解できる形(2D/3D構造)で、ロボットの動作説明やシステム統合に便利。 |

| ⑥ 地図ベースのナビ(GPSや地名指定)に対応 | 外部地図と連携すれば、「AビルからB通用口へ」などの指示が可能になる。 |

⚠️ 地図を保持する不利な点(やらない理由)

| 不利な点 | 説明 |

|---|---|

| ① 初期構築が大変(SLAMコスト) | 正確な地図を作るには**高精度センサ or 初期走行(SLAM)**が必要で、設計・運用コストが高い。 |

| ② 環境変化に弱い(地図が古くなる) | 家具の配置、工事、天候、季節変化などで地図と現実がズレる → エラーの元。 |

| ③ センサキャリブレーションが重要 | 地図を信頼するには、カメラ、IMU、LiDARの整合性と精度が不可欠。 |

| ④ 計算リソースとメモリ消費が大きい | 地図保持には高性能コンピュータと大容量メモリが必要(特にHDマップ系)。 |

| ⑤ 地図依存のブラックボックス化 | 地図がブラックボックス化すると、動作が「なぜそうなったか」追跡しにくくなる(特にNNマップ)。 |

| ⑥ 教示が不要にならない | 実は地図作成自体に人の手や走行が必要なため、完全なTeach不要にはならないことも。 |

📌 地図あり/なしの選択の指針

| 条件 | 向いている方式 |

|---|---|

| 「未知の目的地に動的に行きたい」 | ✅ 地図保持(SLAMやHDマップ) |

| 「人の指示で柔軟に移動したい」 | ✅ 地図保持(ナビ・UIとの連携) |

| 「決まった経路を何度も走りたい」 | ✅ 地図なし(Teach & Repeat) |

| 「軽量な構成で低コストにしたい」 | ✅ 地図なし(視覚ベースT&R) |

| 「環境が頻繁に変わる」 | ✅ 地図なし(地図を信じない) |

🧠 あなたのSCOUT構想との関係

あなたの構想では:- SLAMは地図精度が信用できない(SCOUTのオドメトリ誤差など)→ 地図非依存が前提

- Teach & Repeat + VPR で “見た目”を頼りに走行する

- ⇒ 地図を持たない代わりに景色の“似ている度”で自己位置を判断

ご希望があれば、次に:

- あなたのプロジェクトの思想を反映した「地図 vs 非地図」比較表

- 地図なしのナビを他応用に展開するシナリオ

Teslaの自動運転方式(FSD)の技術と仕組み

センサー構成と「Tesla Vision」への移行

Teslaの自動運転ハードウェアは、カメラ中心のセンサー構成が大きな特徴です。具体的には車体の周囲に8台の外部カメラを配置し、広範囲を撮影しています(フロント3台、左右Bピラー各1台、左右フェンダー各1台、リア1台)tesla.com。加えて、以前は前方にレーダー(ミリ波レーダー)とバンパー周囲に超音波センサー(USS)12個も搭載していましたが、2021年以降この方針を大きく転換しました。2021年にModel 3/Yからレーダーを撤廃しカメラのみの「Tesla Vision」方式へ移行、2022年には高級モデルS/Xからもレーダーを除去していますtesla.com。さらに2022年後半にはModel 3/Yの新生産車で超音波センサーも廃止し、カメラのみで環境認識を行う体制へ踏み切りましたtesla.com。このように現在のTesla車はLiDAR(レーザーセンサー)を一切搭載せず、視覚情報主体で自動運転を実現する構成になっていますtanaka-preciousmetals.comtanaka-preciousmetals.com。実際、TeslaのAI担当だったアンドレイ・カルパティ氏も「高価で維持が難しい高精度LiDARマップに頼るのはスケーラブルでない」と述べ、コスト面・汎用性の面からカメラのみの純粋なビジョンアプローチを推進していますtanaka-preciousmetals.comspectrum.ieee.org。

なおTeslaはレーダー撤廃の理由について、十分訓練したディープラーニング視覚システムの方がレーダーより精度が高く、むしろレーダーがノイズ源になり始めたためだと説明していますtanaka-preciousmetals.com。事実、約1.5ペタバイトもの映像データとレーダーデータで学習した結果、カメラ視覚のみのシステムが旧来のレーダー併用方式を大きく上回る性能に達したためと報告されていますspectrum.ieee.org。Teslaは視覚ベースに舵を切った後も、安全性能評価でレーダー搭載車と同等以上の結果を達成し、歩行者AEB(自動緊急ブレーキ)の性能向上も示していますtesla.com。このように**「Tesla Vision」とは、カメラ映像とAIだけで周囲認識・運転制御するTeslaの戦略を指し、近年のハードウェア刷新もそれに沿ったものです。もっとも2023年以降の最新ハードウェア(通称HW4)では新型の高解像度レーダーが一部再導入されており、Model S/Xではレーダーが復活したとの報告もありますedge-ai-vision.comedge-ai-vision.com。ただし基本的な方針としては引き続きカメラ主導の視覚認識**を核とし、補助的に新レーダーを活用する方向とみられます。

Tesla車における外部カメラ配置の例(Model 3)。合計8台のカメラで車両周囲をモニタリングする。tesla.com

自己位置推定(ローカリゼーション)と経路追従の方式

自己位置の推定には、Teslaは従来のSLAM(自己位置推定と同時マッピング)や高精度地図による手法ではなく、ビジョンベースの手法を採用しています。一般的な自動運転車(例:WaymoやCruise)は、走行エリアを事前にレーザースキャンしてHDマップ(高精細3D地図)を構築し、その地図上で車両の位置を高精度にローカライズしますtanaka-preciousmetals.comwaymo.com。対してTeslaは事前のHDマップを持たず、「その場で初めて見る道路」であっても8台のカメラ映像だけで車線や信号、標識などを検知し、自車位置を把握して走行しますtanaka-preciousmetals.com。カルパティ氏は「Tesla車では全てがカメラ映像からリアルタイムに判断され、既知の地図情報に頼らない」と述べておりtanaka-preciousmetals.com、実際Tesla車はGPS地図は経路案内程度に留め、詳細な道路形状は走行中に視覚から推定しています。例えばTeslaは簡易な「マップコンポーネント」として道路の基本的形状データ(地形や道路の位置)は使用しますが、HDマップではないため「どの車線がいつ途切れるか」といった細部は事前には分からないと説明されていますlowcarb.style。このためTesla車はカメラで認識した車線やランドマークをもとに自らの位置を逐次更新し、必要に応じて道路上の目印(車線線形や標識の位置関係など)で補正を行いながら走行しています。

経路追従・走行経路の計画についても、TeslaはAIを活用したユニークなアプローチを取っています。自動運転システムは周囲環境を認識したうえで、進むべき軌道(trajectory)をリアルタイムに計画し車両を制御します。TeslaのFSDソフトウェアでは、かつては物理モデルに基づく経路最適化を用いていましたが、現在は「ニューラルプランナー」と呼ばれる学習ベースの経路計画に移行しましたarmand.so。これは膨大な人間ドライバーの運転データやオフライン最適化解を教師として訓練された軽量ニューラルネットワーク群で、これにより従来より桁違いに高速(100マイクロ秒単位)で意思決定を行うことが可能になったと報告されていますarmand.so。具体的には、Teslaのプランニングシステムはまず「インタラクションサーチ」により周囲の車線構造や各オブジェクトの占有状況・動きを分析しますlowcarb.style。そして歩行者や他車両との衝突リスクを避ける複数の候補経路をシミュレーションし、その中から安全かつスムーズな軌道をニューラルネットワークで瞬時に評価・選択しますarmand.solowcarb.style。選ばれた軌道はさらに衝突チェックや乗り心地評価、介入(ドライバー介入)の可能性など複数の基準でスコアリングされ、最終的なハンドル・速度制御に反映されますarmand.so。このようにTeslaはモジュール構成は維持しつつ、その各所に機械学習を深く取り入れたハイブリッド方式と言えます。完全なEnd-to-Endで画像から直接ハンドル操作を出力するのではなく、認識した周辺状況(車線、物体、空間)の中でAIが最適な走行パスを導出し、それを車両制御に繋げる形になっています。

Occupancy Networkとディープラーニングの活用

Teslaの自動運転技術の中核には、高度なディープラーニングによる知覚(Perception)システムがあります。その最新のキーコンポーネントが「Occupancy Network(オキュパンシーネットワーク)」と呼ばれるニューラルネットワークです。Occupancy Networkは平たく言えば、車載8カメラのビデオストリームから周囲環境を3次元的に再構築し、空間のどこに何が存在するかを高精度に推定するネットワークですarmand.sotesla.com。従来の物体検出アルゴリズムではカメラ画像ごとに物体の種類や位置(矩形)を認識するのが一般的でした。しかしそれでは「データセットに無い未知の物体」が検出できなかったり、物体の高さやオーバーハング(せり出し部分)が考慮できないといった限界がありましたthinkautonomous.aithinkautonomous.ai。TeslaのOccupancy Networkはこれを刷新し、シーン全体を細かなボクセル(3Dグリッド)空間に区切って各セルの占有/非占有を予測しますthinkautonomous.ai。これにより物体のクラスに依存せず「何か物体が存在する空間」そのものを捉えるため、たとえ未知の物体でも空間的な存在として検知可能です。また各物体は固定サイズの矩形ではなく、ボクセルの集合として表現されるため、例えば車の屋根に積まれた梯子のような突出部も見逃さず捉えられますthinkautonomous.aithinkautonomous.ai。さらにマルチカメラの映像を統合した鳥瞰視点のボリューム表現となっているため、一部がカメラに隠れた物体(他車に隠れた歩行者など)でもボクセル空間内で連続的に推定できます。

Teslaは2022年に超音波センサー廃止とともにこのビジョンベースOccupancy NetworkをFSDベータに導入し、これが従来のセンサー入力に代わって高精度な空間認識を実現したと述べていますtesla.com。同ネットワークによりオートパイロットの空間ポジショニング精度が向上し、より遠方まで見通した物体識別が可能となったとのことですtesla.com。実際TeslaチームはこのOccupancy Networkを「物理世界をモデル化する解決策」であり「コンピュータビジョンの未来となるアーキテクチャ」だと位置づけていますarmand.so。8カメラから得た映像をわずか10ミリ秒程度のレイテンシで処理しarmand.so、車両周囲の自由空間と障害物を高解像度で把握するこのシステムによって、Teslaはセンサー削減のハンデを補いつつあると言えます。さらにOccupancy Networkは動的物体の将来位置(軌道)予測も組み込んでおり、静止物体と動く物体を区別しながら先読みする能力がありますarmand.so。これは後述する経路計画(プランニング)にも活用され、他車や歩行者の動きを予測した上で自車の安全な走行パスを決定するのに寄与しています。

Teslaのディープラーニング活用はこれだけに留まりません。Tesla社は公式に「知覚から制御までの問題にディープニューラルネットワークを適用し、最先端のAIアプローチでオートパイロットを開発している」と述べていますtesla.com。各カメラごとに画像セグメンテーション・物体検出・単眼画像の距離推定を行うネットワークを持ち、さらに全カメラの映像を統合して道路レイアウト・静的インフラ・立体物体を鳥瞰ビューで出力するネットワークも開発していますtesla.com。実際、Autopilot用のニューラルネットワーク群は合計48ものモデルで構成され、推論時には各時刻に1000個以上のテンソル(予測結果)を出力しているといいますtesla.com。これら大量のモデルを訓練するため、Teslaは社内に世界有数のスーパーコンピュータを構築し、日々車両から収集される数百万本の動画クリップを自動ラベル付け・学習するデータエンジン体制を敷いていますspectrum.ieee.orglowcarb.style。このようにハードウェア設計(専用FSDチップ)からソフトウェア・AIアルゴリズム、データインフラまでを垂直統合し、大規模なディープラーニングで自動運転を進化させている点もTesla方式の大きな特徴です。

高精度マップへの依存度と運用戦略

前述の通り、Teslaは高精度なHDマップへの依存を極力減らす戦略を採っています。他社の自動運転では、高解像度3Dマップにあらかじめ道路の車線や標識位置を全て織り込んでおき、車両は走行中常にその地図上のどこにいるかを照合しますwaymo.com。これは自己位置精度を高め不確実性を減らす利点がありますが、地図の作成・更新に莫大なコストと手間がかかりますtanaka-preciousmetals.com。カルパティ氏も「全ての走行エリアで高精度地図を収集・維持するのは非現実的だ」と指摘しておりtanaka-preciousmetals.com、Teslaはこの地図整備を前提としない方式で世界中どこでも機能する自動運転を目指していますtanaka-preciousmetals.com。そのためTesla車は地図に無い新しい道路標識や信号にも柔軟に対応でき、仮に工事等で道路構造が変わっていてもカメラから得た最新の視覚情報に基づいて即座に判断を下せるメリットがあります。もっとも一般的なナビ用途には標準的な地図データを使いルート案内を行いますが、それも補助的な位置合わせに留め、走行環境の細部認識はリアルタイムのニューラルネットワーク推論に依存していますlowcarb.style。

一方で高精度地図に頼らないことのハードルも存在します。車線消失や見通しの悪い交差点などでは、先の状況を推測しなければならず、地図でそれが分からないTeslaのAIはカメラ映像から先読みする工夫を凝らしていますlowcarb.style。たとえばカーブの先の道路形状を推定する「車線予測」機能や、見えない先の信号の存在を推定する機能など、人間ドライバーのような予測運転をネットワークに学習させていますlowcarb.style。このように地図レス方式は技術的難易度が高い反面、環境変化への適応力とスケーラビリティに優れており、Teslaはクラウド経由のOTAアップデートで日々ソフトウェア精度を向上させながら、人間と同等の認識能力を持つAIドライバーの実現を目指しています。

他メーカー(WaymoやCruiseなど)との方式比較

Teslaのアプローチは、自動運転業界の中でも異色であり、WaymoやCruiseといった他社とはセンサー構成からマップ戦略まで大きく異なりますspectrum.ieee.org。以下に主な違いをまとめます。

-

使用センサーの種類と数: WaymoやCruiseの自動運転車は通常、車体上部に回転式の3D LiDARを搭載し、周囲360度の高精度点群データを取得します。加えて複数の長短距離レーダーや高感度のカメラも組み合わせ、冗長なマルチセンサーフュージョンで周囲環境を検知しますspectrum.ieee.orgwaymo.com。例えばWaymoの車両(Jaguar I-PACEベース)には29台ものカメラが搭載され360°視界をカバーし、LiDARは昼夜を問わず周囲の立体形状を把握、レーダーは雨や霧でも他車の速度を正確に測るなど、それぞれのセンサーの長所を活かしていますwaymo.comwaymo.com。一方Teslaは上述のようにカメラ(現在は8台)主体でLiDAR非搭載、レーダーも一時廃止するなどセンサーを極力絞った構成ですspectrum.ieee.org。これはハードウェアコストを抑え全車両に配備できる規模拡大性と、シンプルなセンサースイートで膨大な車両データ収集を行うフリート学習戦略によるものですspectrum.ieee.org。カメラ以外に頼らない分、Teslaは膨大な走行データからAIを鍛え上げることで性能向上を図り、他社は高性能センサーによる精度確保と限定地域での慎重な運用で安全性を担保する、といった対照的な手法を取っています。

-

高精度マップの活用: Waymoでは新たな地域でサービス開始する前に専用車両で隅々まで走行し、あらゆる車線や標識、路面の詳細をHDマップとして記録しますwaymo.com。走行時はその地図とLiDARスキャンをリアルタイムで照合することで、誤差数センチ以下の自己位置特定を実現していますwaymo.com。Cruiseも同様に詳細地図を用意した都市エリア(例:サンフランシスコ市内)で無人タクシー運行を行っています。対するTeslaは地図に頼らないビジョン認識を旨とし、未知の道路状況でも対応できる汎用性を優先していますtanaka-preciousmetals.comtanaka-preciousmetals.com。この違いにより、WaymoやCruiseの車は運用可能エリアが高精度マップ整備済みの地域に限定されますが、そのエリア内ではドライバーレス(完全自動運転)を実現しています。一方Teslaは地図整備不要のアプローチで世界中の道路に適応可能と謳うものの、現時点(2025年)ではドライバーの監視下での「FSDベータ」提供に留まり、真の無人運転は今後の課題となっています(これは技術の優劣というより安全ポリシーや規制上の違いによる部分も大きいです)。

-

システムアーキテクチャ: WaymoやCruiseは典型的には、「センサー融合による周辺知覚」→「他交通主体の動き予測」→「ルールベースのプランニングと制御」というモジュール分割型のソフトウェア構成ですwaymo.comwaymo.com。これに対しTeslaは、従来型の分割アーキテクチャを踏襲しつつも、占有空間推定や経路計画など多くの部分でエンドツーエンド学習の成果を取り入れた設計になっていますarmand.soarmand.so。例えば前述のOccupancy Networkによる環境再構築や、人間ドライバーのデータから学習したニューラルプランナーによる経路決定など、AIが判断する範囲を増やしている点が特徴です。そのぶんテスト走行から集めるデータとシミュレーションでカバーすべきシナリオは膨大になりますが、Teslaはコスト増となるセンサーに頼る代わりにデータと計算資源を投入してAI精度を高める戦略を取っていると言えますspectrum.ieee.orgspectrum.ieee.org。

以上のように、Teslaの自動運転方式は**「カメラ+AI中心で地図に頼らない汎用路線」であり、WaymoやCruiseは「高性能センサー+HDマップによる限定域特化路線」**と整理できます。それぞれメリット・デメリットがありますが、Teslaは自社の大量生産車に搭載できる現実解としてビジョンAIに賭けており、公式にも「高度なAIによるビジョン&プランニングこそがフルセルフドライビング実現への唯一の方法だ」と表明していますtesla.com。今後、Teslaがこのアプローチで真の自動運転(レベル4/5)を汎用的に実現できるか、あるいは他社方式との収れんや融合が起こるのか、引き続き注目されています。

参考資料: Tesla公式サポート記事tesla.comtesla.com、Tesla AI Dayプレゼン資料armand.soarmand.so、カルパティ氏講演解説tanaka-preciousmetals.comtanaka-preciousmetals.com、Waymo公式サイトwaymo.comwaymo.comほか。

Teslaの自動運転方式(FSD)の技術と仕組みとSCOUTプロジェクトを比較してください

以下に、TeslaのFSD(Full Self-Driving)方式と、あなたのSCOUTプロジェクトにおける視覚ベースTeach & Repeat + VPR方式の違いや類似点を比較表にまとめた上で、設計思想の差異も含めて詳しく解説します。🚗 Tesla FSD方式 vs 🛰️ SCOUTプロジェクト 方式:比較表

| 項目 | Tesla FSD方式 | SCOUTプロジェクト(Teach & Repeat + VPR) |

|---|---|---|

| センサ構成 | カメラ8台+一部車種に高解像度レーダー(HW4)※LiDAR・超音波センサは基本非搭載 | モノカメラ(単眼) or 少数カメラ+オドメトリ(IMU/エンコーダ) |

| 自己位置推定 | Occupancy Networkで空間占有を3D推定(地図非依存) | Visual Place Recognition(VPR)で画像の類似度から場所推定 |

| 地図(HD Map等) | 使用しない(高精度地図に非依存) | 使用しない(Teach走行記録に基づく) |

| 経路計画 | Occupancy+他車挙動からニューラルプランナーが最適軌道を出力(複雑) | 教示走行の再現をベースとした定軌道追従(比較的シンプル) |

| 周囲認識 | 物体検出+セグメンテーション+3Dボクセル占有空間(DLベース) | 周囲物体は主に障害物として扱い、回避は構成依存(オプション) |

| データベースとの照合 | Occupancy推定と時系列認識で空間モデル生成(走行経験不要) | Teach時に記録した画像列とリアルタイム画像を照合 |

| 学習方式 | 数億km走行データから大規模学習(End-to-End一部採用) | 少量データ(1ルート)に対してルート記録と再現に特化 |

| 対象環境 | オープン環境(都市部、郊外、未知の道路) | 限定環境(工場・倉庫・屋外敷地など繰り返し利用) |

| 対応柔軟性 | 動的環境にリアルタイムで適応、初見の道路も対応 | あらかじめTeachしたルートの再現性が高いが汎化は限定的 |

| 強み | AIベースで人間のように運転意図を模倣、動的交通に適応可能 | 軽量構成、高信頼性、事前Teachがあれば精密な再現が可能 |

| 弱み | ハード/ソフトが高度・重く、演算資源と訓練データが膨大 | 初回Teachが必須で経路変更に弱い、地図なしのリカバリ困難 |

🚀 設計思想の違い

| 観点 | Tesla(FSD) | SCOUT(Teach & Repeat) |

|---|---|---|

| スケーラビリティ | 世界中の道路を汎用AIで走れるようにする | 限られた空間を効率的・安全に再現走行する |

| 適応能力 | 「初めて走る道でも走れる」ことを重視 | 「一度走った道を正確に繰り返す」ことを重視 |

| マップ依存性 | 完全に排除(Occupancy Networkが即時構築) | マップ代わりにTeach画像列を蓄積して照合 |

| 学習戦略 | 超大規模データ(FSDベータ)でAIが人間運転を模倣 | 局所データ(ルート記録)を人手で構築し照合推定 |

🎯 SCOUT方式の優位性(FSDとの比較)

- 軽量構成でも精度が出る:Teslaは巨大な演算資源(FSDチップ+Dojoクラスタ)に支えられているが、SCOUTはRaspberry Piなどの組込でも構築可能

- Teachさえしておけば確実に再現:Teach & Repeatでは未知環境での適応は弱いが、既知経路の再現性・安定性はFSDより高い場合も

- 限定空間に特化した信頼性設計:屋外工場、敷地内走行、軌道経路が固定の搬送に極めて強い

- 学習不要・ブラックボックスでない:Deep Learning不要な構成でデバッグ・因果推論が容易

⚠️ SCOUT方式の限界点(FSDに比べて)

- Teach走行が必須:Teachされていないルートは走れない(即時経路生成できない)

- 動的環境変化への弱さ:新たに障害物が出現した場合、経路再計画が困難(避ける仕組みは個別実装必要)

- 経路の切り替え・柔軟性に乏しい:地点指定や目的地変更に対応できる設計がない限り難しい

🧭 結論と整理

| 総合評価 | Tesla FSD | SCOUT方式 |

|---|---|---|

| 世界的な一般道対応 | ◎ | ✕ |

| 限定空間での安定運用 | △(過剰) | ◎ |

| 初期構築コスト | 高 | 低〜中 |

| 技術難易度 | 非常に高い | 中程度 |

| 軽量化・組込向き | ✕ | ◎ |

| 透明性と制御性 | △(ブラックボックス化) | ◎(構造が単純) |

もしよろしければ、次に「SCOUTをベースにTesla的適応能力を部分的に取り入れる構想」や、「SLAM非依存でTeach & Repeatを拡張する設計案」などもご提案できます。ご希望ですか?

Tesla FSD方式 vs SCOUTプロジェクト 方式の比較表の内容を具体的に解説してください。

もちろんです。先ほど提示した Tesla FSD方式 vs SCOUTプロジェクト方式 の比較表の各項目について、背景・技術内容・意味合いを具体的に解説します。🔍 各項目の具体的な解説

1. センサ構成

- Tesla FSD:カメラ8台を前後左右に配置し、視覚情報のみで環境認識を行います(LiDARや超音波は廃止傾向)。一部ハードウェア(HW4)では高解像度レーダーを補助的に利用。

- SCOUT:小型ロボット用でカメラ1〜2台のみ。LiDARや高精度IMUは原則使わず、構成を極限までシンプルにしています。

2. 自己位置推定の方式

- Tesla:Occupancy Network(ニューラルボクセルマップ)により、3D空間中の物体や空間形状を把握し、自車位置を間接的に推定。

- SCOUT:カメラ映像とTeach画像の**見た目の一致度(VPR)**から現在位置を特定。

3. 地図(HD Mapなど)

- Tesla:高精度地図には依存せず、走行時にOccupancyを即座に構築して進む。→ 地図の陳腐化問題を回避。

- SCOUT:従来の意味での地図は保持せず、Teach走行時の画像列が擬似的な地図の役割を果たす。

4. 経路計画

- Tesla:周囲車両や信号・歩行者などの挙動を加味し、AIベースで動的に経路を生成(ニューラルプランナー)。

- SCOUT:Teachした軌道をできるだけ再現。障害物回避や進路変更は設計・実装に依存。

5. 周囲認識

- Tesla:物体検出(車・人・標識)とセグメンテーション、さらには3D構造把握までをAIで処理。

- SCOUT:基本的には周囲物体を扱わず、景色ベースの自己位置のみを判断対象とする。障害物回避機能はオプション実装。

6. データベース/記憶との照合

- Tesla:Occupancy Networkが「今のシーンそのもの」を空間的に解釈する。事前走行記録は使わない。

- SCOUT:Teach走行時に得た画像列が基準データベースとなり、それと照合して走行。

7. 学習方式

- Tesla:DojoなどのAIクラスタで、数億km分の人間運転データを学習してEnd-to-End的な模倣運転を行う。

- SCOUT:少数の画像(1ルート分)をTeach走行で取得。機械学習ではなく、類似度による照合アルゴリズムで動作。

8. 対象環境

- Tesla:都市部・郊外・高速道路など、ダイナミックかつ未知の環境をカバー。

- SCOUT:屋外施設、構内、農地などの制限された領域を反復利用する前提。

9. 対応柔軟性

- Tesla:目的地の指定に応じてルート選定、障害物回避も含めその場で判断。

- SCOUT:事前Teachルート以外は走れない。回避や柔軟な対応は実装依存で弱い。

10. 技術難易度と構築コスト

- Tesla:ハードもソフトも極めて高度。構築には巨大なAIチームと専用チップが必要。

- SCOUT:オープンソース+ROSベースで、個人でも構築可能な実用ロボット。

🔚 総括:思想の違い

| Tesla FSD | SCOUTプロジェクト |

|---|---|

| **“初めての道でも走れる”**を目指す | **“一度走った道を確実に再現する”**を極める |

| AIによる空間理解・汎化型知能 | 人間の模範経路を記憶・照合して再現 |

| 都市交通のフル自動化に挑む | 限定空間のシンプル・確実な自律化を実現 |

ご希望であれば、これを提案資料(スライド)や論文導入部の比較表にまとめることもできます。必要ですか?

「SCOUTをベースにTesla的適応能力を部分的に取り入れる構想」や、「SLAM非依存でTeach & Repeatを拡張する設計案」などを提案してください

素晴らしい着眼点です。以下に、SCOUTの強み(軽量・安定・地図不要)を維持しつつ、Tesla的な柔軟性や適応力を部分導入する構想案を2方向から具体的に提案します。🧠 構想①:SCOUT × Tesla的「即時適応力」導入案

🎯 目的

Teach & Repeat の安定性は維持しつつ、新規障害物や部分経路逸脱に対してリアルタイムで“補正”または“回避”できるロボットを構築。🧩 技術統合ポイント

| 項目 | 導入アイデア | 解説 |

|---|---|---|

| Occupancy風処理 | 軽量Occupancy推定(画像→セマンティックセグメンテーション→経路マスク生成) | Teslaほど高精度でなくても、「ここ通れる/通れない」の2値化処理だけでも大きな効果 |

| 軽量な経路再選択 | VPRで一致しない場合、“隣接地点候補”から再判定 | Teachルートからの軽度逸脱時に自律リカバリ(※リトライ数制限あり) |

| 視覚-based簡易リプランナー | 局所的な視野から“通れそうな方向”をCNNで分類 → 緊急回避 | 単純な前方画像分類(OK/NOGO)でも回避パス生成が可能 |

| 目的地切替の柔軟性 | TeachルートをNode-Graph構造にして、複数ゴールを持つ | Tesla的な“目的地動的指定”に一歩近づく(Teach済み空間内でのみ) |

🔧 実装イメージ(拡張構成)

VPR Node:画像照合(NetVLADなど)Control Node:ピクセルずれから制御量算出Fallback Navigator:マッチ失敗時の「近似地点検索」+「方向スキャン」Obstacle Classifier:画像から前方障害有無判定

🚀 構想②:SLAM非依存でTeach & Repeatを拡張する設計案

🎯 目的

Teach & Repeat方式の空間的制約(直線的ルートのみ、外乱への弱さ)を克服し、実運用可能な自律性と拡張性を持たせる設計。🔧 機能別拡張設計

| 拡張要素 | 内容 | 解説 |

|---|---|---|

| Graph化されたルート管理 | Teach画像列を「ノード(場所)+エッジ(経路)」のGraph構造に変換 | ルート分岐、複数目的地への切替、交差点対応が可能になる |

| 経験融合(マルチTeach) | 異なる天候・時間帯で複数のTeach画像セットを保存し、動的切替 | 環境変化(昼夜・季節)に対するロバスト性向上 |

| 失敗検知と自己回復 | マッチ失敗時に一時停止+広角Scanで再照合 | “迷ったら立ち止まる”安全設計と再スタート処理を統合 |

| 簡易セマンティック情報付与 | 教示時に“地名タグ”や“ドア前”などラベルを簡易登録 | UIや対人操作と連携しやすくなる(例:「資材庫まで行って」) |

| ROS2対応とモジュール分離 | VPR・制御・復旧処理を明確に分離し、デバッグと実装を簡略化 | 将来的なクラウド連携や遠隔Teach支援に対応しやすくなる |

💡 想定ユースケース(実運用展開例)

| ユースケース | 構想適用例 |

|---|---|

| 工場内資材搬送 | Teach済み複数ルートから目的地を動的に選択して自律搬送。分岐/交差点対応あり。 |

| 屋外農場走行 | 時間帯による照度差をマルチTeachで吸収、VPR+方向分類器で雑草や倒木を回避。 |

| セキュリティ巡回 | 巡回ルートをGraph化、障害物を視覚回避。地点ごとの簡易タグ管理で状態記録。 |

🧠 統合ビジョン:SCOUT+構想は何を目指すか?

「人が一度案内すれば、自分で巡回・運搬・回避できる超軽量自律ロボット」 → SLAMもHDマップも使わず、“見る”だけで周囲を理解し、教えたルートを臨機応変に再現する。

ご希望があれば:

- 上記構想に基づくシステム構成図(ROSノード設計)

- 技術ロードマップ(フェーズ1〜3)

- 拡張前後の性能比較表(VPR精度、リカバリ時間など)

SCOUTプロジェクトはいままでの研究との差別化はどこにありますか

SCOUTプロジェクトの差別化ポイントは、以下のように従来のTeach & Repeat研究やVPR応用型ロボットと比較して、実装思想・構成・応用のバランスにおいて独自性があります。✅ 差別化ポイントの全体像

| 項目 | 従来研究 | SCOUTプロジェクト | 差別化の本質 |

|---|---|---|---|

| Teach & Repeat方式 | 高精度カメラ+LiDAR+RTK GNSSを前提とする重装備が多い | オドメトリ誤差込みでも動作する軽装備カメラベース | 「誤差込みでも動くことを設計に含めている」構成 |

| Visual Place Recognition (VPR) | 単体研究ではループ閉じや補助用途が主目的 | 走行制御そのものの基軸にVPRを置いている | VPRを“補助”でなく“主機構”に据える発想 |

| 地図への依存 | 教示走行+LiDAR/SLAMでマップ生成が前提 | 地図非依存(マップ構築なし)で運用前提 | マップを使わず「画像記憶」だけで構成 |

| 再現制御の仕組み | 点群・姿勢一致に基づく厳密なPose追従が多い | 画像類似度を使った“ズレ許容型”の制御設計 | “同じ景色であれば多少ズレてもよい”を許容 |

| 脱ブラックボックス | DNN活用はしても中身が可視化されないものが多い | 手法構成が完全にホワイトボックス化(VPR + 制御) | 学術・教育応用への適性も高い |

| Teach作業の位置づけ | “正確な地図作成”の準備段階とされることが多い | Teach走行そのものがナビゲーションの土台 | Teach=運用開始、という割り切りと実用性志向 |

| ハード依存度 | 高性能センサと演算資源が不可欠 | Raspberry Piレベルでも動作設計 | 軽量化への徹底追求と、普及性の高さ |

🎯 SCOUTが解決した「ギャップ(空白)」

| 従来のギャップ | SCOUTが担った部分 |

|---|---|

| SLAM不要の自律移動手法は精度が不安定 | 教示画像+VPR照合で十分な再現性を実証 |

| オープンな屋外移動に強い軽量方式が不足 | 屋外+構内で安定走行できる低コスト構成 |

| VPRは研究用にとどまりがちで制御接続が難しい | VPRと走行制御を密結合したROS構成に設計 |

| 教育・応用両立できるパッケージが少ない | 軽量性+構成のシンプルさで教育にも展開可能 |

📌 他の代表的研究と比較した位置づけ

| 研究・方式 | 特徴 | SCOUTとの違い |

|---|---|---|

| ETHZ:Teach & Repeat(Barfootら) | 高精度LiDARと精密制御、地図依存 | SCOUTは地図非依存・軽量構成 |

| OpenVINS + VPR補助 | Visual-Inertial Navigation+ループ補正にVPR | SCOUTはVPRを主経路認識手段とする点で逆転構造 |

| Cartographer + Teach-Repeat運用 | SLAMベース地図でTeach経路を繰り返す | SLAM排除により地図不整合の影響を受けない |

| NAVER LABS / DeepMind系 | DeepRL + トポロジカルマップ+CNN制御 | SCOUTは深層学習不要で構成可視性が高い |

🔧 SCOUTが打ち出せる方向性(研究的貢献)

- 「Teach & Repeatを再定義する」構成提案:地図不要・Pose不要・VPR駆動という再構築的アプローチ

- 軽量で堅牢な自己位置推定法の提案:SLAMやGPSが使えない環境でも高安定性

- 画像マッチングと制御の統合性デザイン:エンジニアリング的に再現可能なナビゲーション構成

- 実応用(農業・工場・警備)へのトランジションが近い設計:汎用化前提のスケーラブルな構成思想

ご希望があれば:

- 論文イントロ用に「差別化に関する主張文(例文)」

- 他の方式との技術比較表(引用付き)

- 特許出願や技術アピール向け要約文

SCOUTが打ち出せる方向性(研究的貢献) 「Teach & Repeatを再定義する」構成提案:地図不要・Pose不要・VPR駆動という再構築的アプローチ 軽量で堅牢な自己位置推定法の提案:SLAMやGPSが使えない環境でも高安定性 画像マッチングと制御の統合性デザイン:エンジニアリング的に再現可能なナビゲーション構成 実応用(農業・工場・警備)へのトランジションが近い設計:汎用化前提のスケーラブルな構成思想 それぞれを更に深堀してください

以下に、SCOUTプロジェクトが打ち出せる研究的方向性とその貢献内容について、各項目をより深く掘り下げて解説します。①「Teach & Repeatを再定義する」構成提案

地図不要・Pose不要・VPR駆動という再構築的アプローチ

✦ 従来との違い

- Teach & Repeat は本来「SLAMで地図を作り、Teach経路をPose(位置・姿勢)として記録、Repeat時にそのPoseを再現する」設計が一般的。

- SCOUTはPose情報を一切使わず、景観の“見た目一致”のみでナビゲーションする。

✦ 提案の本質

- Teach経路=「連続画像列」という表現に切り替えることで、

- 地図やPoseの精度・整合性に依存せずに自己位置推定が可能

- 画像マッチングのロバスト性・拡張性を基軸とした新しいルート表現になる

✦ 研究貢献の意義

- Teach & Repeat ≠ SLAM補助という構図から脱却

- VPR(通常は回帰・ループ閉じ補助)を主役に据えた構成思想の提示

- 高度な位置認識をせずともロボットは走れるという実用主義的な再構築

② 軽量で堅牢な自己位置推定法の提案

SLAMやGPSが使えない環境でも高安定性

✦ 問題設定

- 工場、倉庫、トンネル、森林などでは:

- GPSが遮断される

- SLAMの地図整合性が壊れやすい(繰り返し構造、動的要素)

✦ SCOUTのアプローチ

- 小型カメラ + オドメトリ程度のセンサ構成でも動作

- 局所的画像照合(例:NetVLADやSuperPoint)と直近フレームの継続性で、誤マッチを自己回復

- 高精度ではなく「許容可能な誤差内での連続的認識」に最適化

✦ 実装の工夫

- リアルタイム画像照合を安価なSoC(例:Jetson Nano)でも処理可能に

- オドメトリが崩れてもVPRで復帰可能なフェイルセーフ構造

✦ 研究的意義

- ロバスト性 > 精密性 という設計思想の定式化

- 軽量・非SLAM・非GNSSベースでの屋外自律走行の成立証明

③ 画像マッチングと制御の統合性デザイン

エンジニアリング的に再現可能なナビゲーション構成

✦ 課題と背景

- 多くのVPR研究は「場所認識」のみがゴールで、制御との統合は未解決(またはブラックボックス)

- Teach & Repeatにおいても、「一致したけどどう進むか」が不明瞭な実装が多い

✦ SCOUTの設計上の特長

- VPRでマッチしたTeach画像と現在画像のピクセル変位を使って制御量(速度・角度)を直接計算

- 一致度スコア・位置誤差に応じたゲインスケーリング(PIDまたは比例制御)

✦ 研究的な意味合い

- VPR + 制御を定式化可能なブロック構成として示したこと

- ブラックボックス制御(End-to-End)に対する可視的かつ再現可能な代替設計

- 実装移植・教育応用が可能な工学的透明性

④ 実応用(農業・工場・警備)へのトランジションが近い設計

汎用化前提のスケーラブルな構成思想

✦ 産業的前提条件

- SLAM搭載ロボットはコスト・整備・学習コストが高く、量産現場には導入しにくい

- 一方で「毎日同じルートを走る」ニーズは極めて多い(農地、倉庫、施設警備など)

✦ SCOUTの構成特性

- 教示走行を1回行えば、その経路を再現可能

- カメラと簡易コンピュータのみで構成 → 低コスト化

- ソフトウェア構成がシンプル → 商用展開・教育展開ともに対応しやすい

✦ 研究的・社会的価値

- 技術のエンジニアリング展開可能性の提示

- 現実に使えるロボット方式としての示唆と実証

- 開発者・研究者・現場オペレータの共通理解可能なアーキテクチャ

ご希望があれば、これらをベースに:

- 論文イントロ/貢献セクション原稿

- 国際学会用アブストラクト案

- 導入背景+課題+貢献構成の図解

問題設定 工場、倉庫、トンネル、森林などでは: GPSが遮断される SLAMの地図整合性が壊れやすい(繰り返し構造、動的要素) について教えてください。

以下に、「GPSが使えない/SLAMが不安定になる代表的な環境」とその理由、Teach & Repeat + VPR 方式の有効性までを、具体的に整理してご説明します。🚧 問題設定:GPS・SLAMが困難な環境とは

① 工場・倉庫(屋内、金属構造物が密な空間)

| 問題 | 詳細 |

|---|---|

| GPS遮断 | 屋内では人工衛星からの電波が届かない(壁・天井・遮蔽物)ため、位置情報が完全に取得不能になる。 |

| SLAM不安定 | 広大な倉庫では、棚や機械が繰り返し構造を持ち、LiDARや画像SLAMで自己位置を誤認しやすい。また、フォークリフトや人の動きにより、環境が動的に変化して地図の整合性が崩れやすい。 |

| オドメトリ誤差蓄積 | 床が滑りやすい/タイヤが空回りすることが多く、デッドレコニングが信頼できない。 |

② トンネル・地下構内・プラント内

| 問題 | 詳細 |

|---|---|

| 完全にGPS遮断 | 電波遮蔽が強く、GNSSベースの自己位置推定が不可能。 |

| 照明変化・湿度・反射 | 環境が暗かったり、水気が多かったりして、センサの読み取りにノイズが乗る。 |

| SLAMでループ閉じ困難 | 長大トンネルでは目印が少なく、同じような景観が続くため、ループ閉じ(再訪認識)が不安定。 |

| 地図が変わりやすい | 工事中の仮設物・車両の移動などで、SLAM地図の信頼性が下がる。 |

③ 森林・果樹園・農地

| 問題 | 詳細 |

|---|---|

| 樹冠・地形でGPSが不安定 | 木々の葉や谷間・丘によって、GPS衛星からの信号が届きにくく、測位誤差が±数十mに増大。 |

| 同じような景観が続く | 樹木や畝の配置が規則的/均質 → SLAMではランドマークの識別が難しい。 |

| 地図が常に変化 | 作物の成長・収穫、葉の落下、天候によって景観が激変。LiDARや地図に依存したナビは季節性の劣化を受けやすい。 |

| デコボコ地形/ぬかるみ | オドメトリが滑ったり沈んだりして、長期的な自己位置ずれが蓄積しやすい。 |

✅ Teach & Repeat + VPR が有効な理由

| 要素 | 理由 |

|---|---|

| GPS非依存 | VPRはカメラ画像のみで過去画像とマッチングするため、完全GPSレスで動作可能。 |

| 地図不要 | SLAMやHDマップがなくても、Teach時の画像列だけで自己位置と進行方向を判断可能。 |

| 環境の揺らぎに強い | 光や季節変化による差分があっても、VPR(NetVLADなど)は特徴ベースで頑健な一致判定が可能。 |

| 繰り返し構造への対応 | ルート全体の画像系列に基づくマッチングで、区別がつきにくい場所でも位置を割り出せる。 |

| 軽量・安価な構成で実現可能 | カメラ1台と軽量PC(JetsonやRaspberry Pi)で成立し、屋外・動的現場への展開が現実的。 |

🎯 応用先のイメージ

| 環境 | 運用例 | VPR活用のメリット |

|---|---|---|

| 倉庫内巡回 | パトロール・資材配送 | ルートが決まっているなら高精度地図不要で安定運用 |

| 森林巡視 | 害獣・侵入者検知 | 樹木や地形が変わっても再現可能な走行経路 |

| プラント構内 | 点検ルートの自律走行 | GPSもSLAMも難しい中でも確実に通れる |

必要であれば、このテーマでプレゼン用のスライド構成や、提案論文の「課題設定セクション原稿」も用意できます。ご希望はありますか?

画像SLAMとSCOUTプロジェクトは異なりますか

はい、SCOUTプロジェクトと画像SLAM(Visual SLAM)は本質的に異なる技術体系です。以下に、両者の違いを目的・構成・動作原理・応用思想の観点から詳しく解説します。🔍 SCOUTプロジェクト vs 画像SLAM:対比表

| 観点 | SCOUTプロジェクト | 画像SLAM(Visual SLAM) |

|---|---|---|

| 目的 | 一度教えたルートを、画像の一致度をもとに再現する | カメラの動きから、自己位置(Pose)と地図(Map)を同時に推定する |

| 方式分類 | Teach & Repeat + Visual Place Recognition(VPR) | Simultaneous Localization and Mapping |

| 主な出力 | どのTeach画像に似ているか → 今いる“場所”の特定 | 3次元空間内でのカメラの位置・姿勢(Pose)と点群地図 |

| 必要なセンサ | カメラ1台でも可能(LiDAR不要) | カメラ(単眼 or ステレオ)+IMU(あると安定) |

| マップ構築 | しない(地図非保持) | する(点群やキーポイントマップを構築) |

| 計算量・リソース | 非常に軽量(Raspberry Piでも可能) | 計算負荷高(CPU/GPUが必要) |

| 弱点 | Teach画像がなければ動けない/自己位置はあくまで“場所” | 繰り返し構造や動的環境で誤マッチ・崩壊しやすい |

| 強み | 再現性・頑健性に優れる、簡単に運用開始できる | 未知環境でも自己位置と地図を推定できる(探索型) |

🧭 技術的な根本思想の違い

✅ SCOUTの思想:

「この景色は、過去にどこかで見た景色に似ているか?」という**類似性マッチング(場所認識)**を基に行動

- 地図や位置精度にこだわらず、“再現性”を最重視

- 人間が教えたルート・景色に忠実に従う

- 「一度覚えれば、ずっと同じように動く」ことがゴール

✅ 画像SLAMの思想:

「カメラが今、どの方向を向いていて、どこを動いているか?」を推定し、同時に地図も作ることがゴール

- 自律探査や自己位置推定の精度を追求

- 常に自己位置(Pose)を算出し続ける

- 「知らない場所でも、見た情報だけで地図を作りながら進む」ことがゴール

🎯 それぞれの適材適所

| 目的 | 向いている方式 |

|---|---|

| 新しい空間を探検・地図化したい | 画像SLAM |

| 毎日同じルートを自律走行したい | SCOUT(Teach & Repeat) |

| GPSのない屋内でナビゲーションしたい | 両方可能だが、SCOUTは軽量・簡易 |

| 変化の激しい環境で安定走行したい | SCOUT(記憶型・ロバスト性重視) |

✅ 結論

SCOUTはVisual SLAMではありません。 むしろ、Visual SLAMの持つ「地図依存・高負荷・複雑性」といった課題を回避するために、意図的にVPRベースの軽量な方式を採用した別系統のアプローチです。 必要であればこの違いを図解化したり、論文内の導入文や比較セクション草案としてまとめたりもできます。ご希望はありますか?軽量・安価な構成で実現可能 カメラ1台と軽量PC(JetsonやRaspberry Pi)で成立し、屋外・動的現場への展開が現実的。 他の手法だとどのくらいの性能が必要になりますか?

とても良い問いです。以下に、SCOUTのようなTeach & Repeat + VPR型ナビゲーションと、他方式(Visual SLAM/LiDAR SLAM/HDマップナビなど)における必要な性能や構成要件を比較し、どの程度の計算資源・コスト・構成差があるかを具体的に整理します。🚀 比較:各自律ナビゲーション方式に必要なハード性能

| 方式 | 構成例 | 計算資源(目安) | ハードコスト(目安) | 備考 |

|---|---|---|---|---|

| SCOUT(Teach & Repeat + VPR) | ・USBカメラ1台・Jetson Nano / Raspberry Pi 4・オドメトリ(任意) | CPU: Quad-core ARM Cortex-A72RAM: 4GB以上(GPU不使用でも可) | 約 1〜3万円 | VPRを小型CNNやNetVLADで軽量実装 |

| Visual SLAM(ORB-SLAM2など) | ・単眼/ステレオカメラ・Intel NUC, Jetson Xavier・IMU(推奨) | CPU: i7以上RAM: 8GB以上GPU: オプション | 約 5〜10万円 | リアルタイムでキーポイント抽出+地図生成 |

| LiDARベースSLAM(Cartographer, LOAM) | ・3D LiDAR(Velodyne等)・RTK GNSS(任意)・i7ノートPCまたはワークステーション | CPU: 高速x64RAM: 8〜16GBGPU: 不要(多くはCPU処理) | 約 100万円以上(LiDAR込み) | LiDARだけで周囲のマップを構築可能だが高価 |

| HDマップ+自己位置推定(自動運転系) | ・高精度IMU・LiDAR・GNSS・車載GPU (NVIDIA Drive, Xavier) | GPU: CUDA対応 / RTXレベルRAM: 16GB以上 | 数百万円規模 | 車線レベルでの位置推定と路面認識が可能 |

🎯 SCOUT方式の「軽量性」の意味するところ

| 比較軸 | SCOUT | 他方式(例) |

|---|---|---|

| リアルタイム性 | 5〜15Hz程度で十分 | 30Hz以上が必要なケースも多い |

| 地図保存容量 | 画像列(JPEG/PNG)で数百MB以下 | 点群・Pose履歴は数GB〜10GB |

| 消費電力 | 10〜15W程度(Raspberry Pi含む) | 50〜200W(GPUやLiDAR含む) |

| セットアップ時間 | 数分でTeach可能 | 地図作成+整合調整で数時間〜日単位 |

🔧 実際に使われる構成例(概算)

| 構成 | SCOUT構成例 | Visual SLAM構成例 | LiDAR SLAM構成例 |

|---|---|---|---|

| カメラ | USBウェブカメラ(Logitech C920など) | ステレオカメラ(Realsense D435) | なしまたは補助用 |

| コンピュータ | Raspberry Pi 4 / Jetson Nano | Intel NUC i7 / Jetson Xavier | 高性能ノートPCまたはMini-ITX |

| 補助センサ | ホイールオドメトリ(任意) | IMU(推奨) | GNSS, IMU, 3D LiDAR |

| 総コスト | 2〜5万円程度 | 10〜30万円程度 | 100万円以上 |

✅ なぜSCOUTは「屋外・動的現場」でも現実的か

- 高精度マップが要らない → 周囲が変わっても“景色の一致”だけで再現可能

- 処理が軽量 → GPU非搭載でも使える(Jetson NanoやRPiでもOK)

- Teachにより再現性を担保 → 高精度センサやSLAM誤差の累積を避けられる

- 導入障壁が低い → 市販部品で組めるため、試作・小規模導入が容易

ご希望があれば:

- 実機構成の選定リスト(購入リンク付き)

- 各方式のROI(費用対効果)比較シミュレーション

- 産業応用ごとの構成テンプレート(農業/工場/施設別)

Visual SLAMの持つ「地図依存・高負荷・複雑性」といった課題を詳しく教えてください。

Visual SLAM(Visual Simultaneous Localization and Mapping)は強力な自律移動手法ですが、その実運用・応用にはいくつか根本的な課題や制約があります。以下に、SCOUTのような軽量・VPRベース手法との比較の文脈で、Visual SLAMが抱える地図依存・高負荷・複雑性の各課題を詳しく解説します。🗺️ ① 地図依存(Map Dependency)

✦ 課題概要

Visual SLAMは「地図(Map)と自己位置(Pose)を同時に求める」手法です。そのため、運用中は以下のような地図整合性の維持が不可欠になります。✦ 具体的な問題点

| 問題 | 内容 |

|---|---|

| 環境が変わると地図が無効化 | 棚の移動、ドアの開閉、季節の変化などでマップ上の特徴点が一致しなくなり、位置推定が失敗 |

| 繰り返し構造に弱い | 倉庫のように同じ棚や通路が続くと、自己位置の誤認(エイリアス)を引き起こす |

| マップの初期化が必要 | 運用前に探索またはTeach走行で安定した地図を構築しておく必要がある |

| ループ閉じが不安定 | 長距離移動で再訪した場所を正しく検出できないと、地図が歪む・崩壊する可能性あり |

✦ 結果としての弱点

- 動的・変化の激しい環境に適応しづらい

- 地図の「整合性の維持」という見えにくい保守作業が発生する

🧮 ② 高負荷(Computational Load)

✦ 課題概要

Visual SLAMはリアルタイムで「特徴点抽出 → 対応点マッチング → 最適化(BA)」を繰り返すため、計算リソースの要求が非常に高いです。✦ 具体的な負荷要素

| 処理項目 | 特徴 | 計算コスト |

|---|---|---|

| 特徴点抽出・追跡 | ORB, SIFT, SuperPointなど | 高頻度に実行されるため負荷大 |

| エッジ/点群のマッチング | 空間的整合性を求める処理 | 計算複雑性が高く、フレームレートが落ちやすい |

| Bundle Adjustment(BA) | 最適なカメラ軌跡と地図を同時に算出 | スケールが大きくなると指数的に重くなる |

| ループ検出 | Bag-of-WordsやNetVLADなどで全画像と照合 | 大規模環境では照合回数が爆発的に増える |

✦ 結果としての制約

- モバイル用CPUやSoCではリアルタイム処理が難しい

- GPUや専用アクセラレータが必要になるケースが多い

- 複数カメラや高解像度だと消費電力・排熱問題も

⚙️ ③ 複雑性(System Complexity)

✦ 課題概要

Visual SLAMは多段構成・多依存の複雑なシステムであり、再現性やデバッグが難しいというエンジニアリング的な課題があります。✦ 複雑になる要因

| 要因 | 内容 |

|---|---|

| センサフュージョン | カメラ、IMU、LiDAR、GNSSの統合には外部キャリブレーションとタイミング同期が必須 |

| 初期化の条件がシビア | モーションが少なすぎたり、テクスチャが不足するとSLAMが破綻しやすい |

| 環境依存性が高い | 照度変化、反射、動体ノイズ、霧や粉塵などで性能が大きく変化 |

| ソフト構成が複雑 | SLAMの各要素(Front-end, Back-end, MapDB, LoopClosures)を分離して管理が必要 |

✦ 実運用上の困難

- ソフトウェアの構築・保守・チューニングに高度なスキルが必要

- センサキャリブレーションやパラメータ設定が複雑

- アップデートで挙動が不安定になることも

🎯 SCOUTとの対照的ポイント

| 項目 | Visual SLAM | SCOUT(Teach & Repeat + VPR) |

|---|---|---|

| 地図 | 点群やPoseのマップを生成・維持 | 地図不要。画像列のみ保存 |

| 計算負荷 | 高い(多段構成) | 軽量(CNN照合+簡易制御) |

| 導入難易度 | 高(センサ融合・パラメータ調整) | 低(カメラ1台、教示のみ) |

| 環境適応性 | 動的環境に弱い | マッチに基づく柔軟対応が可能 |

| 教育・再現性 | 工学知識が必要 | 構成がシンプルで再現しやすい |

✅ 結論

Visual SLAMは未知環境の地図化や高精度自己位置推定には優れていますが、- 地図の保守が難しい

- 高負荷な演算が必要

- システムが複雑で扱いが難しい

ご希望があれば、これを図表付きのスライド形式や論文イントロ草案にもできます。どうしますか?

VPRベース手法は環境変化に強いのですか

はい、VPR(Visual Place Recognition)ベースの手法は、一定の設計次第で「環境変化に比較的強い」特性を持ちます。ただし万能ではなく、設計・特徴抽出・データ構造によって性能が大きく左右されます。以下に詳しく説明します。✅ VPR(Visual Place Recognition)とは何か?

- 「今見ている景色が、過去に見た景色のどれに最も近いか?」を判断する技術

- SLAMではループ閉じに使われ、Teach & Repeatでは自己位置代替に使われる

- 高次元の画像特徴ベクトルを比較して“類似度”を出す

🌦 VPRが環境変化に強い理由(=ロバスト性の源)

| 特性 | 内容 |

|---|---|

| 構造情報を主に見る | 建物の輪郭、通路の形、樹木の配置など、環境の幾何構造を特徴として学習しているため、照明や色が変わっても類似性を保持できる |

| 深層特徴(CNN)を使用 | SIFTやORBのような局所特徴よりも、**CNNで抽出したセマンティック特徴(意味)**の方が変化に強い(例:NetVLAD, DBoW2) |

| 空間全体の印象で判断 | 画像全体を要約して照合するため、部分的な変化(落ち葉・人の通過など)に影響されにくい |

| 照明・季節・天候の差異に耐性 | 学習データやデータ拡張により、朝/昼/夕、晴/曇、冬/夏といったバリエーションに対応できるようになっている実装がある |

📉 ただし、VPRにも弱点はある

| 制限 | 内容 |

|---|---|

| 景観が大きく変化すると一致しない | 建物の取り壊し、新設工事、木々の伐採など「構造そのもの」が変わるとマッチできない |

| 見落とし・誤一致のリスク | 非常に似た構造(例:倉庫の棚列)が複数あると、誤マッチの可能性がある |

| 近似検索の分解能が限られる | 教示画像間隔が粗いと、細かな変化を補足できない/逆に密すぎると計算負荷や誤検出が増える |

🧪 実験で示されているロバスト性の一例

- NetVLADやSuperPointなどのVPRアルゴリズムは、次のような条件でも場所認識が可能なことが示されています:

| 条件 | 一致成功の例(実験より) |

|---|---|

| 季節変化(春→冬) | 雪景色でも建物や通路の構造でマッチ成功 |

| 時刻差(昼→夕方) | 色温度が変化しても構造ベースで一致可能 |

| 視点変化(同じ場所でも少しズレた位置) | 複数視点で学習していれば許容できる |

| 部分遮蔽(人・車・枝など) | グローバル特徴により無視されやすい |

✅ SCOUTのようなVPRベースTeach & Repeatの強み

- GPS・SLAMに依存せず、環境変化に“そこそこ強い”

- 一致度スコアによる「確信度」に応じて制御ゲインを可変化 → 部分的に曖昧でも走行継続

- ルートに沿って撮影された画像列に従うので、“だいたいこのあたり”でも十分機能

🧭 ロバスト性をさらに上げる工夫(設計側の工夫)

- Teach画像の時間的・天候的多様化:朝夕や雨天でもTeachしておく

- 特徴抽出器の選定:NetVLADやSuperPointのようなロバスト性重視のVPRを使う

- マルチスケール照合:異なる解像度やパッチレベルでの一致を加味

- 一貫性チェック:単発の一致だけでなく、前後画像との連続的整合性で誤一致を排除

✅ 結論

VPRベースのナビゲーションは、「景観が完全一致しない状況でも、それが“同じ場所だ”と判断できる柔軟性を持つ」点で、環境変化への頑健性が高い手法です。SLAMや地図マッチングが苦手な「季節変動・光条件・動的要素」のある環境において、軽量・柔軟な再現型ナビゲーションとして現場適用しやすいのが、SCOUTのような設計の特長です。

ご希望であれば、「VPRの頑健性を示す実験設計」や「複数条件Teachによる強化法」などもご紹介可能です。興味ありますか?

夜間巡回などをドローンタイプで行う場合と比較してメリット、デメリットはありますか

はい、夜間巡回や警備用途で「SCOUTのような地上型Teach & Repeatロボット」と「ドローン(空中型)」を比較すると、両者には明確なメリットと制約の違いがあります。以下に、具体的なユースケースを想定して、両方式の特性を整理します。🧭 夜間巡回用途:地上型(SCOUT) vs ドローン型の比較表

| 観点 | 地上型(SCOUT方式) | ドローン型 |

|---|---|---|

| 構成 | カメラ+VPR+Teach走行 | マルチローター+IMU+カメラ/LiDAR/GPS |

| 移動自由度 | 地面上に限定(2D) | 空中を含む(3D) |

| カメラ安定性 | 地面に接地して安定 | 空中で風などによりブレやすい |

| 夜間の光源要件 | 小型LED照明で対応可 | 高度によって広範囲照射が必要な場合も |

| 航続時間(1充電) | 数時間~1日(地上移動) | 通常10〜30分程度(連続飛行) |

| ペイロード | 小型バッテリー・ライト・小PC搭載可 | 軽量化必須/積載制限大きい |

| Teach & Repeatの適用 | 画像列と簡易オドメトリで容易に再現 | 空間的にルート再現が難しい(高度・角度が再現困難) |

| 法規制 | 屋内・私有地では自由 | 飛行高度・目視外・夜間飛行に厳しい規制(航空法) |

| 危険物との接触 | 地面障害物に注意 | プロペラ接触や落下のリスクあり |

| コスト/整備性 | 安価で自作も容易 | 高価で点検・保守が必要 |

✅ 地上型(SCOUT方式)の主なメリット

- 安定したカメラ視点:振動・ブレが少ない → 夜間のVPR照合に有利

- 電力効率が高い:1回の充電で長時間巡回可能

- Teach & Repeatが容易:地形や地物と一致する画像列でルートを安定再現

- 法規制が緩い:屋内/敷地内では運用自由、夜間や目視外も合法的に可能

- 低コストで冗長化が可能:多数台での分散運用・常時巡回も現実的

✈️ ドローン型の主なメリット

- 上空からの広域監視が可能:障害物の影に隠れた部分も観察できる

- 高所構造物・立体交差などを巡回できる:建物屋上、橋梁なども確認対象にできる

- 人・車に干渉しづらい:地面上の混雑を回避できる

⚠️ ドローン型の主な制約

| 制約項目 | 内容 |

|---|---|

| 法的制限 | 夜間飛行・目視外飛行・第三者上空の飛行には特別許可が必要(航空法・電波法) |

| 飛行時間が短い | 通常10~30分、長距離巡回にはバッテリー複数交換が必要 |

| 安定飛行の難しさ | 夜間風や狭所では高度・姿勢維持が難しく、カメラ制御に支障が出やすい |

| 落下・事故リスク | 通行人や設備への落下・接触による危険が常に伴う |

| VPRやTeach再現が難しい | 高度・角度・姿勢が地上より揺らぎやすく、視点の一致が難しい |

🏁 結論と使い分け

| ニーズ | 適する方式 |

|---|---|

| 地上ルートを正確・安定に再現して巡回したい | SCOUT方式(地上型) |

| 人が立ち入りづらい高所・広域を少時間観察したい | ドローン(空中型) |

| 長時間連続でルート監視したい | 地上型(航続時間が有利) |

| 法的に制限なく夜間巡回したい | 地上型(ドローンは夜間要許可) |

💡 応用提案

- SCOUT方式とドローンのハイブリッド運用:

- 地上はSCOUTで定期巡回し、異常があったときだけドローンが出動する「スポット点検型」

- 地上が死角となる場所をドローンが補完

ご希望であれば、夜間巡回向けの構成図・設計案・コスト比較などもご提案可能です。続けてご希望ありますか?

いろいろ勉強になりました。ありがとう。今までの会話の内容を要約してください

こちらこそ、深いご相談をありがとうございました。これまでの会話内容を以下に5つの主要テーマに沿って簡潔にまとめました:① SCOUTプロジェクトの特性と意義

- 手法:Teach & Repeat + VPR(Visual Place Recognition)による地図不要の視覚ナビゲーション

- 構成:カメラ1台と軽量PC(Raspberry PiやJetson)で成立

- 特徴:

- 地図・SLAM・GPS非依存で、繰り返し型タスクに特化

- 自己位置推定を“場所認識”に再定義(Poseではなく類似度)

- 軽量・安価・再現性重視の構成で実応用に向く

② 他方式との比較(Visual SLAM/Tesla FSD/ドローンなど)

- Visual SLAM:未知環境でも探索可能だが、重く・複雑で・環境変化に弱い

- SCOUTとの違い:

- 地図不要、計算負荷低、環境変化や繰り返し構造に強い

- Tesla FSDとの比較:

- Teslaはマルチセンサ+AI統合制御、SCOUTは画像一致ベースで軽量

- ドローンとの比較(夜間巡回):

- SCOUTは安定・長時間・法規制なし、ドローンは空中優位だが短時間・規制あり

③ 応用可能な産業分野

- 工場内搬送、倉庫物流、建設現場、農業巡回、清掃・案内ロボットなど

- 特にGPS不全・繰り返しルート・地図が不安定な環境に向いている

- 導入コストが低いため、小規模でも導入可能な強みあり

④ 研究的貢献と構想提案

- Teach & Repeatの再定義:地図・Poseを使わず、視覚類似度のみで自己位置を定義

- SLAM非依存のナビゲーション:計算・構成を大幅に簡略化

- VPRの活用強化:画像マッチングと制御設計の融合

- 拡張構想:

- Tesla的な適応制御の一部導入(観測信頼度に応じたゲイン可変)

- 教示ルートのクラウド共有や汎用フレームワーク化

- SLAMと融合しない「VPR専用ナビゲーションアーキテクチャ」の提案

⑤ 技術的論点の深堀り

- VPRの環境変化耐性:CNN特徴による照度・季節変化へのロバスト性

- Visual SLAMの課題:

- 地図整合性への依存

- 高負荷・複雑な構成

- 環境変化や繰り返し構造に弱い

- SCOUT方式の設計利点:

- Teach走行で高い再現性

- 軽量処理でリアルタイム性確保

- 教育用・実装再現性も高い

ご希望があればこのまとめを研究草案/資料/スライド形式などにも構成できます。 別の文脈や深掘りが必要であれば、気軽にお声がけください!

SCOUTプロジェクトに最近のAIを入れたりはできませんか

できます。むしろ**SCOUTのような軽量Teach & Repeat構成に、最近のAI技術を適切に“足し算”することで、より賢く・柔軟で・応用可能性の高いロボットシステムに拡張できます。**以下に、実現可能な方向性をいくつかご提案します。🔧 SCOUT × AI:統合強化の提案 〜4つの方向性〜

① VPRモジュールのAI強化

| 項目 | 内容 |

|---|---|

| 現状 | NetVLADや手工特徴で画像間類似度を評価 |

| 拡張案 | マルチスケールCNN/視点不変学習済みのVPR(例:SuperGlue, TransVPR)などで視点変化・夜間耐性を強化 |

| 効果 | 多少異なる角度・時刻・天候でもTeach画像と一致できる → 環境変化への柔軟性UP |

② End-to-End模倣学習(IL)による制御出力

| 項目 | 内容 |

|---|---|

| 現状 | 最近傍画像のインデックスと一致度に応じて手動設計した制御則で移動 |

| 拡張案 | 教示時の画像と制御信号をセットで記録 → CNNベースの模倣学習で**「画像→速度指令」へのEnd-to-Endモデル**を学習(Behavior Cloning) |

| 効果 | 地形や障害物回避も含めたスムーズな軌道再現が可能に/微細な制御が安定 |

③ 運用時のエラー検知・自己診断にAI

| 項目 | 内容 |

|---|---|

| アイデア | 「今の画像が本当にTeach画像と似ているか?」を多次元で評価するために、異常検知モデル(AutoEncoder, Mahalanobis Distance)などで信頼度評価 |

| 効果 | 誤認識や逸脱時に自動停止/「景色のズレ」をスコアで可視化して警告できる |

④ 教示ルートの自動汎化(Few-shotナビゲーション)

| 項目 | 内容 |

|---|---|

| 拡張案 | Teach画像列をベースに「補間的にありうる景色」を生成(Diffusion, NeRF, GANなど)し、ルート外れにも対応する汎化ルートを構成 |

| 効果 | Teachルートの微細なズレや障害物迂回にも柔軟に対応できる/Teachし直し回数が減る |

💡 さらに応用的な統合案(構想レベル)

| 方向性 | 説明 |

|---|---|

| 自然言語での指示対応 | LLMと接続し「この通路を右折して巡回」などを自然文で受けるインターフェース構築(音声案内などとも接続) |

| マルチセンサ統合 with AI | カメラに加えてマイクやToFセンサのデータを融合 → 状況を多角的に判断しAIで統合処理 |

| Teach無しでも行けるVLM型ナビ | 例:「奥の青いドアまで行って」→視覚言語モデル(CLIP, DINOv2)などで対象理解・追従(研究段階) |

✅ 結論:SCOUTは“AIフレンドリー”な構成

- 軽量かつシンプルな構造のため、AI技術の導入コストが小さく、制御実験しやすい

- 複雑なセンサ融合やSLAM処理が不要なので、「AI×ロボットを素早く試せる土台」としても優れている

- 上記技術の一部は既存論文・OSSでも入手可能。順次導入・比較検証が可能です

ご希望であれば:

- 強化構成図や設計書案

- 試すべきOSSリスト(モデル、ライブラリなど)

- 研究テーマ化への整理(共著や学会想定)