論文要約(AnyLoc)

本論文は、Visual Place Recognition(VPR:視覚的場所認識)を「どこでも・いつでも・どの視点からでも」機能させる汎用的手法 AnyLoc を提案している。背景と課題

- 従来のVPR手法(NetVLAD、CosPlace、MixVPRなど)は 都市環境・地上視点・特定データセットに強く最適化されている。

- その結果、

- 水中・空撮・地下・視覚劣化環境

- 昼夜変化・季節変化

- 正面↔背面など極端な視点差 といった 分布外環境では性能が急激に低下する。

- 「学習データを増やす」路線は、屋外都市以外ではスケールしにくい。

提案手法:AnyLoc

AnyLocの核心は次の2点にある。- VPR専用に学習していない foundation model(DINO / DINOv2)を利用

- Web規模の自己教師あり学習により、環境非依存な特徴を獲得

- 画像全体特徴(CLS token)ではなく、画素レベル特徴を集約

- ViTの中間〜後段層の per-pixel feature(特に value facet) を抽出

- それを GeM や VLAD で非教師あり集約

- 再学習・ファインチューニング不要

- 環境・時間・視点に頑健な VPR を実現

技術的ポイント

- 特徴抽出

- DINO / DINOv2 の ViT

- 深い層の value(DINOv2)や key(DINO)が有効

- 集約手法

- GeM:語彙不要で軽量

- VLAD:最高性能(特に hard assignment)

- 語彙設計(VLAD)

- PCA空間でデータセットを

- Urban / Indoor / Aerial / SubT / Degraded / Underwater に分離

- ドメイン別語彙を構築することで性能がさらに向上

- PCA空間でデータセットを

実験結果

- 12種類の多様なデータセット(都市・屋内・空撮・水中・地下など)で評価

- 主な結果:

- 従来SOTA比で 最大4倍の Recall@1 向上

- 未構造環境では VPR特化手法を大幅に上回る

- 昼夜・季節・180°視点反転にも高い頑健性

- CLS tokenのみを使う方法より、 局所特徴+集約(AnyLoc)が圧倒的に有利

結論・意義

- AnyLocは、

- 環境依存

- タスク依存

- 大規模教師あり学習依存 という従来VPRの制約を外した 「汎用VPRの新ベースライン」。

- ロボットの

- Teach & Repeat

- SLAM非依存ナビゲーション

- 野外・未知環境展開 において、実運用レベルで重要な貢献を持つ。

📌 一言で言うと

「VPRを“学習済み都市特化モデル”から解放し、foundation model × 非教師集約で本当に汎用化した論文」

日本語訳

要旨(Abstract)

**Visual Place Recognition(VPR:視覚的場所認識)**は、ロボットの自己位置推定において極めて重要な技術である。これまでに提案されてきた高性能なVPR手法の多くは、環境依存かつタスク依存であり、構造化された環境(主に都市走行環境)では高い性能を示す一方で、非構造環境では性能が著しく低下する。その結果、多くの手法は実環境での頑健な運用には不十分であった。

本研究では、再学習やファインチューニングを一切必要とせず、構造化・非構造化環境の双方(都市、屋外、屋内、空撮、水中、地下環境)において機能する、汎用的なVPR手法を提案する。

我々は、VPR専用の学習を行っていない市販の自己教師ありモデルから得られる汎用的な特徴表現こそが、このような汎用VPRを構築するための適切な基盤であることを示す。

これらの特徴を非教師あり特徴集約手法と組み合わせることで、提案手法群 AnyLoc は、既存手法と比較して最大4倍の性能向上を達成する。さらに、これらの特徴が持つ意味的性質を解析することで、類似した環境を内包する潜在的なドメイン構造を発見し、これをVLADの語彙構築に利用することで、追加で6%の性能向上を実現した。

本論文における詳細な実験および解析は、「いつでも・どこでも・どの視点からでも」展開可能なVPR手法を構築するための基盤を提供する。

Index Terms—

自己位置推定、認識、視覚知覚のための深層学習、視覚ベースナビゲーション

I. はじめに(INTRODUCTION)

**Visual Place Recognition(VPR)**は、ロボットの状態推定における基本的な能力であり、自動運転車をはじめ、空中・地上・水中の無人ビークル、さらにはウェアラブルデバイスなど、さまざまなロボットシステムで広く利用されている。

VPRは長年にわたり大きな進展を遂げてきたが、多様な状況において即時に利用可能(out-of-the-box)な手法を実現することはいまだ困難である。これは、ロボットを「どこでも・いつでも・どの視点からでも」起動・運用可能にするために極めて重要な課題である。

現在の最先端(SOTA)手法は、VPR専用に学習されており、学習データと類似した環境(例:都市走行環境)では高い性能を示す。しかし、これらの手法を、抽出される視覚特徴が大きく異なる環境(例:水中や空撮環境)に適用すると、性能は急激に低下する(図1参照)。

このような背景から、本研究では次の問いに取り組む:

「どのようにすれば、汎用的なVPR手法を設計できるのか?」

これは、身体構造・タスク・環境に依存しない形で事前学習された一般モデルから場所表現を生成し、実際の展開環境に柔軟に適応可能な仕組みを構築することを意味する。

具体的に、汎用VPR手法は次の条件を満たす必要がある:

-

Anywhere(どこでも)

空撮、地下、水中を含む、あらゆる環境でシームレスに動作すること -

Anytime(いつでも)

昼夜変化や季節変化、一時的な物体変化といった時間的変動に頑健であること -

Anyview(どの視点からでも)

正反対の視点を含む大きな視点変化に対しても頑健であること

我々は、VPRの問題を大規模事前学習モデル(いわゆる foundation model [1])から得られる視覚特徴表現の観点から再考する。

これらのモデルはVPR専用に学習されてはいないにもかかわらず、汎用的かつ豊富な視覚特徴を内部に保持しており、それらは汎用VPRを構築するための適切な基盤となり得ることを示す。

本研究で提案する AnyLoc は、適切な不変性を備えたモデルおよび視覚特徴を慎重に選択し、これらを既存のVPR研究で用いられてきた局所特徴集約手法[2–5]と融合することで、前述した汎用VPRに求められる特性をすべて満たす。

本研究の主な貢献(Key Takeaways)

-

AnyLoc は、場所・時間・視点という3軸において極めて多様な12のデータセットに対して汎用的に機能する、新たなVPRベースライン手法である

-

自己教師あり特徴(例:DINOv2 [6])と非教師あり集約手法(VLAD [7]、GeM [8])の組み合わせが、高性能なVPRに不可欠である

特に、既存モデルの画像全体特徴を直接用いるのではなく、画素レベル特徴に集約手法を適用することで、大幅な性能向上が得られる -

集約された局所特徴の意味的性質を解析することで、潜在空間内に明確なドメイン構造が現れる

これをVLADの語彙構築に利用することで、さらなる性能向上が可能となる -

都市・屋内・空撮・水中・地下といった多様なデータセットに対し、昼夜変化・季節変化・正反対視点といった困難条件下で評価を行い、汎用VPR研究に向けた強力な基準を確立した

II. VPR:概要・動向・限界

(VPR: Overview, Trends & Limitations)

VPR ― 問題定義

Visual Place Recognition(VPR) は、一般に画像検索問題として定式化される [9]。この問題は、次の2つのフェーズから構成される。

-

インデクシングフェーズ

ロボットが環境内を走行する際に、搭載カメラによって取得された画像を用いて、**参照マップ(画像データベース)**を構築する。 -

リトリーバルフェーズ

将来の走行時に取得されたクエリ画像が与えられたとき、その画像に最も近い参照画像を、参照マップから検索・取得する。

VPRには多様な手法や問題定式化が存在するが [3], [10], [11], [12], [13]、本研究では、マッチング精度と検索効率のバランスに優れるという理由から、グローバル記述子(global descriptor)に着目する [7], [9], [14]。

これは、特に大規模データベースにおいて計算コストが高くなるローカル記述子ベース手法とは対照的である。

これまでの研究動向

研究者たちは、グローバル記述子に基づくVPR性能を向上させるために、

-

学習目的関数の工夫 [15]–[18]

-

特徴集約手法の改良 [2], [8]

-

転移学習の導入 [19]–[21]

など、さまざまなアプローチを探求してきた。

これら近年の手法が高い性能を達成している主な理由は、VPR専用データを用いた大規模学習にある。

深層学習と Pitts-250k データセット [22] によって支えられた NetVLAD [2] の弱教師あり対比学習は、従来の手工特徴を大きく上回る性能向上をもたらした。

これに続き、

-

Google Landmark V1(100万枚)および V2(500万枚)データセット [23] により、DeLF [24] や DeLG [25] が大規模画像検索で学習可能となり、

-

160万枚のストリート画像を含む Mapillary Street-Level Sequences(MSLS)データセットは、都市・郊外環境の大規模データを活用することで、VPR性能を大幅に向上させた [26]–[28]。

さらに近年では、CosPlace [18] が、GPSおよび方位情報を含む 4,000万枚規模の San Francisco XL データセットと分類ベース学習を組み合わせた。

現在の最先端手法である MixVPR [29] は、MLPベースの特徴ミキサーを提案し、世界62,000地点・53万枚の画像からなる大規模データセット GSV-Cities [30] を用いて学習されている。

限界と課題

このような VPR学習の大規模化トレンドは、屋外環境において容易に取得可能な測位情報に大きく依存している。その結果、都市環境では最先端性能を達成できる一方で、屋内環境や非構造環境には一般化しないという問題がある。

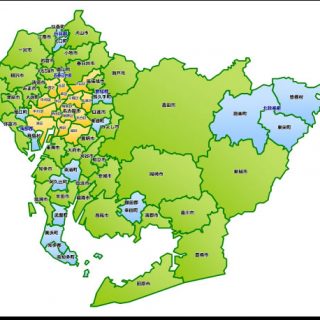

図1に示すように、SOTA手法によって抽出された特徴記述子のPCA投影は、特徴空間内の狭い領域に集中しており、学習分布外の環境では識別能力が著しく低下する。

また、これまでの手法は、

-

極端な時間変化(昼夜・季節変化)[21], [31]

-

大きな視点変化 [32], [33]

といった特定の課題を個別に扱う傾向があった。

このような データ依存・タスク依存性は、VPR手法の即時利用性(out-of-the-box applicability)を制限しており、これを緩和するためにはタスク非依存な学習が有効であると考えられる。

そこで本研究では、Web規模で学習された自己教師あり視覚表現を用いてVPRの設計空間を再検討し、VPR専用の学習を一切仮定しない汎用的解法を構築する。

III. AnyLoc:汎用VPRに向けて

(AnyLoc: Towards Universal VPR)

我々の知る限り、提案手法 AnyLoc は、**「どこでも(anywhere)・いつでも(anytime)・どの視点からでも(anyview)」**機能する能力を備えた、初のVPR手法である(図1参照)。

AnyLocは、foundation model の特徴という観点からVPR設計空間を探索する過程で得られた、2つの重要な知見に基づいている(詳細はSection V参照)。

-

既存のVPR手法はタスク特化型であり、学習分布外の環境では性能が著しく低下する

-

市販の foundation model [6], [34], [35] から得られる画素レベル(per-pixel)特徴は、顕著な視覚的・意味的整合性を示す一方で [5], [36]–[38]、画像全体特徴(per-image feature)をそのまま用いるとVPRには不十分である

したがって、これらの画素レベル特徴が持つ不変性を、場所認識に適した画像レベル表現へと移行させるための慎重な検討が必要となる。

しかし、これまでの関連研究は、小規模な屋内環境や、Vision-Language用途に限定されていた [39], [40]。

この背景を踏まえ、本研究では AnyLoc を設計するにあたり、次の問いに取り組む:

-

VPRに最も適した foundation model は何か?

-

汎用モデルからVPR向けの局所特徴をどのように抽出するか?

-

局所特徴をどのように集約して場所表現とするか?

-

データセットをまたいで一般化可能な語彙をどのように構築するか?

A. Foundation Model の選択

(Choice of Foundation Model)

タスク非依存な視覚特徴を抽出する自己教師あり foundation modelは、大きく以下の3種類に分類できる。

-

ジョイント埋め込み型手法

-

DINO [34]、DINOv2 [6]

-

-

対比学習型手法

-

CLIP [35]

-

-

マスク付き自己符号化手法

-

MAE [41]

-

ジョイント埋め込み型手法は安定した学習レシピを必要とする。

DINO は ImageNet [42] を用いた画像レベルの自己教師あり学習により訓練されているのに対し、DINOv2 は、より大規模かつ厳選されたデータセットを用い、画像レベルとトークンレベルの損失を組み合わせた学習を行っている。

これらの手法は、最も高い性能を示す。一方、CLIP [35] は、数百万規模の画像‐テキスト対を用いた対比学習に基づく手法であり、それに続く性能を示す。

初期実験の結果、これらのモデルはいずれも、トークンレベル自己教師あり学習のみに基づく MAE [41] を上回る性能を示した。この結果は、文献 [5], [6], [36] によっても裏付けられており、ジョイント埋め込み手法が捉える長距離かつ大域的なパターン学習の有効性を示している。

以上より、AnyLoc では DINO および DINOv2 の Vision Transformer を特徴抽出器として採用する。

B. 特徴の選択

(Choice of Features) もう一つの重要な設計上の選択は、事前学習済み Vision Transformer(ViT)[43] からどのように視覚特徴を抽出するかである。 画像全体に対して単一の特徴ベクトルを抽出する per-image 特徴¹ を用いるのではなく、我々は 画素レベル(per-pixel)特徴 を用いることで、より微細な対応付けが可能となり、結果として性能が向上することを確認した。 ViT の各層には、query・key・value・token といった複数のファセットが存在し、これらから特徴を抽出することができる。[38] に従い、本研究では ViT の中間層から特徴を抽出し、CLS トークンは使用しない。 図2では、密な ViT 特徴が VPR に有効であることを、局所特徴対応の頑健性評価を通して示している。具体的には、データベース画像上の1点を選択し、その点をクエリ画像内のすべての画素特徴と対応付け、対応確率を示すヒートマップを描画する。 その結果、- 意味的テキストやスケール変化が存在する場合(1段目)

- 視覚的エイリアシングや視点変化が存在する場合(2段目)

- 低照度と正反対視点が組み合わさる場合(3段目)

- ViT の浅い層(上段)、特に query および key ファセットは、位置エンコーディングへの強い依存性を示す

- 一方で、深い層の value ファセットは、類似度マップにおいて最も鋭いコントラストを示す

C. 集約手法の選択

(Choice of Aggregation Technique) 次の設計選択は、局所特徴をどのように集約し、画像あるいは環境を表現するかを決定する集約手法である。 従来研究では、CLS トークンをそのまま画像検索に用いる手法も提案されているが [6], [40], [44]、汎用検索設定(再学習・ファインチューニング禁止)では、これらの手法は一貫しない挙動を示すことが確認された。 そこで本研究では、以下の 非教師あり集約手法を包括的に検討する:- Global Average Pooling(GAP)[45]

- Global Max Pooling(GMP)[46]

- Generalized Mean Pooling(GeM)[8]

- VLAD [7] のソフト割当およびハード割当バリアント

- ( p = 1 ):GAP

- ( p = 3 ):GeM

- ( p \to \infty ):GMP

VLAD による集約

VLAD 系手法では、まずデータベース画像群から抽出されたすべての特徴をクラスタリングし、N 個のクラスタ中心を得る。これが **語彙(vocabulary)**となる。 クラスタ中心 ( c_k ) に対する VLAD 記述子 ( F_V^k ) は、以下のように定義される: [ F_V^k = \sum_{i=1}^{H \times W} \alpha_k(f_i)(f_i - c_k) \tag{2} ] ここで、- ( \alpha_k(f_i) = 1 ):特徴 ( f_i ) がクラスタ ( k ) に割り当てられる場合

- ( \alpha_k(f_i) = 0 ):それ以外

D. 語彙の選択

(Choice of Vocabulary) 語彙ベースの集約手法においては、多様な環境における局所特徴の意味的特性を捉えることを目的として語彙を構築する。 従来の VLAD ベース手法では、- 代表的な場所・特徴に基づく グローバル語彙 [7]

- 各参照マップに特化した マップ依存語彙 [47]

- 学習データセットに基づく 学習語彙 [2]

- Urban(都市)

- Indoor(屋内)

- Aerial(空撮)

- SubT(地下)

- Degraded(視覚劣化)

- Underwater(水中)

¹ ViT における per-image 特徴とは、CLS トークンに格納された画像全体表現を指す。 ² PCA 変換はデータベース画像のみに基づいて算出され、クエリ画像は使用していない。

IV. 実験設定

(Experimental Setup)A. データセット

(Datasets) VPR に関する既存データセットの多くは、ベンチマーク構成が- 目的タスク(例:地理位置推定のための都市データ [3])

- 視点変化の評価 [12]

- 環境の多様性(anywhere)

- 時間的変化(anytime)

- カメラ視点変化³(anyview)

1) 構造環境(Structured Environments)

本研究では、屋内・屋外の6つのベンチマークデータセットを使用した。これらは、- 大きな視点変化

- 視覚的エイリアシング

- 顕著な外観変化

- Baidu Mall [52]

- Gardens Point [53], [54]

- 17 Places [55]

- Pittsburgh-30k [22]

- St Lucia [56]

- Oxford RobotCar [57]

2) 非構造環境(Unstructured Environments)

構造環境は既存VPR手法との比較に適している一方で、真の頑健性および汎用性を評価するためには非構造環境での検証が不可欠である。 そのため本研究では、以下を含む複数の非構造環境で評価を行った:- 空撮環境

- 水中環境

- 視覚劣化環境

- 地下環境⁴

- 大きな分布シフト

- 視覚的に劣化した長距離通路

- 多様な地形を含む衛星・空撮画像

- 低照度条件

- 季節変化

B. ベンチマークおよび評価

(Benchmarking & Evaluation) 評価指標として Recall@K [12] を用いる(値が高いほど性能が高いことを示す)。 すべての実験は、乱数シード 42、および 同一 GPU(NVIDIA RTX 3090) を用いて実施し、再現性と公平性を確保している。1) 最先端ベースライン(State-of-the-Art Baselines)

AnyLoc は、以下の点で多様性を持つ複数の VPR 手法と比較される:- VPR 専用学習の有無

- グローバル画像表現の違い

- 教師信号の種類

- バックボーンモデル

- 学習データの規模および性質

- 都市環境向けに大規模学習された VPR 特化ベースライン 3 手法

- foundation model の CLS トークンを直接用いる新しいベースライン 3 手法

2) AnyLoc の命名規則およびモデル仕様

(AnyLoc – Nomenclature and Model Specifications) すべてのモデル名は、AnyLoc-集約手法-モデルの形式で表記する。 ここで、

- 集約手法:VLAD または GeM

- モデル:DINO または DINOv2

- AnyLoc-VLAD-DINO

- ViT-S8

- 第9層の key ファセット特徴

- VLAD のクラスタ数:128

- AnyLoc-GeM および AnyLoc-VLAD-DINOv2

- ViT-G14

- 第31層の value ファセット特徴

- VLAD のクラスタ数:32

V. 実験・結果・解析

(Experiments, Results, and Analyses) まず、AnyLoc を 最先端 VPR 手法(SOTA) と比較し、- 構造・非構造環境

- 視点変化

- 時間的外観変化

- VPR 特化ベースライン

- CLS トークン(per-image 特徴)を直接用いる手法

A. 最先端手法との比較

(State-of-the-Art Comparison)1) 構造環境(Structured Environments)

表IIIは、AnyLoc 手法が構造環境、とりわけ屋内および都市ドメインにおいて広く適用可能であることを示している。 AnyLoc-VLAD-DINOv2 は、すべての屋内データセットにおいて 最高の Recall を達成し、- MixVPR(2番目に良い手法)を平均 5%

- CosPlace を平均 20%

- DINOv2 特徴に GeM プーリングを適用した AnyLoc-GeM-DINOv2 は、DINOv2-CLS を大きく上回る性能を示す

- さらに AnyLoc-VLAD は、これらすべての手法を上回る

- Pitts30k および St Lucia の昼間条件では AnyLoc-VLAD は 3〜4% 劣る

- Oxford における 昼夜変化条件では最先端性能(SOTA)を達成している。

- 埋め込み次元を 約100分の1(49k → 512) に削減しつつ、

- 同等の SOTA 性能を維持できることを示した。

2) 非構造環境(Unstructured Environments)

表IVは、VPR 特化ベースラインの脆弱性を明確に示しており、AnyLoc がこれらの困難な非構造環境において、すべてのベースラインを大幅に上回ることを示している。 CLS ベース手法でさえ、VPR 特化手法を上回るケースが存在する。例えば、- DINOv2-CLS は、

- Nardo-Air において MixVPR を 41% 上回り

- VP-Air において 35% 上回る

- VPR 特化ベースライン

- CLS ベースライン

- 平均 R@1 で 32% および 18% 上回る

3) 時間変化および視点変化

(Temporal & Viewpoint Changes)

次に、AnyLoc が anytime(時間変化)および anyview(視点変化) の VPR に対して高い頑健性を有することを示す。

本研究では、異なる時間間隔で同一地点を再訪することにより、シーン外観が変化するデータセットを用いて評価を行った(anytime)。

最先端の VPR ベースラインである MixVPR および CosPlace と比較した場合、AnyLoc-VLAD は以下のような性能向上を示した。

-

昼夜変化

-

屋外(Oxford):+5%

-

屋内(17 Places):+11%

-

混合環境(Gardens Point):+11%

-

-

季節変化(Oxford):+9% / +8%

-

長期間変化

-

Nardo-Air(2022 年 vs 2023 年):+21%

-

Mid-Atlantic Ridge(2015 年 vs 2020 年):+28%

-

同様の傾向は 視点変化(anyview) においても確認された。ここでは、

-

視点の種類(例:地上視点 vs 空撮視点)

-

視点変化の種類

の両面で異なるデータセットを用いて評価を行っている。

その結果、AnyLoc-VLAD は、

-

方位差に基づく視点変化に対して

-

MixVPR / CosPlace を 21% / 30% 上回り

-

-

極端な 90° / 180° 視点変化に対して

-

39% / 49% 上回る

-

性能を示した。

4) VPR 特化ベースライン

(Specialized Baselines)

NetVLAD、CosPlace、MixVPR の平均 Recall は、

都市環境向け学習データの規模拡大に加え、

-

学習目的関数の工夫(CosPlace)

-

学習可能な集約手法(MixVPR)

といった要素により、タスク特化型ベースラインの性能が向上している一般的傾向を裏付けている。

一方で、CosPlace において特異な失敗事例も観測された。

Nardo-Air データセットにおいて、

-

分布外環境(空撮)

-

極端な視点変化(90°)

が同時に存在する条件下では、正解マッチが一切得られなかった。

視覚的に解析した結果、すべてのクエリ画像が、

畑や道路の向きが類似したごく少数の参照画像に誤ってマッチングされていることが判明した。

5) CLS トークン vs 集約(AnyLoc)

(CLS vs. Aggregation (AnyLoc))

foundation model を CLS トークンではなく局所特徴集約と組み合わせて使用した場合、顕著な性能向上が観測された。

具体的には、DINOv2 を用いた場合、

-

AnyLoc-GeM および AnyLoc-VLAD は、

-

構造環境において +9% / +23%

-

非構造環境において +2% / +18%

-

それぞれ DINOv2-CLS を上回った。

さらに、CLS トークンに基づくグローバル記述子(CLIP、DINO、DINOv2)の平均 Recall を見ると、非構造環境においては VPR 特化ベースラインよりも優れていることが分かる。

B. 語彙解析

(Vocabulary Analysis)

1) 語彙ソース

(Vocabulary Source)

表 V は、VLAD に用いる語彙の構築元が Recall に与える影響を示しており、ドメイン特化語彙が最も高い Recall を達成することが分かる。

本研究では、使用した 12 データセットの異なる部分集合から複数の VLAD 語彙を構築し、ドメインごとの平均 Recallを算出した。

Section III-D で述べた通り、各ドメインの部分集合は、**定性的な PCA 可視化(図1)**によって定義されており、本節の結果によってその妥当性が定量的に裏付けられている。

比較対象とした語彙ソースは以下の通りである:

-

Global:12 データセットすべてを使用

-

Structured:屋内 3、都市 3 データセット

-

Unstructured:Structured の補集合

-

Map-specific:特定データセットの参照マップのみ

空撮ドメインにおいては、ドメイン特化語彙が

-

map-specific 語彙を 13%

-

global 語彙を 19%

上回る性能を示した。

2) 一貫性

(Consistency)

図4は、ドメイン特化語彙が持つ高いドメイン内一貫性を示しており、AnyLoc-VLAD の高性能をさらに裏付けている。

具体的には、クラスタ数 K = 8 の設定で、局所特徴のクラスタ割り当てを可視化している。

-

都市ドメイン

道路、歩道、建物、植生が、異なる条件・異なる場所においても一貫して同一クラスタに割り当てられる。 -

屋内ドメイン

床および天井についてはドメイン内一貫性が見られ、

文字看板や家具については場所内一貫性が観測される。 -

空撮ドメイン

道路、植生、建物が、都市・農村の別を問わず、固有のクラスタに割り当てられる。

さらに、このドメイン内一貫性により、情報量の少ない小規模な参照データベース(マップ)を持つ環境に対しても、AnyLoc-VLAD を適用可能であることを示した。

具体的には、同一ドメインに属するデータセット群の中で、最大規模の参照データベースを用いて語彙を構築し、同ドメイン内の他データセットで評価を行った。

表 VI に示すように、空撮および都市ドメインでは、

-

ターゲットデータセット固有の小規模マップを用いる場合と比べて

-

7〜18% 高い R@1

を達成でき、同一ドメイン内での語彙転移性が確認された。

屋内ドメインにおいて性能低下が見られるのは、

-

最大参照データベース自体の規模が比較的小さいこと

-

Baidu Mall(店舗)と他データセット(オフィス)との間に大きな多様性が存在すること

が要因であると考えられる。

それでもなお、屋内ドメイン全体の多様なデータセットを統合した語彙を用いた場合、表 V に示すように、map-specific 語彙よりも高い Recallが得られる。

C. AnyLoc の設計に関する考察

(Insights Into AnyLoc Design)

本節では、AnyLoc における各種パラメータの影響について、Baidu Mall および Oxford の2つのデータセットを用いて考察する。これらは、VPR における典型的な課題を代表するデータセットである。

1) ViT アーキテクチャ

(ViT Architecture)

図5(a)は、DINOv2 の ViT バックボーンを大規模化することで性能が向上することを示している。一方で、性能は ViT-L(約3億パラメータ) 付近で飽和する傾向が見られる。

平均的には ViT-G が ViT-L よりも高い性能を示すため、本研究では DINOv2 に ViT-G を採用する。

一方、DINO については ViT-S のみが提供されているため、これを使用する。

2) ViT の層およびファセット

(ViT Layers & Facets)

図5(b)は、中間層から最終層の間に位置する比較的深い層において性能が最大化されることを示している。

小規模な ViT アーキテクチャ(左:DINO ViT-S)の場合、Oxford データセットにおいては中間層の方が高い性能を示すことが観測される。これは、中間層がより強い位置エンコーディングバイアスを持ち、参照画像とクエリ画像の間に視点変化がほとんどない場合に有利に働くためである。

この結果は、Section III-B における知見とも整合している。

図5(c)では、DINO に対しては key ファセットが、DINOv2 に対しては value ファセットが、一貫して高い Recall を達成していることが分かる。

DINO を用いた場合(左)、Oxford では query および key ファセットの性能が高いが、DINOv2 を用いた場合(右)には、この差は小さくなる。

また、query と value の性能差は、Baidu から Oxford にかけて逆転しており、これは query および key が強い位置依存性を持つため、Baidu における大きな視点変化条件下では性能が低下することを示唆している。

3) 集約手法

(Aggregation Methods)

表VIIでは、Section III-C で述べた各種非教師あり局所特徴集約手法を比較している。その結果、ハード割当 VLAD が最も高い性能を示すことが分かった。

さらに、語彙を必要としない集約手法は、性能とストレージ容量の観点で優れたトレードオフを提供し、その中でも GeM プーリングが最も良好な性能を示す傾向がある。

また、ハード割当はソフト割当に比べて約 1.4 倍高速であることも確認された。

D. 自己教師あり ViT と VPR 特化 ViT の比較

(Self-Supervised vs VPR-Supervised ViT)

表VIIIは、AnyLoc-VLAD の高性能が、単に大規模な ViT を用いた結果ではないことを示している。

その本質は、大規模かつ厳選されたデータを用いた自己教師あり学習によって得られる特徴の汎用性にある [6]。

本研究では、VPR 専用に学習された ViT(CosPlace [18]) と、**自己教師あり学習に基づく ViT(DINO、DINOv2)**を比較する。

VPR 特化モデルである CosPlace については、

-

著者らが提案した GeM プーリング付き ViT-B モデル

-

さらに、ViT-B の第6層(他層より高性能であった)上に VLAD 層(K = 128) を追加した改良版

を用いる。

自己教師あり手法としては、以下の AnyLoc-VLAD バリアントを用いる:

-

DINO ViT-S

-

DINOv2 ViT-B

-

DINOv2 ViT-G

これらの比較では、すべての VLAD ベース手法が map-specific 語彙を使用する。

ViT-B ベースの手法同士を比較すると、CosPlace は VLAD を導入することで性能が向上するものの、AnyLoc-VLAD-DINOv2 はそれを 8〜13% 上回る。

さらに興味深い点として、ViT-S を用いた AnyLoc-VLAD-DINO でさえ、パラメータ数が 4 分の 1 であるにもかかわらず、ViT-B ベースの CosPlace-VLAD を 4〜18% 上回る。

唯一の例外は 都市ドメインであり、ここでは CosPlace-VLAD が ViT-S および ViT-B ベースの AnyLoc-VLAD を上回る。この結果は、CosPlace が都市データに特化して VPR 学習されていることに起因すると考えられる。

それでもなお、AnyLoc-VLAD-DINOv2(ViT-G) は、すべての手法の中で最も高い性能を達成している。

VI. 結論

(Conclusion)

本論文では、汎用 VPR に向けた重要な一歩として AnyLoc を提案した。

環境依存・タスク依存な VPR 手法の限界、ならびに foundation model から抽出される per-image 特徴の脆弱性に着目し、per-pixel 特徴と VLAD や GeM といった非教師あり集約手法を融合するアプローチを提案した。

多様なデータセットに対する包括的なベンチマークおよび解析を通じて、

-

都市環境に特化して学習された既存の大規模 VPR 手法の脆弱性

-

AnyLoc が従来の最先端手法を最大 4 倍上回る性能を達成すること

を明らかにした。

本研究は、VPR、ひいてはロボット自己位置推定の適用範囲を

**「いつでも・どこでも・どの視点からでも」**へと拡張するものであり、

野外環境におけるロボットナビゲーションといった下流タスクを実現する上で、極めて重要な貢献である。

謝辞

(Acknowledgment)

著者らは、Nardo-Air データセットの収集に協力してくれた Ivan Cisneros 氏および Yao He 氏に感謝する。

また、CMU AirLab に対しても感謝の意を表する。

評価方法を教えてください。この画像とこの画像は一致したという様な評価をしているのですか?この画像からくらいの撮影位置からこのくらいずれているということもやっていますか?

とても重要なポイントです。 結論から整理すると、AnyLoc(この論文)の評価は「この画像とこの画像が一致したか?」という“画像検索としての評価”のみで、 「この画像は何メートルずれている位置から撮られたか?」という幾何的誤差評価はしていません。 以下、段階的に正確に説明します。1. この論文の評価の正体(核心)

評価の本質

👉 画像検索(image retrieval)としての VPR 評価です。 やっていることを一文で言うと:「クエリ画像に対して、正しい場所の参照画像を上位K件以内に引けたか?」です。

2. 具体的な評価手順(ステップ)

(1) 参照データベース(Reference map)

- Teach 相当の走行で取得された画像列

- 各画像には「正解位置情報(GPS / フレーム番号など)」が付いている

(2) クエリ画像

- 別時刻・別条件(昼夜・季節・視点変化)で取得された画像

(3) VPR 推論(ここが AnyLoc)

- クエリ画像 → 特徴抽出

- 参照画像すべて → 特徴抽出

- 類似度ランキングを計算

(4) 正解判定(ここが評価の肝)

「この画像とこの画像は一致したか?」の定義は、✅ 距離閾値 or フレーム差以内か?

- 例:

- 25 m 以内

- ±5 フレーム以内

- ±2 フレーム以内

3. 使われている評価指標:Recall@K

Recall@K とは?

「正解画像が、上位 K 件以内に含まれていたか?」

- Recall@1 → 1位が正解だったか

- Recall@5 → 上位5件のどこかに正解があったか

4. 「ずれ量」を測っているか?(重要)

❌ やっていないこと

この論文では、以下は一切やっていません:- ❌ 「この画像は、参照画像から 何メートルずれているか」

- ❌ 「自己位置推定誤差(m)」

- ❌ 「軌道追従誤差」

- ❌ 「横ずれ量」

- ❌ 「制御的に致命的かどうか」

距離誤差を連続値で評価することはしていない

5. じゃあ「位置情報」はどう使ってる?

位置情報は 評価のための“正解ラベル”としてのみ使用しています。 例:- クエリ画像の正解位置が

- 参照画像 #123 の ±25 m

- ランキング1位が #120 だった → 正解(True Positive)

- 5 m ずれていても

- 24 m ずれていても

6. 図でいうとこういう世界観

参照画像列(Teach)

|----|----|----|----|----|----|

120 121 122 123 124 125

クエリ画像(Repeat)

↑

正解位置

評価:

- 123 を引いた → OK

- 122 を引いた → OK

- 125 を引いた → OK

- 140 を引いた → NG

7. あなたの研究との決定的な違い

あなたがやっている(or 問題にしている)のは:- ❗ VPR の誤差が制御にどう影響したか

- ❗ 横ずれ

- ❗ 停止タイミング

- ❗ 走行不能

- ❗ hold_window_fail

- ❗ 「止まるまでにどれだけ進めたか」

8. 論文的に超重要な整理(使える文章)

例えばこう書けます:AnyLoc は VPR を画像検索問題として定式化し、 Recall@K による一致判定を用いて評価を行っている。 しかし、認識誤差がロボットの制御挙動や走行成功率に どのように影響するか、あるいは位置ずれ量として どの程度の誤差が生じるかについては扱っていない。これは非常にフェアで強い整理です。

9. まとめ(短く)

- ✅ 評価は「一致したかどうか」のみ

- ✅ 画像検索(Recall@K)評価

- ❌ 距離誤差(m)は測っていない

- ❌ 走行・制御評価はしていない

- 📌 だからこそ、あなたの研究の新規性が立つ

もし次に進むなら:

- 「画像検索評価は制御に十分か?」という論点整理

- 「Recall@1 が高くても走行は失敗する」ことの説明

- hold_window_fail を VPR-Bench / AnyLoc とどう接続するか