概要 本論文では、大規模言語モデル(LLM)、独自の2次元拡散モデル、およびコンテキストの設定、ストーリーの進行、行動制御のためのマルチエージェントシミュレーションを用いて、1 IP(知的財産)のための高品質なエピソードコンテントを生成する試みを紹介する。 GPT-4のような強力なLLMは、テレビ番組の膨大な4 データに基づいて訓練されているため、適切なガイダンス5 があれば、ユーザは完全なシーズンを書き込むことができるだろう。そして、自分自身を主人公として登場させることもできるかもしれない」1。

1CreativelimitationsofexistinggenerativeAISystems10 CurrentgenerativeAIsystemssuchasStableDiffusion(ImageGenerator)andChatGPT(Large11 LanguageModel)excelatshort-termgeneraltasksthroughpromptengineering.However,theydo12 notprovidecontextualguidanceorintentionalitytoeitherauseroranautomatedgenerativestory13 system(showrunner2)aspartofalong-termcreativeprocesswhichisoftenessentialtoproducing14 high-qualitycreativeworks,especiallyinthecontextofexistingIP’s.

1.1Livingwithuncertainty

Byusingamulti-agent3simulationaspartoftheprocesswecanmakeuseofdatapointssuchas17 acharacter’shistory,theirgoalsandemotions,simulationeventsandlocalitiestogeneratescenes18 andimageassetsmorecoherentlyandconsistentlyalignedwiththeIPstoryworld.TheIP-based19 simulationalsoprovidesaclear,wellknowncontexttotheuserwhichallowsthemtojudgethe20 generatedstorymoreeasily.Moreover,byallowingthemtoexertbehavioralcontroloveragents,21 observetheiractionsandengageininteractiveconversations,theuser’sexpectationsandintentions22 areformedwhichwethenfunnelintoasimpleprompttokickoffthegenerationprocess.23 Oursimulationissufficientlycomplexandnon-deterministictofavorapositivedisconfirmation.24 Amplificationeffectscanhelpmitigatewhatweconsideranundesired"slotmachine"effectwhich25 we’llbrieflytouchonlater.Weareusedtowatchingepisodespassivelyandthetimespanbetween26 inputand"endofscene/episode"discouragesimmediatejudgmentbytheuserandasaresultreduces27 theirdesireto"retry".Thisdisproportionalityoftheuser’sminimalinputpromptandtheresulting28 high-qualitylong-formoutputintheformofafullepisodeisakeyfactorforpositivedisconfirmation.29 Whileusingandpromptingalargelanguagemodelaspartoftheprocesscanintroduce"several30 challenges".4Someofthem,likehallucinations,whichintroduceuncertaintyorinmorecreative31 terms"unexpectedness",canberegardedascreativeside-effectstoinfluencetheexpectedstory32 outcomeinpositiveways.Aslongastherandomnessintroducedbyhallucinationdoesnotleadto33 implausibleplotoragentbehaviorandthesystemcanrecover,theyactashappy-accidents5,aterm34 oftenusedduringthecreativeprocess,furtherenhancingtheuserexperience.

1既存の再生AISシステムにおける創造性の限界10 現在の再生AIシステムであるStableDiffusion(ImageGenerator)やChatGPT(Large11 LanguageModel)は、プロンプトエンジニアリングによる短期的な生成タスクを得意としている。 しかし、特に既存のIPとの関連において、質の高いクリエイティブな作品14を生み出すために不可欠な長期的なクリエイティブ・プロセスにおいて、利用者や自動生成ストーリー13システム(showrunner2)に対して、コンテクストのガイダンスや意図性を提供することはできない。

1.1不確実性を生きる

マルチエージェント3シミュレーションをプロセスの一部に使用することで,キャラクタの歴史,目標,感情,シミュレーショ ンイベント,地域性などのデータポイントを利用し,IP ストーリーの世界と首尾一貫して整合性のあるシーン18 と画像資産を生成することができる. IPベースのシミュレーション19 は,利用者に明確でよく知られたコンテクストを提供し,生成された20 ストーリーを簡単に予算化することを可能にする.さらに,利用者がエージェントを行動的に制御し21 ,エージェントの行動を観察し,インタラクティブな会話に参加できるようにすることで,利用者の期待と意図22 が形成され,生成プロセスを開始する簡単なプロンプトにつながる23.私たちのシミュレーションは十分に複雑で非決定論的であるため、肯定的な確証が得やすい24 。増幅効果は、後で簡単に触れるが25 、「スロットマシーン」効果として望まれ ていると考えられるものを生み出すのに役立つ。私たちはエピソードを受け身 で見ることに慣れており、入力から「シーン/エピソードの終わり」までの時間 は、利用者の即時的な判断を妨げ、その結果、「再挑戦」する意欲を減退させる27 。 このように、利用者のわずかな入力促 進と、その結果得られる28 豊かなエピソードの中での質の高い長文出力との不均衡は、肯定的な確認29 の要因になる。プロセスの一部で大域的言語モデルを使用し、プロンプトを出すことは、「いくつかの課題」30 を引き起こす可能性がある。 幻覚がもたらすランダム性が、ありえないような運動原 子の行動33 を引き起こさず、システムが回復できる限り、創造的なプ ロセスでよく使われる用語34 である「不幸な事故」5 を起こし、使用経験をさらに高める。

1.2TheIssueof‘TheSlotMachineEffect’incurrentGenerativeAItools36 TheSlotMachineEffectreferstoascenariowherethegenerationofAI-producedcontentfeelsmore37 likearandomgameofchanceratherthanadeliberatecreativeprocess6.Thisisduetotheoften38 unpredictableandinstantaneousnatureofthegenerationprocess.39 Currentoff-the-shelfgenerativeAIsystemsdonotsupportorencouragemultiplecreativeevaluation40 stepsincontextofalong-termcreativegoal.Theirinterfacesgenerallyfeaturevarioussettings,such41 asslidersandinputfieldswhichincreasethelevelcontrolandvariability.Thefinaloutputhowever,42 isgeneratedalmostinstantaneouslybythepressofabutton.Thisinstantaneousgenerationprocess43 resultsinimmediategratificationprovidingadopaminerushtotheuser.Thisrewardmechanism44 wouldbegenerallyhelpfultosustainamulti-stepcreativeprocessoverlongperiodsoftimebut45 currentinterfaces,thefrequencyoftherewardandalackofprogression(stuckinaninfiniteloop)46 canleadtonegativeeffectssuchasfrustration,theintention-actiongap7oralossofcontroloverthe47 creativeprocess.Thegapresultsfrombehavioralbiasfavoringimmediategratification,whichcan48 bedetrimentaltolong-termcreativegoals.

50 inasimulationandtheabovementioneddisproportionalityandtimespanbetweeninputandoutput51 helpmitigatethem.Inadditionweseeopportunitiesinthesimulationforin-characterdiscriminators52 thatparticipateinthecreativeevaluationprocess,suchasanagentreflectingontheroletheywere53 assignedtoorascenetheyshouldperformin.54 Themulti-step"trialanderror"processofthegenerativestorysystemisnotpresentedtotheuser,55 thereforeitdoesn’tallowforinterventionorjudgment,avoidingthenegativeeffectsofimmediate56 gratificationthroughauser’s"acceptorreject"decisions.Itdoesnotmattertotheuserexperience57 howoftentheAIsystemhastoretrydifferentpromptchains8aslongasthegenerationprocessis58 notnegativelyperceivedasidletimebutintegratedseamlesslywiththesimulationgameplay.The59 useronlyactsasthediscriminatorintheveryendoftheprocessafterhavingwatchedthegenerated60 sceneorepisode.ThisisalsoanopportunitytoutilizetheconceptofReinforcementLearning61 throughHumanFeedback(RLHF)forimprovingthemulti-stepcreativeprocessandasaresultthe62 automaticallygeneratedepisode.63 1.3LargeLanguageModels64 LLMsrepresenttheforefrontofnaturallanguageprocessingandmachinelearningresearch,demon-65 stratingexceptionalcapabilitiesinunderstandingandgeneratinghuman-liketext.Theyaretypically

builtonTransformer-basedarchitectures,aclassofmodelsthatrelyonself-attention9mechanisms.67 Transformersallowforefficientuseofcomputationalresources,enablingthetrainingofsignificantly68 largerlanguagemodels.GPT-4,forinstance,comprisesbillionsofparametersthataretrainedon69 extensivedatasets,effectivelyencodingasubstantialquantityofworldlyknowledgeintheirweights.

1.2現在のジェネレイティブAIツールにおける「スロットマシン効果」の問題36 スロットマシン効果とは、AIによって制作されたコンテンツの生成が、自由な創造的プロセ スというよりも、ランダムなガチャガチャゲームのように感じられるような状況を指す39 。しかし、最終的な出力42 は、ボタンを押すことでほぼ瞬時に生成される。この瞬時の生成プロセ ス43 の結果、中途半端なカテゴリの評価が行われ、ユーザーにとって魅力的なものとなる。 このようなメカニズム44 は、一般的に、多段階の創造的プロセ スを長期間にわたって持続させるのに役立つだろうが、45 現状のインターフェイスでは、前進と後退(無限ループから抜け出せない)46 の頻度が高いため、フラストレーション、意図と行動のギャップ、創造的プロセ ス47 のコントロール不能といった悪影響が生じる可能性がある。 このギャップは、長期的な創造的目標に悪影響を及ぼしかねない、中途半端な批 判化を好む行動バイアスから生じている。

さらに、創造的評価プロセスに参加する特性上の差別化要因52 のために、シミュレーションの中に、自分が割り当てられたチーム53 や、自分が実行すべきチーム54 を反映するような機会を見出すことができる。そのため、介入や判断が行われることはなく、利用者の「受け入れ るか、拒否するか」の決定を通じて、即座に満足感を得るという否定的な効果を回避す ることができる。 AIシステムがさまざまなプロンプト・チェーン8 をどの程度試行するかは、使用経験57 にとって問題ではない。 このことは、ヒューマン・フィードバック(RLHF)による強化学習61 の概念を、多段階の創造的プロセスの改善や、自動生成されたエピソード62 の改善に活用する機会にもなる63。1.3大規模言語モデル64 LLMは、自然言語処理と機械学習研究の最前線に位置するものであり、人間の語彙を理解し、それを生成する上で卓越した能力を示すものである。

例えば、GPT-4 は数十億個のパラメータから構成され、膨大なデータセットの上で学習され、 その重みに相当量の世界的知識が効果的に記録されている。

CentraltothefunctioningoftheseLLMsistheconceptofvectorembeddings.Thesearemathematical71 representationsofwordsorphrasesinahigh-dimensionalspace.Theseembeddingscapturethe72 semanticrelationshipsbetweenwords,suchthatwordswithsimilarmeaningsarelocatedcloseto73 eachotherintheembeddingspace.InthecaseofLLMs,eachwordinthemodel’svocabularyis74 initiallyrepresentedasadensevector,alsoknownasanembedding.Thesevectorsareadjusted75 duringthetrainingprocess,andtheirfinalvalues,or"embeddings",representthelearnedrelationships76 betweenwords.Duringtraining,themodellearnstopredictthenextwordinasentencebyadjusting77 theembeddingsandotherparameterstominimizethedifferencebetweenthepredictedandactual78 words.Theembeddingsthusreflectthemodel’sunderstandingofwordsandtheircontext.Moreover,79 becauseTransformerscanattendtoanywordinasentenceregardlessofitsposition,themodel80 canformamorecomprehensiveunderstandingofthemeaningofasentence.Thisisasignificant81 advancementoveroldermodelsthatcouldonlyconsiderwordsinalimitedwindow.Thecombination82 ofvectorembeddingsandTransformer-basedarchitecturesinLLMsfacilitatesadeepandnuanced83 understandingoflanguage,whichiswhythesemodelscangeneratesuchhigh-quality,human-like84 text.85 Aswasmentionedpreviously,transformer-basedlanguagemodelsexcelatshort-termgeneraltasks.86 Theyareregardedasfast-thinkers.[Kahneman]12.Fastthinkingpertainstoinstinctive,automatic,87 andoftenheuristic-baseddecision-making,whileslowthinkinginvolvesdeliberate,analytical,and88 effortfulprocesses.LLMsgenerateresponsesswiftlybasedonpatternslearnedfromtrainingdata,89 withoutthecapacityforintrospectionorunderstandingtheunderlyinglogicbehindtheiroutputs.90 However,thisalsoimpliesthatLLMslacktheabilitytodeliberate,reasondeeply,orlearnfrom91 singularexperiences13inthewaythatslow-thinkingentities,suchashumans,can.Whilethese92 modelshavemaderemarkablestridesintextgenerationtasks,theirfast-thinkingnaturemaylimit93 theirpotentialintasksrequiringdeepcomprehensionorflexiblereasoning.Morerecentapproaches94 toimitateslow-thinkingcapabilitiessuchasprompt-chaining(seeAuto-GPT)showedpromising95 results.Largelanguagemodelsseempowerfulenoughtoactastheirowndiscriminatorinamulti-step

process.Thiscandramaticallyimprovetheabilitytoreasonindifferentcontexts,suchassolving97 mathproblems.1498 WemakeheavyuseofGPT-4toinfluencetheagentsinthesimulationaswellasgeneratingthe99 scenesforthesouthparkepisode.Sincetranscriptionsofmostofthesouthparkepisodesarepartof100 GPT-4’strainingdataset,italreadyhasagoodunderstandingofthecharacter’spersonalities,talking101 styleaswellasoverallhumoroftheshow,eliminatingtheneedforacustomfine-tunedmodel.102 However,wedoimitateslow-thinkingaspartofamulti-stepcreativeprocess.Forthisweuse103 differentpromptchainstocompareandevaluatetheeventsofdifferentscenesandhowtheyprogress104 theoverallstorytowardsasatisfactory,IP-alignedresult.Ourattempttogenerateepisodesthrough105 prompt-chainingisduetothefactthatstorygenerationisahighlydiscontinuoustask.15Theseare106 taskswherethecontentgenerationcannotbedoneinagradualorcontinuousway,butinstead107 requiresacertain”Eureka”ideathataccountsforadiscontinuousleapintheprogresstowards108 thesolutionofthetask.Thecontentgenerationinvolvesdiscoveringorinventinganewwayof109 lookingatorframingtheproblem,thatenablesthegenerationoftherestofthecontent.Examples110 ofdiscontinuoustasksaresolvingamathproblemthatrequiresanovelorcreativeapplicationof111 aformula,writingajokeorariddle,comingupwithascientifichypothesisoraphilosophical112 argument,orcreatinganewgenreorstyleofwriting.

これらのLLMの機能の中心は、ベクトル埋め込みという概念である。この埋め込みは、高次 元空間における単語やフレーズの数学的71 表現であり、単語間の意味的72 関係をとらえ、同じ意味を持つ単語が埋め込み空間の中で互いに73 近い位置に配置されるようにする。 LLMの場合、モデルの語彙に含まれる各単語は、最初はエンベッディングと呼ばれる 濃いベクトルで表現される。これらのベクトルはトレーニングの過程で調整75 され、最終的な値、つまり「エンベッディング」は学習された単語間の関係76 を表す。 さらに、Transformer は文の位置に関係なく、すべての文に対応することができるため、モデル80 は文の意味をより包括的に理解することができます。 LLM のベクトル連結とトランスフォーマーベースのアーキテクチャ82 の組み合わせは、より深く、より高度な83 言語理解を促進し、これが、このモデルが人間のような質の高い84 テキストを生成する理由である85。前述したように、トランスフォーマベースの言語モデルは、短時間のジェネレーショ ンタスクを得意とする86 。LLMは訓練データから学習したパターンに基 づいて迅 速に回答を生成するが89 、その出力の背後にある根本的な論理を内省 したり理解したりする能力はない90 。しかし、このことはまた、LLMが、人間のような思考速度の遅い個体には可能な、 繊細なモデリング、深い洞察、あるいは単一の経験からの学習といった能力を欠いているこ とを示唆している。 プロンプト・チェイニング(Auto-GPTを参照)のような、低 思考能力を抑制するための、より高度なアプローチ94 では、有望な95 結果が得られている。

これは、97の数学の問題を解くような、さまざまな状況での推 論能力を劇的に向上させる可能性がある1498。サウスパークのエピソードのほとんどはGPT-4の歪みデータセットの一部であ るため、登場人物の性格や話し方101 、そして番組全体のユーモアをすでによく理解し ており、カスタムチューニングモデルを使用する必要はない102 。しかし、多段階の創造的プロセスの一部であるスローシンキングを抑えるために、103 さまざまなプロンプト連鎖を使用して、さまざまな場面のイベントを比較評価し、全体的なストーリーが満足のいく、IPに沿った結果にどのように進展しているか104 を評価する。 このようなタスクでは、内容生成は逐次的または継続的に行うことはできないが、107 その代わりに、タスクの解決に向けたプロセスの非連続的な飛躍を説明する、ある種の「ユーレカ(Eureka)」アイデアが必要となる。 継続的でない課題の例110 としては、ある公式111 の斬新で創造的な応用を必要とする問題の解決、ジョークや謎解きの作成、科学的仮説や形而上学的112 論証の考案、あるいは新しい文体やスタイルの創造などがある。

1.4DiffusionModels114 Diffusionmodelsoperateontheprincipleofgraduallyaddingorremovingrandomnoisefromdata115 overtimetogenerateorreconstructanoutput.Theimagestartsasrandomnoiseand,overmany116 steps,graduallytransformsintoacoherentpicture,orviceversa.117 Inordertotrainourcustomdiffusionmodels,wecollectedacomprehensivedatasetcomprising118 approximately1200charactersand600backgroundimagesfromtheTVshowSouthPark.This119 datasetservesastherawmaterialfromwhichourmodelslearnedthestyleoftheshow.120 Totrainthesemodels,weemployDreamBooth.16Theresultofthistrainingphaseisthecreationof121 twospecializeddiffusionmodels.122 Thefirstmodelisdedicatedtogeneratingsinglecharacterssetagainstakeyablebackgroundcolor.123 Thisfacilitatestheextractionofthegeneratedcharacterforsubsequentprocessingandanimation,124 allowingustoseamlesslyintegratenewlygeneratedcharactersintoavarietyofscenesandsettings.h

6 Inaddition,thecharacterdiffusionmodelallowstheusertocreatea127 southparkcharacterbasedontheirownlooksviatheimage-to-image128 processofstablediffusionandthenjointhesimulationasanequally129 participatingagent.Withtheabilitytoclonetheirownvoice,it’seasy130 toimagineafullyrealizedautonomouscharacterbasedontheuser’s131 characteristiclooks,writingstyleandvoice.132 Thesecondmodelistrainedtogeneratecleanbackgrounds,witha133 particularfocusonbothexteriorandinteriorenvironments.Thismodel134 providesthe’stage’uponwhichourgeneratedcharacterscaninteract,135 allowingforawiderangeofpotentialscenesandscenariostobecreated.

7 However,it’simportanttonotethattheimagesproducedbythese138 modelsareinherentlylimitedintheirresolutionduetothepixel-based139 natureoftheoutput.Tocircumventthislimitation,wepost-processthe140 generatedimagesusinganAIupscalingtechnique,specificallyR-ESRGAN-4x+-Anime6B,which141 refinesandenhancestheimagequality.142 Forfuture2Dinteractivework,trainingcustomtransformerbasedmodelsthatarecapableof143 generatingvector-basedoutputwouldhaveseveraladvantages.Unlikepixel-basedimages,vector

graphicsdonotlosequalitywhenresizedorzoomed,thusofferingthepotentialforinfiniteresolution.145 Thiswillenableustogenerateimagesthatretaintheirqualityanddetailregardlessofthescaleat146 whichtheyareviewed.Furthermore,vectorbasedshapesarealreadyseparatedintoindividualparts,147 solvingpixel-basedpost-processingissueswithtransparencyandsegmentationwhichcomplicatethe148 integrationofgeneratedassetsintoproceduralworldbuildingandanimationsystems.

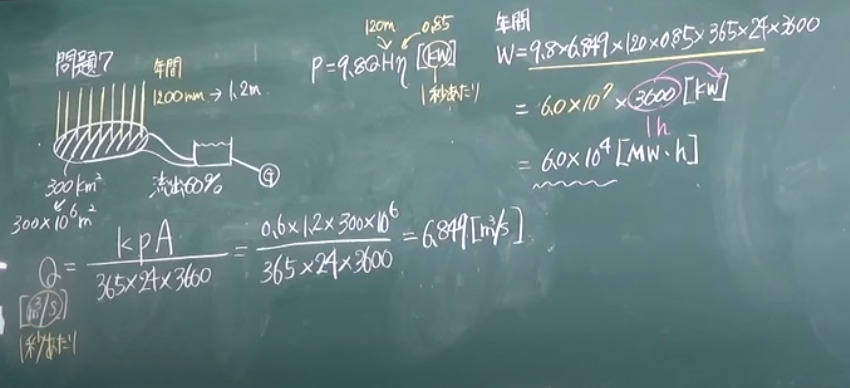

1.4 拡散モデル114 拡散モデルは、データからランダムなノイズを時間115 にわたって徐々に追加または除去し、出力を生成または再構築する原理で動作する。カスタム拡散モデルを学習させるために、我々はテレビ番組「サウスパーク」から約1200のキャラクタ118 と600の背景画像からなる包括的なデータセットを収集した。最初のモデルは、1 つのキャラクタを生成することに特化したもので、再び背景色を取得できるように設定されています123 。これにより、生成されたキャラクタをその後の処理とアニメーションのために抽出することが容易になり、124 新たに生成されたキャラクタをさまざまなシーンや設定に無制限に組み込むことができます。

6 さらに、キャラクター拡散モデルによって、画像から画像への拡散プロセス128 を利用して、自分のルックスに基づいたサウスパークのキャラク ター127 を作成し、129 同一の参加エージェントとして共同シミュレーションを行うことができる。このモデル134 は、生成されたキャラクターが交流する「舞台」を提供し、135 より広範な可能性のある場面やシナリオを創造することを可能にする。

しかし、これらのモデル138 によって生成される画像は、出力がピクセルベース139 であるため、その解像度に本質的な制限があることは重要ではない。この制限を回避するため、生成された 140 画像をAIアップスケーリング技術、特にR-ESRGAN-4x+-Anime6Bを用いてポスト処理し、画像品質を向上させる142。将来の2D インタラクティ ブワークでは、ベクトルベースの出力を生成できるカスタムトランスフォーマベースのモ デルをトレーニングする必要がある。

ベクトル・グラフィックは、ピクセル・ベースの画像とは異なり、拡大・縮小しても画質が劣化しないため、無限の解像度が得られる可能性がある。さらに、ベクターベースのシェイプはすでに個々のパーツに分離されている147 ため、生成されたアセットのプロシージャルな世界構築やアニメーショ ンシステムへの統合を複雑にしている、透明度やセグメンテーションに関するピクセルベースの後処理 の問題を解決することができる。