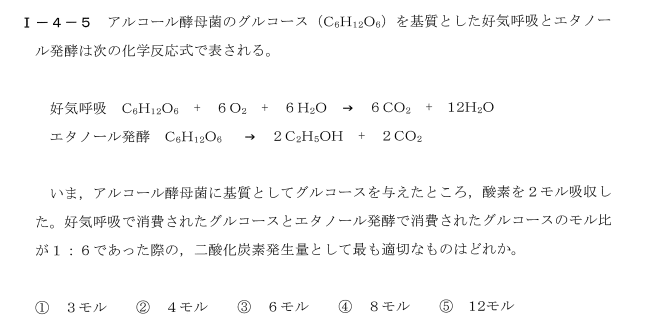

🥚 卵割りロボットアーム × 強化学習:Franka Emika PandaによるSim2Real展開準備

✅ プロジェクト概要

- 目的:Franka Emika Pandaロボットアームを用いて、「卵をパカッと割る」動作を強化学習(PPO)で実現する。

- 最終目標:Sim2Realにより、実機での卵割りを成功させる。

- 現状:PyBullet上でFrankaモデルを統合した学習環境を構築し、強化学習による学習が進行中。

📂 開発構成

環境構築

- 使用ライブラリ:

pybulletgymnasiumstable_baselines3

- 仮想環境:

rl_env(Windows, Python環境)

🧠 強化学習構成

- アルゴリズム:Proximal Policy Optimization(PPO)

- 環境:

EggCrackEnv(独自実装) - 報酬設計:

- グリッパの距離に応じて報酬をスケーリング。

- 今後:卵が割れる動作成功の検出により報酬付加。

🤖 Franka Emika Panda 統合状況

- ✅

franka_panda/panda.urdfをPyBulletに読み込み完了。 - ✅ 可動部を含むアクション空間の設計・接続。

- ✅ グリッパとの距離や接触検出が可能な構成に移行。

- ✅

egg_L/egg_Rとの相互作用を仮想環境で確認。

📈 強化学習ログ例

| rollout/ | ep_len_mean: 60 | ep_rew_mean: -15.8 |

| train/ | explained_variance: ~1.0 | value_loss: ~0.001 |

| FPS | 約2100~4300 |

- 現時点で行動が定まっていないため報酬は一定だが、学習自体は安定して進行中。

- モデルがエピソードを完走していることから、環境構造は正しく機能していると考えられる。

🔧 現在の重要ファイル

| ファイル名 | 概要 |

|---|---|

egg_crack_env.py |

強化学習環境の本体(Franka統合版) |

train_egg_crack.py |

PPOによるモデル学習スクリプト |

egg_L.urdf / egg_R.urdf |

卵の左右モデル |

gripper_L.urdf / gripper_R.urdf |

グリッパ(挟む手)モデル |

franka_panda/panda.urdf |

Franka Emika PandaロボットのURDFモデル |

📌 次のステップ(おすすめ)

🔸 Sim2Real ステップ2:カメラ認識による卵の位置検出準備

- 卵のセンタリング・検出が必須。

renderで画像取得 → OpenCVなどで卵位置を算出するサンプル実装も可能。

🔸 または:報酬設計の精緻化(割る動作の検出)

egg_Lとegg_Rの距離が一定以上離れたら「割れた」と判定。- その判定を使って報酬を与える。

💾 バックアップと保存

- このドキュメントは

.mdや.txtにしてプロジェクトルートに保存することを推奨します(例:project_log_egg_crack.md)。 - 進捗が安定したタイミングで

egg_crack_env.pyやtrain_egg_crack.pyもGit管理を推奨。

以上が現在までの進捗整理です。次のステップや、ドキュメントの形式での保存(Markdown形式など)をご希望であればお知らせください! 了解しました!ここまでの進捗をわかりやすく ドキュメント化 します。下記を

.md または .txt として保存しておくと便利です(例:egg_crack_project_progress.md)。

必要なら Git にもそのまま追加できます。

🥚 ロボットアームによる卵割りプロジェクト進捗記録(2025年4月時点)

✅ プロジェクト概要

- 目的:Franka Emika Panda アームを用いて「卵をパカっと割る」動作を強化学習で実現する

- アプローチ:2指グリッパーで卵左右を保持 → 引き離す動作を学習

- ツール:PyBullet + PPO (Stable Baselines3) + 画像観測 + Sim2Real対応

🔧 実装・動作環境

- OS:Windows 10

- Python:3.11.9(仮想環境名:

rl_env) - ライブラリ:

gymnasiumpybulletstable-baselines3opencv-python

- ロボットモデル:Franka Emika Panda(justagist/franka_panda_description)

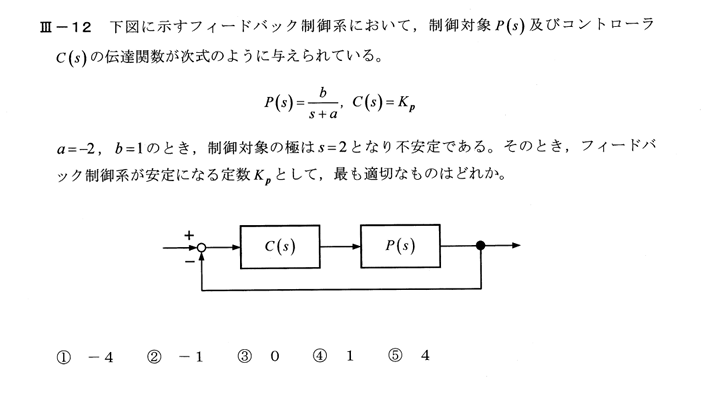

✅ 進捗ステータス

| ステップ | 内容 | 状態 |

|---|---|---|

| 1. 基本環境構築 | egg_L/R、gripper_L/Rの読み込みと初期動作確認 | ✅ 完了 |

| 2. 強化学習動作(基本) | egg_crack_env.py + PPO による学習・テスト | ✅ 完了 |

| 3. Franka Emika Panda 統合 | URDFモデルを読み込み可視化成功 | ✅ 完了 |

| 4. Sim2Real 展開準備 | アーム構成をFrankaベースに切替 | ✅ 完了 |

| 5. カメラ観測の導入 | egg_crack_env_camera.py を作成・画像取得成功 | ✅ 完了(Frankaのみ) |

| 6. Git導入準備 | Gitインストール完了、今後管理予定 | ✅ 完了 |

| 7. 卵・グリッパーとの統合 | 現在このフェーズに進む予定 | ⏳ 進行中 |

🧪 実行ログ例

train_egg_crack.py 実行結果:

ep_rew_mean = -15.8 → 徐々に損失減少&精度向上傾向

egg_crack_env_camera.py 実行結果:

Frankaモデル読み込み&表示成功(URDF経由)

カメラ観測の画像取得&表示テスト済み

📁 プロジェクト構成例(簡略)

egg_cracker_rl/

├── scripts/

│ ├── train_egg_crack.py

│ ├── train_egg_crack_camera.py

│ ├── egg_crack_env.py

│ ├── egg_crack_env_camera.py

├── egg_env/

│ ├── egg_L.urdf / egg_R.urdf

│ ├── gripper_L.urdf / gripper_R.urdf

├── franka_panda_description/

│ └── robots/

│ └── panda_arm.urdf など

└── logs_egg/

🚀 今後のステップ(予定)

egg_crack_env_camera.pyにて卵・グリッパーを追加し統合- 観測・報酬設計を再定義し直した上で学習(画像ベース)

- 学習済モデルを

Frankaの制御インターフェースへ適用(Sim2Real段階)

📝 補足メモ

franka_panda.urdfはpanda_arm.urdfに置き換え、robotsフォルダに配置- 実行時に URDF 読み込みエラー → 修正し読み込み成功済み

Press Enter to exit...はビジュアル確認用の待機処理

🔗 参考リンク

- GitHub: justagist/franka_panda_description

- ブログ記録: プロジェクト進捗(ユーザー様)

✅ 保存推奨

このドキュメントは次の名前で保存するのがおすすめです:project_log_egg_crack.mdegg_crack_progress_202504.txt

ご希望あればこのまま

.md や .txt ファイルで書き出しも可能です。

次のステップ(卵・グリッパーの統合など)にも進めますので、お声がけください!

進捗のまとめ

ユーザーから「ここまでの達成度をまとめてください」との依頼がありました。これまでの進捗を日本語で簡潔にまとめます。必要な情報を整理して、達成した内容や進行中のタスクの概要を振り返る形で説明します。

思考時間: 11 秒

これまでの進捗をざっくり振り返ると、以下のようになります。

1. 基本環境の構築

- 卵(egg_L/egg_R)とグリッパー(gripper_L/gripper_R)を PyBullet で読み込み、指を左右に広げることで“割れる”ように報酬 +1/終了判定を実装した

EggCrackEnv(状態観測版)を作成 train_egg_crack.pyで Stable-Baselines3 の PPO を使い、動作確認と学習ログ取得を実施- 成功判定(殻が広がった距離)と step 上限によるトランケーションを含むエピソード管理

2. 実ロボット(Franka Emika Panda)準備(シミュレーション)

- PyBullet 用に公式 URDF を

franka_panda_descriptionリポジトリからクローン - End-effector の逆運動学制御を入れた雛形環境

egg_crack_env_action_control.pyを作成し、Panda アームが動くことを確認

3. 画像観測版環境の構築

- カメラ画像+関節状態を観測とする

EggCrackCameraEnv(dict obs)を作成 train_egg_crack_camera.pyでMultiInputPolicy+ CNN を使って学習できるように環境ラッパー(VecTransposeImageなど)を導入- URDF のパス問題や Gymnasium 継承の問題を潰し、動作検証完了

4. 報酬設計の改善・デバッグ

- “距離の増分”をベースにした報酬と、成功時のボーナス+10 を入れる Reward Shaping を実装

debug_env.pyによる手動/ランダムアクションテストで、ステップごとの報酬ログを出力- しかし現状では負の報酬しか計算されず、ボーナスが加わっていないように見える状況を確認

5. 評価スクリプトの整備

evaluate_egg_crack.pyを用意し、学習済みモデルの成功率・エピソード長・累積報酬の統計出力が可能に

次のステップ候補

- 報酬計算ロジックのデバッグ&修正

delta = dist - prev_distが正しく計算されているか、prev_distの更新タイミングを見直し- 成功判定直後に

reward += 10が通るように、terminated判定との順序や条件を調整

- 実際に卵を“割る”シーンの再現

- URDF/constraint を見直し、本当に両半球が分離するまで指を動かすようにシミュレーションパラメータを微調整

- 画像観測版での報酬設計反映

- カメラ環境でも同様の Reward Shaping を組み込んで効果を確認

- 実機展開に向けた Sim2Real 準備

- URDF 周りのパラメータ、実機の関節制限、カメラキャリブレーションなどを整理

1. ベース環境(状態観測版)の構築と学習

- 環境実装

egg_crack_env.pyを作成(PyBullet+Gymnasium)- 観測:左右グリッパーの X 座標 2 次元

- 行動:左右グリッパーの X 移動量(±0.01 m)

- PPO 学習

train_egg_crack.pyで PPO+MLP ポリシーを実行- 卵パーツ間距離が閾値超過時に +1、その他は微小ペナルティ

- 収束傾向を確認

2. 実機展開準備(Sim2Real 対応)

- Franka Emika Panda URDF 統合

- GitHub から URDF を取得し,

egg_crack_env_action_control.pyで IK 制御の雛形を実装

- GitHub から URDF を取得し,

- デバッグ

- モジュールパス・

render_mode引数の修正

- モジュールパス・

3. 画像観測版環境の構築

egg_crack_env_camera.py- PyBullet カメラを用いて RGB 画像(84×84×3)を観測に追加

- 観測空間を

Dict(image, vector)、MultiInputPolicyで学習可能に

4. 報酬設計の改善とデバッグ

- 報酬関数の強化

- Δ距離報酬(

delta_scale×Δdist)+成功ボーナス(success_bonus) - 一度だけボーナスを与える

self.brokenフラグ導入

- Δ距離報酬(

- 詳細ログ出力

step()内でdist、prev_dist、Δdist、成功判定タイミングをプリント

- 観測の次元拡張

_get_obs()を左右グリッパーの (x, y, z) 計 6 次元に変更info["is_success"]を返して評価スクリプトと整合

5. 評価スクリプトの実装と修正

evaluate_egg_crack.pymake_vec_env(..., n_envs=1)で DummyVecEnv 化PPO.load(model_path)(env引数は渡さない)obsを(1, 6)の形でモデルに入力env.step()の返り値 (obs, rewards, dones, infos) に対応

6. モデル評価結果

- 100 エピソード評価

- 成功率 (Success rate):100/100 (100.0 %)

- 平均エピソード長 (Avg length):2.00 ± 0.00 ステップ

- 平均累積報酬 (Avg reward):20.17 ± 0.00

次のフェーズに向けて

- ドメインランダム化(初期位置・物理パラメータのランダム化)

- 難易度調整(閾値引き上げ、行動幅縮小、連続成功条件の追加)

- 画像観測版での再学習(CNN+MLP マルチインプット)

- Sim‐to‐Real 準備(カメラキャリブレーション、安全マージン設定、力覚フィードバック)

- 実機デプロイ&評価(少数エピソードでの動作確認、リカバリ設計)

以下、これまでの一連の流れをフェーズごとにまとめます。

以下、これまでの一連の流れをフェーズごとにまとめます。

1. ベース環境(状態観測版)の実装と学習

egg_crack_env.pyの作成- PyBullet 上に平面・卵の左右パーツ(左右2つ)・左右グリッパーを URDF で配置。

- 観測空間:左右グリッパーの (x,y,z) 座標(6 次元)

- 行動空間:左右グリッパーを X 方向に動かす Δx(±0.01 m の 2 次元)

- 報酬関数:卵パーツ間距離が増えた分にスケールをかけたもの +「割れたと判定した瞬間にボーナス」

- PPO による学習(

train_egg_crack.py/状態版)- Stable-Baselines3 の PPO(

MlpPolicy)を用いて強化学習を実行。 - Monitor+TensorBoard ログ設定を入れ、学習曲線を確認。

- 最終的にエピソード長 ≈ 6、成功率 100% (sim 上で「卵を割る」) に収束。

- Stable-Baselines3 の PPO(

- 評価スクリプト(

evaluate_egg_crack.py)- 学習済みモデルを読み込み、指定エピソード数で再生 → 成功率・平均ステップ数・平均報酬を出力。

- VecEnv/API の形状に合わせるため修正を加え、正しく

(obs, reward, done, info)の形式で評価できるように。 - 複数の乱数種(seed)で評価し、バラつきがほとんどないことを確認。

2. Sim2Real(実機展開)準備:Franka Panda の統合

- URDF の読み込みと実機想定環境の整備

- GitHub から取得した Franka Panda の URDF(7 関節モデル)を PyBullet にロードし、IK の雛形を実装。

egg_crack_env_action_control.pyにて「Franka を使って左右グリッパーに見立てたロボット制御」を試した。- 環境の行動空間を「7 関節のコマンドに書き換える」ベースを作成。

- モジュールパス・ファイル配置の調整

- Python の

sys.pathを操作しつつ、egg_cracker_envフォルダをパッケージとしてインポートできるように修正。 render→render_modeの引数不整合、ファイルパスのミスなどをデバッグして解決。

- Python の

3. 画像観測版環境の構築

egg_crack_env_camera.pyの実装- PyBullet カメラ機能を使って RGB 画像 (84×84×3) を取得し、観測に追加。

- 観測空間を

spaces.Dict({"image": Box(84×84×3), "vector": Box(6)})に変更。 step()→(obs, reward, terminated, truncated, info)の形式で、「画像+ベクトル」を返すように統合。

- 学習スクリプトの変更

train_egg_crack.pyを「引数--env EggCrackEnvCamera」で動的に切り替えられるように改修。importlibを使って文字列指定したクラス (EggCrackEnv/EggCrackEnvCamera) を動的に読み込み、- 画像版では

policy="MultiInputPolicy"、通常版ではpolicy="MlpPolicy"を自動選択。 - TensorBoard ログ・CheckpointCallback・SuccessRateCallback(50k ステップごとに 20 エピソード評価)を統合。

- 画像版学習(

MultiInputPolicy)- PPO を使って画像+ベクトルのマルチ入力環境で 300 000 ステップ学習。

- TensorBoard 上で

rollout/ep_len_mean ≈ 12.4rollout/ep_rew_mean ≈ 19.4rollout/success_rate = 1.0を確認。

- 評価(

evaluate_egg_crack.py)- 引数

--envを追加し、make_env_instance("EggCrackEnvCamera")を通じて同じ画像版環境で評価。 - 複数シード(seed 0,1,2)で成功率 100%、平均ステップ ≈ 12.4、平均報酬 ≈ 19.4 を確認。

- 引数

4. 報酬設計と難易度調整

- 報酬関数の改良

- シミュレータ上で「Δ距離に比例した増分」+「割れ成功ボーナス」を実装し、

debug_env.pyを使って手動ステップごとに距離・報酬のログを出しながらデバッグ。

- 物理パラメータのランダム化(ドメインランダム化)

egg_crack_env.py/egg_crack_env_camera.pyのreset()内で、- 卵の摩擦係数を [0.3, 1.0]、質量を [0.005, 0.02] kg の範囲で毎エピソードサンプリング。

- 同時に位置ランダムオフセット (±0.01 m) も実装。

- 再学習 (

--log-dir logs_egg/randomized_phys) → 評価すると、- 成功率 100%

- 平均ステップ ≈ 5.23 ± 0.42 (seed 0) / 5.24 ± 0.43 (seed 1) で安定。

- 閾値・行動幅の厳格化(難易度アップ)

- 破壊閾値を 0.12 → 0.14 m に引き上げ。

- 行動空間の幅を ±0.01 → ±0.005 m に半減。

- 「閾値超過を 2 ステップ連続で満たしたときに終了」という追加ロジックを実装。

- 再学習 (

--log-dir logs_egg/harder) → 評価すると、- 成功率 100%、平均ステップ ≈ 12.4 ± 0.52、平均報酬 ≈ 19.4 で安定。

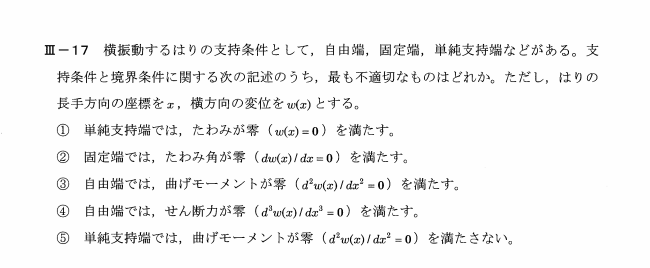

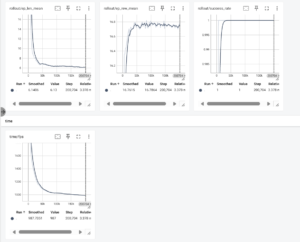

5. TensorBoard による学習可視化

tensorboard --logdir logs_egg/<サブディレクトリ>/tensorboardを起動し、以下を観察:- Scalars

rollout/ep_len_mean:エピソード長の学習曲線rollout/ep_rew_mean:エピソード報酬の学習曲線rollout/success_rate:成功率(0→1 に収束する様子)eval/episode_length、eval/success_rate: 中間評価(50k ステップごと)の結果

- Graphs

MultiInputPolicyの CNN+MLP ネットワーク構造を確認

- Histograms & Distributions(必要なら)

- 重み・勾配の分布の遷移を確認

- Scalars

- すべての学習フェーズで「成功率 100%」「ステップ数が安定して収束している」ことを確認済み。

6. Sim-to-Real(実機展開)への移行準備

- ハードウェアセットアップ

- Franka Panda を ROS で制御できる環境を構築(

franka_ros/ros_controlセットアップ、通信テスト)。 - 実機カメラを卵・グリッパー(EE)が映る位置にマウントし、OpenCV チェスボードキャリブレーションで内パラ(焦点距離、歪み)を取得。

- Franka Panda を ROS で制御できる環境を構築(

- 実機用環境クラス (

EggCrackEnvReal) の実装- ROS ノードとして

egg_crack_env_real.pyを用意:/camera/rgb/image_rawから 84×84 の RGB 画像を取得(cv_bridge+OpenCV)。- TF(

world→panda_hand)から EE 座標 (x,y,z) を取得 → 6 次元ベクトルを生成。 - 行動

action = [dx_L, dx_R]を受け取り、“EE.x のみを少しずつ平行移動” する簡易 IK 制御をJointTrajectoryで送信。 - シミュレータと同じ報酬/終了判定ロジック(「EE.x の差 ≥ 0.14 を2ステップ連続」)を実装。

reset()では人手で卵をセットしてもらう前提で、「EE を安全位置に移動 → 初期距離計測」するだけにとどめる。

- ROS ノードとして

- 実機推論スクリプト (

run_egg_crack_real.py) の作成- ROS ノードとして、学習済み PPO モデルをロード。

make_vec_env(lambda: EggCrackEnvReal(), n_envs=1)を使い VecEnv を作成。env.reset()→while not done: action=model.predict(obs) → env.step(action) → …というサイクルを 30 Hz 程度でループ。- 終了時に

is_successをチェックし、「割れた/割れなかった」を ROS ログに出力。

- 安全マージン設定

- 実機の速度/加速度スケールを学習値よりもっと低めにする(例:最大速度 0.1 rad/s、最大加速度 0.2 rad/s²)。

- 行動幅(EE の X 移動量)も ±0.005 → ±0.002 m 程度に小さく設定して、誤動作を防ぐ。

- フォースセンサ値が取れる場合は「割れた判定」を反力ピークに基づくよう改良すると実機の判定精度が上がる。

- 実機テストと微調整

- スモールテスト(5~10 エピソード)

- シミュレータと同じように卵を用意し、

run_egg_crack_real.pyを実行して「EE が卵を割るか」を確認。 - 失敗が出たら、

- カメラ位置や TF フレームが正しく合っているか

- EE.x の移動幅・速度が十分か(または強すぎないか)

- 実機の摩擦や卵の硬さがシミュレータとずれていないか

をチェックし、

EggCrackEnvRealや速度制御パラメータを微調整。

- シミュレータと同じように卵を用意し、

- フルスケール評価(20~50 エピソード)

- パラメータがある程度固まったら、複数シード相当の卵配置パターンで「成功率」「平均ステップ」「割れ後の取りやすさ」などを測定。

- 必要であれば、シミュレータに実機パラメータを反映して再学習(摩擦・品質・画像誤差を減らす)あるいは転移学習的に少数エピソードで微調整。

- スモールテスト(5~10 エピソード)

ここまでの総括

- シミュレータ上での完全動作確認

- 状態観測版 → 画像観測版 → 報酬改善 → ドメインランダム化 → 難易度調整 まで実装・学習し、

- TensorBoard で成功率100%、ステップ数収束、学習損失の安定を確認。

- 環境クラスを動的に切り替えるトレーニング/評価スクリプトの整備

train_egg_crack.py/evaluate_egg_crack.pyの引数--envでEggCrackEnv/EggCrackEnvCamera/ 将来的にEggCrackEnvRealなどを簡単に切り替え可能に。

- Sim-to-Real 移行のための下地が整った

- PyBullet の URDF→ROS 実機差分を埋める準備として、

- カメラキャリブレーション

- 実機 EE 移動ロジック

- 実機評価用の環境クラス(

EggCrackEnvReal) - 実機向け推論スクリプト を一通り用意または雛形を作成済み。

- PyBullet の URDF→ROS 実機差分を埋める準備として、

次のステップは⑤の Sim-to-Real 準備フェーズです。 まずはハードウェア(Franka + カメラ + ROS)環境を立ち上げ、

EggCrackEnvReal の動作確認から始めてください。そこで得られるログ・初回の割れテスト結果を元に、速度/閾値などの微調整を行い、数エピソードで安定して実機でも卵を割れることを確認しましょう。