さて、今回はCs50のテクニカルトークです。

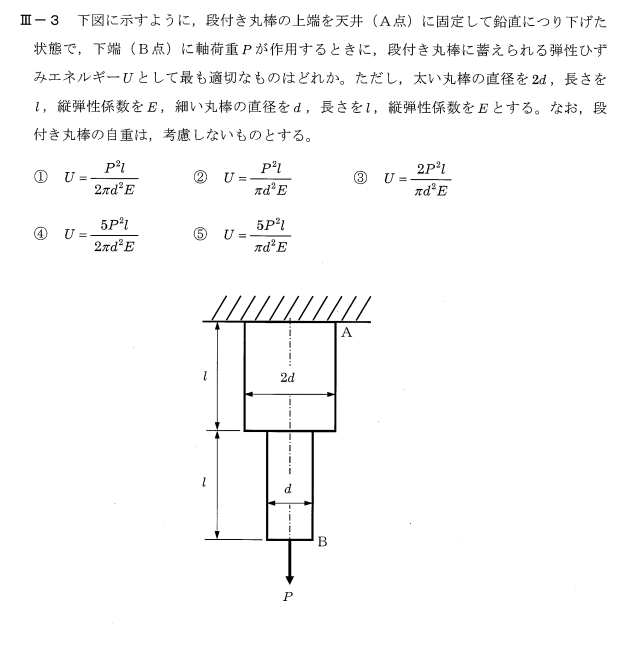

1週間ほど前にGoogleフォームを配布したのですが、午前10時52分に見たかもしれませんが、午前11時52分には100人の参加者がいました。

これは、このAIやオープンAi、GPTの世界に対する関心の高さを示すものだと思います。

GPTのようなもので、実際、みんなが話していることは知っているけど、まだ自分で試したことがないという人は、このURLから

このツールは、おそらくチャットGPTについて聞いたことがあると思いますが、そこで無料アカウントにサインアップして、みんなが話していることをいじり始めることができます。

そして、もしあなたがアプリにこだわるタイプであれば、そのようなタイプになるでしょう。

特にオープンAIには独自の低レベルのAPIがあり、それを使ってAIを自分のソフトウェアに統合することができます。

もちろん、コンピュータサイエンスの世界では、より抽象化されたサービスもあります。

このような技術の上に構築された抽象化されたサービスもあります。

今日は、McGill大学の友人、SteamshipのSillとTedが来てくれて、彼らがどのようにしてより簡単にしているのかについて話してくれることをとても嬉しく思っています。

このような技術を使って、アプリケーションの構築やデプロイ、共有がいかに簡単にできるようになったかについてお話しいただきます。

今日は、プリンプトンの友人であるジェニー・リーと卒業生が来てくれました。

しかし、これ以上のアドゥはなく、テッドとシルに引き継ぐことにします。

それではテッドさん、ありがとうございました。

皆さん、お集まりいただきありがとうございます!今日は本当にいいお話が聞けそうです。

GPTや他の言語モデルの脳の中で何が起こっているのか、どのように動いているのかについて研究する基礎となるものです。

そして、人々がどのようにアプリを作り、どのようなアプリが実世界で機能する傾向があるのか、現場で見てきた例をいくつか紹介したいと思います。

私たちはAIアプリのためのAWSを構築しているので、アプリを構築・展開している多くのメーカーと話をすることができます。

そのため、アプリの構築やデプロイを行っている多くのメーカーと話すことができ、その中で、実験的な側面と、どのようなアプリが世に送り出されているかを見ることができます。

その結果、どのようなアプリが世に送り出され、会社になったり、サイドプロジェクトになったりするのかを知ることができました。

昨日のハッカソンでは、Neiman、David Malin、cs50に感謝します。

2つのセッションがあり、多くの人が何かを作りました。

steamship.comのハッカソンに行けば、多くのガイドがあり、人々が作ったプロジェクトがたくさんあります。

テキストガイドもあるので、リモートでやりたい人はそちらを参考にしてください。

というわけで、今日は2つのことをお話しします。

1つは、GPTとは何か、それはどのように機能するのか、そして内部で何が起こっているのかを知ることです。

GPTの内部で何が起こっているのか、単に物事を予測する魔法の機械としてだけでなく、その感覚をつかむことです。

もしあなたが開発者で、cs50のバックグラウンドを持っているならば、物事を理解し、素晴らしいものを作り始めることができるはずです。

昨日、cs50の卒業生に会ったんだけど、彼らがやっていることはとても素晴らしかったよ。

ということで、今回はSillに引き継いで、GPTの理論的な部分について話していこうと思う。

私はマクギルのデジタル人文科学の大学院生で、文学とコンピュータサイエンスと言語学を研究しています。

言語学とコンピュータサイエンスを同時に学んでいます。ここ数年、言語モデルと文化で何が可能かを探る研究を発表しています。

特に言語モデルや文化について研究しています。

15分で説明するのは難しいのですが、GPTとは何なのかを説明することです。

しかし、それにアプローチする良い方法は、まず、人々がGPTと呼んでいるものをすべて考えてみることです。

GPTと呼ばれるもの、あるいは記述子と呼ばれるもの、大規模言語モデルと呼ばれるもの、コンピュータサイエンスのユニバーサル近似器と呼ばれるもの、などなど。

生成的なAIと言うこともできますし、ニューラルネットワークと言うこともできますし、人工知能と言うこともできます。

ある人にとっては人工知能であり、ある人にとっては文化のシミュレータであり、ある人にとってはテキストを予測するだけのものである。

また、文章作成アシスタントでもあります。Chachi PTを使ったことがある人は、エッセイのピットを差し込むと、フィードバックがもらえます。

コンテンツジェネレーターであり、コピーライティングに使われる jasper.ai pseudorite などのエージェントです。

エージェントです。Twitterで見たかもしれませんが、今本当にホットなのはAuto GPT baby AGIです。

このようなものにツールを与え、野生の状態で少し自由に走らせて、世界のコンピュータなどと対話させる。

we use them as chat Bots obviously and the actual architecture is a Transformer

so there's lots of ways to describe GPT and any other one of them is a really perfectly adequate way to begin the

conversation but for our purposes we can think of it as a large language model and more specifically a language model

and a language model is a model of language to if you allow

me the tautology but really what it does is it produces a probability distribution over some vocabulary so let

us imagine that we had the task of predicting the next word of the sequence I am so if I give a neural network

the words I am what of all words in English is the next most likely word to

follow that at its very core is what GPT is trained to answer

and how it does it is it has a vocabulary of 50 000 words and it knows roughly given the entire internet which

words are likely to follow other words of those 50 000 in some sequence up to

two thousand words up to four thousand up to eight thousand and now up to thirty two thousand three pt4 so you

give it a sequence here I am and over the vocabulary of 50 000 words it gives

you the likelihood of every single word that follows so here it's I am perhaps

the word happiest fairly frequent so we'll get that high probability if we look at all words all utterances of

English it might be I am sad maybe that's a little bit less probable I am school that really should be at the end

because I don't think anybody would ever say that I am Bjork that's a little bit it's not very probable but it's less

probable than happy sad but there's still some probability attached to it and when we say it's probable that's literally a percentage that's like

happy follows I am maybe like five percent of the time sad photos I am

maybe two percent of the time or whatever so for every word that we give GPT

it tries to predict what the next word is across 50 000 words and it gives every single one of those 50 000 words

uh number that reflects how probable it is and the Really magical thing that

happens is you can generate new text so if you give GPT I am and it predicts

happy as being the most probable word over fifty thousand you can then append

it to I am so now you say I am happy and you feed it into the model again you sample another word you feed it into the

model again and again and again and again and there's lots of different ways that I am happy I am sad can go and you

add a little bit of Randomness and all of a sudden you have a language model that can write essays that can talk and

a whole lot of things which is really unexpected and something that we didn't predict even five years ago so this is

all relevant and if we move on as we scale up the model and we give it

more compute in 2012 Alex that came out and we figured out we can give the model uh we can run the model on gpus so we

can speed up the process we can give the model lots of information downloaded from the internet and it learns more and

more and more and the frequent the probabilities that it gives you get better as it sees more examples of

English on the internet so we have to train the model to be really large really wide and we have to train it for

a really long time and as we do that the model gets more and more better and expressive and capable and it also gets

a little bit intelligent and for reasons we don't understand so but the also the issue is that

because it learns to replicate the internet it knows how to speak in a lot of different genres of text and a lot of

different registers if you begin the conversation like chat GPT can you explain the moon landing to a six year

old in a few sentences gpt3 this is an example drawn from the instruction PTA paper from openai

gpt3 would have just been like okay so you're giving me an example like explain

the moon landing to a six-year-old I'm going to give you a whole bunch of similar things because those seem very likely to come in a sequence it doesn't

necessarily understand that it's being asked a question has to respond with an answer gpt3 did not have that apparatus

that interface for responding the questions and the scientists at openai came up with

the solution and that's let's give it a whole bunch of examples of question and answers such that we first traded on the

internet and then we train it with a whole bunch of questions and answers such that it has the knowledge of the

internet but really knows that it has to be answering questions and that is when

chat GPT was born and that's when it gained 100 million users in one month I think it'd be tick tock's record at 20

million in one month it was a huge thing and for a lot of people they went oh

this thing is intelligent I can answer I can ask it questions it answers back we can work together to come to a solution

私たちは、明らかにチャットボットとして使っていますし、実際のアーキテクチャはTransformerです。

GPTを説明する方法はたくさんありますし、そのうちのどれを使っても、会話を始めるには本当に完璧に適切な方法です。

しかし、私たちの目的では、GPTを大規模な言語モデル、より具体的には言語モデルと考えることができます。

言語モデルとは、言語のモデルである。

トートロジーになりますが、実際に行うことは、ある語彙の確率分布を作成することです。

例えば、「I am」という単語の次の単語を予測するタスクがあるとします。

という単語を与えると、英語のすべての単語の中で次に来る可能性の高い単語は何か?

GPTはこの答えを出すために訓練されたのです。

GPTは5万語の語彙を持ち、インターネット全体からどの単語が次に来る可能性が高いかを大まかに知ることができます。

その5万語のうち、どの単語がどのような順序で他の単語に続く可能性が高いか、最大で

2,000語まで、4,000語まで、8,000語まで、そして今は302,3pt4までありますから。

5万語の語彙の中で、どの単語がどのような順序で他の単語に続く可能性が高いかを示してくれます。

その後に続く単語の可能性を示してくれます。

という単語はかなり頻繁に出てくるので、高い確率で出てくることになります。

英語ではI am sadかもしれません。I am schoolの可能性は少し低いかもしれません。

というのも、誰もI am Bjorkとは言わないと思うからです。それはちょっと、あまり確率は高くないですが、happy sadよりは確率が低いです。

でもまだ確率はあるんです。「確率が高い」というのは、文字通り割合のことで、例えば

幸せな写真の場合は5パーセント、悲しい写真の場合は2パーセントといった具合です。

というような確率で、GPTは次の単語を予測しようとします。

5万語の中から次の単語を予測し、その5万語の一つひとつに

そして、本当に不思議なのは、新しいテキストを生成できることです。

新しいテキストを生成することができるのです。

happyが5万語の中で最も確率の高い単語であると予測した場合、それをI amに追加することができます。

をI amに追加することができます。つまり、I am happyと言い、それをまたモデルに送り込み、別の単語をサンプリングして、それをモデルに送り込みます。

何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も、「私は幸せです」「私は悲しいです」と、様々な言い方ができます。

ランダムネスを少し加えると、突然、エッセイを書いたり、話したりできる言語モデルができあがります。

これは本当に予想外のことで、5年前にさえ予測できなかったことです。

モデルの規模を拡大し、計算量を増やすと、2012年、アレックスは次のようになります。

2012年、アレックスが発表され、モデルをgpusで動作させることで、プロセスを高速化できることがわかりました。

インターネットからダウンロードしたたくさんの情報をモデルに与えれば、どんどん学習していく。

インターネットからダウンロードしたたくさんの情報をモデルに与えれば、モデルはどんどん学習し、より多くの英語の例を見て、より頻繁に確率を出すようになります。

インターネット上の英語の例を見ていくうちに、その確率はどんどん上がっていく。

そうすることで、モデルはどんどん良くなり、表現力も能力も向上し、少しばかり知能も向上していきます。

その結果、モデルはより良くなり、表現力が豊かになり、能力も向上していきます。

インターネットを再現するように学習するため、様々なジャンルのテキストや様々な音域で会話する方法を知っています。

もし、あなたがチャットGPTのような会話を始めたら、6歳の子供に月面着陸を説明することができますか?

gpt3これはopenaiのインストラクションPTAの論文から引用した例です。

gpt3は、「なるほど、6歳の子供に月面着陸を説明するような例を教えてくれるのか」と思ったでしょう。

6歳児に月面着陸を説明するような例を出しているのだから、似たようなものをたくさん出すつもりだ。

質問され、それに答えなければならないことを必ずしも理解していない。

openaiの科学者たちは、その解決策を思いつきました。

その解決策として、まずインターネット上で取引されるような質問と答えの例をたくさん与えましょう。

そして、質問と答えの例をたくさん与えて訓練します。

インターネットに関する知識はあるが、本当は質問に答えなければならないことが分かっている。

チャットGPTが誕生し、1ヶ月で1億人のユーザーを獲得したのですが、Tick tockの記録は1ヶ月で2千万人でした。

1ヶ月で2,000万人のユーザーを獲得したのですが、これは非常に大きな出来事でした。

これはインテリジェントだ、答えられる、質問できる、答えが返ってくる、一緒に解決策を考えよう、と。

and that's because it's still predicting words it's still a language model but it

knows the predicts words in the framework of a question and answer so that's what a prompt is that's

what instruction tuning is that's a key word that's what rlhf is if you've ever seen that acronym

reinforcement alignment with human feedback and all those combined means that the models that are coming out

today the types of language predictors that are coming out today work to operate in a q a form

gpt4 exclusively only has the Align model available and this is a really

great solid foundation to build on because you can do all sorts of things you can ask Chachi PT can you do this

for me can you do that for me you might have seen that open AI has allowed plug-in access to chat CPT so it can

access Wolfram it can search the web it can search it can do instacart for you it can look up recipes

once the model knows that not only it has to predict language but that it has

to solve a problem and the problem here being give me a good answer to my question it's suddenly

able to interface with the world in a really solid way and from there on there's been all sorts of tools that

build on this q a form that chatgpt uses you have Auto GPT you have Lang chain

you have uh react there's a react paper where a lot of these come from and

turning the model into an agent with which to achieve any ambiguous goal is where the future

is going and this is all thanks to instruction tuning and with that I think I will hand it off to Ted who will be

giving a demo or something along those lines for how to use GPT as a agent

so all right so I'm a super replied guy I

kind of look at things and think okay how can I like to add this Lego add that Lego and clip them together and build

something with it and right now you know if you look back in computer science history when you look at the kinds of

things that were being done in 1970 right after Computing was invented the microprocessors were invented people

were doing research like how do I sort a list of numbers and that was meaningful work and importantly it was work that's

accessible to everybody because nobody knows what we can build with this new kind of oil this new kind of electricity

this new kind of unit of computation we've created and anything was game and anybody could participate in that game

to figure it out and I think one of the really exciting things about GPT right now is yes in and of itself it's amazing

but then what could we do with it if we call it over and over again if we build

it into our algorithms and start to build it into broader software so the world really is yours to figure out those fundamental questions about what

could you do if you could script computation itself over and over again in the way that computers can do not

just talk with it but build things atop it so we're a hosting company we host apps and these are just some of the

things that we see I'm going to show you demos of this with code and try to explain some of the thought process but

I wanted to give you a high level of overview of you've probably seen these on Twitter but kind of when it all sorts

out to the top these are some of the things that we're seeing built and deployed with language models today

companionship that's everything from I need a friend do I need a friend with a purpose I want a coach I want somebody

to tell me go to the gym and do these exercises I want somebody to help me study a foreign language question answering this is a big one this is

everything from your Newsroom having a slack bot that helps assist you does this article conform to the Style

Guidelines of our Newsroom all the way through to and you need help on my homework or hey I have some questions

that I want you to ask Wikipedia combine it with something else synthesize the answer and give it to me utility

functions I would describe this as as there's a large set of things for which human beings can do them if only or

computers could do them if only they had access to language computation language knowledge an example of this would be read every tweet on Twitter tell me the

ones I should read that way I only get to read the ones that actually make sense to me and I don't have to skim through the rest creativity image

generation text generation storytelling proposing other ways to do things and then these wild experiments and kind of

baby AGI as people are calling them in which the AI itself decides what to do and is self-directed so I'll show you

examples of many of these and what the code looks like and if I were you I would think about these as categories

within which to both think about what you might build and then also seek out

starter projects for how you might go about building them online

というのも、これはまだ言葉を予測するもので、言語モデルであることに変わりはないのですが、質問と回答の枠組みで言葉を予測することを知っているからです。

質問と答えの枠組みで単語を予測する。

インストラクション・チューニングがそうで、キーワードがそうで、RLHFがそうで、この頭文字を見たことがあるだろうか。

強化調整と人間のフィードバック、これらが組み合わさることで、今出てきているモデル、言語予測の種類は

今日出てきている言語予測モデルは、QA形式で動作するようにできています。

gpt4ではAlignモデルのみが利用可能で、これは本当に素晴らしい基礎となります。

様々なことができるため、これを土台にするのは本当に素晴らしいことです。

と聞くことができます。また、オープンAIがチャットCPTにプラグインでアクセスできるようにしたのを見たことがあるかもしれません。

Wolframにアクセスしたり、Webを検索したり、instacartを検索したり、レシピを調べたりすることができる。

モデルが、言語を予測するだけでなく、問題を解決しなければならないことを知れば、その問題は解決されます。

その問題とは、私の質問に対して適切な答えを出すことです。

それ以来、様々なツールがこのQAフォームをベースに開発されてきました。

chatgptが使っているAuto GPT、Lang chain、uh reactなど、様々なツールがあります。

リアクトの論文に、これらの多くが紹介されています。

モデルを曖昧な目標を達成するためのエージェントに変えることが、将来の方向性です。

これはすべて、インストラクション・チューニングのおかげです。

GPTのエージェントとしての使い方についてデモを行います。

さて、私は超返事魔です。

このレゴとこのレゴを組み合わせて、何かを作るにはどうしたらいいんだろう?

そして今、コンピュータサイエンスの歴史を振り返ってみると、1970年頃に行われていた

コンピューターが発明され、マイクロプロセッサーが発明された直後の1970年には

というような研究をしていた。

なぜなら、この新しい石油や新しい電気で何ができるかは誰も知らないからです。

この新しい石油、新しい電気、新しい計算機、何でもゲームにして、誰でもそのゲームに参加することができるのです。

GPTが今、本当にエキサイティングなことのひとつは、それ自体が素晴らしいということです。

しかし、もしこれを何度も何度も呼び出して、アルゴリズムに組み込んだら、どんなことができるでしょうか。

GPTをアルゴリズムに組み込んだり、より広範なソフトウェアに組み込んだりすることで、何ができるかという根本的な問いを解決することができます。

コンピュータができるように、計算そのものを何度も何度もスクリプト化できたら、何ができるだろう?

私たちはホスティング会社で、アプリをホスティングしていますし、これらはほんの一部です。

これからコードを使ったデモをお見せして、思考プロセスの一部を説明しようと思っていますが

Twitterで見たことがあると思いますが、このような概要があるのです。

言語モデルで構築され、展開されているものをいくつか紹介します。

交友関係......友達が欲しい、目的を持った友達が欲しい、コーチが欲しい、ジムに行けと言ってくれる人が欲しい、などなど。

ジムに行ってエクササイズをするように言ってくれる人が欲しい 外国語の勉強を手伝ってくれる人が欲しい 質問に対する答え これは大きなものです これは

ニュースルームにあるslackボットがあなたをサポートします この記事はスタイルガイドラインに準拠していますか?

この記事はニュースルームのスタイルガイドラインに準拠していますか、から、宿題を手伝ってほしい、とか、ちょっと質問があるんだけど、とか、そういうことです。

ウィキペディアに質問してほしいことがあるのですが、何かと組み合わせて答えを合成して私に教えてください。

実用関数とは、「もし、人間ができることなら、あるいは、もし、コンピュータができることなら、そのようなことをすることができる」というような、大きな集合のことである。

コンピュータが、言語計算や言語知識を利用しさえすれば、そのようなことができるのです。

そうすれば、実際に意味のあるものだけを読むことができ、残りをざっと読む必要はない。

創造性 画像生成 テキスト生成 ストーリーテリング 他の方法を提案する そして、このような野性的な実験や、人々が呼ぶところのベビーAGI

AI自身が何をすべきかを決定し、自己管理するような、世間で言うところのベビーAGIのようなものです。

もし私があなたなら、これらをカテゴリーとして考え、自分が何をすべきかを考えるでしょう。

私があなたなら、これらをカテゴリーとして考え、自分が何を作るかを考え、また、自分がどうすればよいかを考えるためのスタータープロジェクトを探すでしょう。

オンラインで構築するためのスターター・プロジェクトを探すことができます。

all right so I'm just going to dive straight into demos and code for some of these because I know that's what's interesting to see as fellow Builders

with a high level diagram for some of these as to how it works so approximately you can think of a

companionship bot as a friend that has a purpose to you and there are many ways

to build all of these things but one of the ways you can build this is simply to wrap GPT or a language model in an

endpoint that additionally injects into the prompt some particular perspective or some particular goal that you want to

use it really is that easy in a way but it's also very hard because you need to iterate and engineer The Prompt so that

it consistently performs the way you want it to perform so a good example of this is something somebody built into

hackathon yesterday and I just wanted to show you uh the project that they built it was a mandarin idiom coach and I'll

show you what the code looked like first I'll show you the Demo First I think I already pulled it up

here we go so the the buddy that this person wanted to create was a friend

that if you gave it a particular problem you were having it would pick a Chinese

idiom a four character Chung you that describe poetically like here's a a

particular way you could say this and it would tell it to her so that the person who built this was studying Chinese and

she wanted to learn more about it um so I might say something like I'm feeling

very sad and it would think a little bit and if everything's up and running it

will generate one of these four character phrases and it will respond to it uh with an example now I don't know

if this is correct or not so if somebody can call me out if this is actually incorrect you please please call me out

um and it will then finish up with something encouraging saying hey you can do it I know this is hard keep going so

let me show you how they built this and I uh pulled up the code

right here so this was the particular starter replit that folks were using in

the hackathon yesterday and we we pulled things up into basically you have a wrapper around GPT

and there's many things you could do but we're going to make it easy for you to do two things one of them is to inject

some personality into the prompt and I'll explain what that prompt is in a second and then the second is ADD

tools that might go out and do a particular thing search the web or generate an image or add something to a

database or fetch something from a database so having done that now you have something more than GPT now you

have GPT which we all know what it is and how we can interact with it but you've also added a particular lens

through which it's talking to you and potentially some tools so this particular Chinese tutor all it took to

build that was four lines so here's a question that I think is is frying the minds of everybody in the industry right

now so is this something that we'll all do casually and nobody really knows well we

just all say in the future to the llm hey for the next five minutes please talk like a teacher and maybe

but also definitely in the meantime and maybe in the future it makes sense to wrap up these personalized endpoints so

that when I'm talking to GPT I'm not just talking to GPT I have a whole Army of different buddies of different companions that I can talk to they're

kind of human and kind of talk to me interactively but because I pre-loaded them with hey by the way you particular

I want you to be a kind helpful Chinese teacher that responds to every situation by explaining the changu that fits it

speak in English and explain the Chung in its meaning then provide a note of encouragement about learning language

and so just adding something like that even if you're a non-programmer you can just type deploy

and it'll pop it up to the web it'll take it over to a telegram bot that then you can even interact with hey

I'm feeling too busy and interact with it over telegram over

the web and this is the kind of thing that's now Within Reach for everybody from a CS 101 grad sorry I'm using the

general purpose framing all the way through to Professionals in the industry that you can do just with a little bit

of manipulation on top of sort of this raw unit of conversation and intelligence

so companionship is is one of the first Common uh types of apps that we're seeing

so a second kind of app that we're seeing and this blew up if for those of you who are on

uh kind of Twitter followers this blew up I think the last few months is

question answering and I want to unpack a couple of different ways this can work because I know many of you have probably already tried to build some of these

kinds of apps there's a couple of different ways that it works the general framework is a user queries GPT and maybe it has

では、さっそくデモやコードを見ていきましょう。

というのも、ビルダーズ仲間として見ていて面白いのは、このようなものがどのように機能するかというハイレベルな図であるからです。

コンパニオンボットとは、自分にとって目的を持った友人と考えることができますし、多くの作り方があります。

このようなものを構築する方法はたくさんありますが、そのうちの1つは、GPTや言語モデルをエンドポイントでラップして、追加でインジェクションする方法です。

エンドポイントにGPTや言語モデルを組み込んで、プロンプトに特定の視点や特定の目標を追加注入します。

ある意味とても簡単ですが、プロンプトが一貫して思い通りに動作するように反復して設計する必要があるため、とても難しいことでもあります。

その良い例が、昨日のハッカソンで誰かが作ったものです。

昨日のハッカソンで、ある人が作ったプロジェクトがあります。それは中国語の熟語コーチです。

まず、どんなコードだったかをお見せしましょう。

この人が作りたかったバディは、ある問題を与えると、その問題を解決してくれる友達です。

ある問題を与えると、中国語の熟語を選んでくれます。

中国語の慣用句を選んでくれるのです。

これを作った人は中国語を勉強していました。

彼女は中国語についてもっと知りたいと思っています。

というようなことを言うと、少し考えて、すべてがうまくいけば、この4文字のフレーズを生成します。

この4文字のフレーズのうちの1つを生成し、それに対して例を挙げて反応します。

もしこれが正しいかどうか分からないので、もしこれが本当に正しくないなら、誰かが私を呼んでくれるなら、どうか私を呼んでください。

そして最後に、「あなたならできる」と励ましてくれるでしょう。

どうやってこれを作ったのかお見せしましょう。

これは、昨日のハッカソンでみんなが使っていたスターターレプリットです。

昨日のハッカソンでみんなが使っていた特定のスターターレプリットです。

をラップするもので、できることはたくさんありますが、ここでは2つのことを簡単にできるようにするつもりです。

プロンプトに個性を持たせることです。プロンプトが何であるかは後ほど説明します。

ツールは、ウェブ検索や画像生成、データベースへの追加、データベースからの取得など、ある特定のことを行うことができます。

このように、GPTを超えるものを手に入れたわけです。

GPTは、それが何であるか、どのように対話できるかを知っていますが、さらに特定のレンズを追加しています。

この中国語の家庭教師は、4行で作りました。

この中国の家庭教師は4行で作りました。

これは、私たちが何気なくやっていることで、誰もよく知らないことなのでしょうか。

将来的には、llmに「これから5分間は先生のように話してください」と言うだけでいい。

しかし、その間に、そして将来的には、このパーソナライズされたエンドポイントをラップアップすることは意味があると思います。

GPTと話すとき、GPTと話すだけでなく、さまざまな仲間と話すことができるのです。

人間的で、対話的に話しかけてくれるのですが、あらかじめ、「ところで、あなたはどう思いますか?

どんな状況でも、それに合ったチャングを説明してくれる、親切な中国語の先生になってほしい。

英語で話し、"Chung "の意味を説明し、言語学習について励ましの言葉をかける。

というようなことを追加するだけで、たとえあなたがノンプログラマーであっても、deployと入力するだけで

と入力すれば、ウェブに飛び出し、テレグラムボットに引き継がれ、Hey!

忙しくって......」と、テレグラムでやりとりすることもできますし、ウェブ上でやりとりすることもできます。

このようなことが、CS101の卒業生から、汎用フレームを使用していて申し訳ないのですが

このようなことは、CS101の卒業生から、汎用フレームを使用するプロフェッショナルまで、誰もが手の届くところにあるのです。

会話と知能という生の単位の上に、ほんの少しの操作を加えるだけで、できるようになります。

コンパニオンシップは、私たちが見ている最初の一般的なタイプのアプリの1つです。

このアプリは、私たちが見ている2番目の種類のアプリで、Twitterのフォロワーであれば、このアプリが爆発的に売れていることがわかります。

このアプリは、ここ数ヶ月で爆発的に普及したと思います。

このようなアプリを作ろうとしたことがある人は多いと思うので、このアプリがどのように機能するのか、いくつかの方法を紹介したいと思います。

一般的な枠組みは、ユーザーがGPTに問い合わせをし、そのGPTは汎用的な知識を持っているかもしれない。

general purpose knowledge maybe it doesn't have general purpose knowledge but what you want it to say back to you is something specific about an article

you wrote or something specific about your course syllabus or something specific about a particular set of

documents from the United Nations on a particular topic and so what you're really seeking is what we all hoped the

customer service spot would be like we've all interacted with these customer service Bots and we're kind of Smashing our heads on the keyboard as we do it

but pretty soon we're going to start to see very high fidelity Bots that interact

with us comfortably and this is approximately how to do it as an engineer so here's your game plan as an engineer step one

take the documents that you want it to respond to step two cut them up now if you're an

engineer this is going to Madden you you don't cut them up in a way that you would hope for example you could cut

them up into clean sentences or clean paragraphs or or semantically coherent sections and that would be really nice

honestly the way that most folks do it and this is a simplification that tends up tends to be just fine is you window

you have a sliding window that goes over the document and you just pull out fragments of text

having pulled out those fragments of text you turn them into something called an embedding Vector so an embedding

Vector is a list of numbers that approximate some point of meaning

so you've already all dealt with embedding vectors yourself in regular life and the reason you have and I know you have is because everybody's ordered

food from Yelp before so when you order food from Yelp you look at what genre of

restaurant is it is it in a pizza restaurant is it an Italian restaurant is it a Korean barbecue place you look

at how many stars does it have one two three four five you look at where is it so all of these you can think of as

points in space dimensions in space Korean barbecue restaurant four stars near my house it's a three

three number vector that's all this is so this is a thousand number vector or a ten thousand number

Vector different models produce different size vectors all it is is chunking pieces of text turning it into

a vector that approximates meaning and then you put it in something called a vector database and a vector database is just a database that stores numbers

but having that database now when I ask a question I can search the database and I can say

hey the question was what does cs50 teach what pieces of text in the database have

vectors similar to the question what does cs50 teach and there's all

sorts of tricks and Empires being made on refinements of this General approach but at the end you the developer

model it simply as thus and then when you have your query you embed it you find the document fragments

and then you put them into a prompt and now we're just back to the personality the the companionship Bots now it's just a

prompt and the prompt is you're an expert in answering questions please answer

user provided question using Source documents results from the database that's it

so after all of these Decades of engineering these customer service spots it turns out with a couple of lines of code you can build this so let me show

you I made one just before the class with the cs50 syllabus so we can

pull that up and I can say I I added the PDF right

here so I just I searched I don't know if I apologize I don't know if it's an accurate or recent syllabus I just

searched the web for cs50 syllabus PDF I put the URL in here uh it it loaded it into here this is just a like a hundred

line piece of code deployed that will now let me talk to it and I can say what will cs50 teach me

so under the hood now what's happening is exactly what that slide just showed you it takes that question what will cs50 teach me it turns it into a vector

that Vector approximates without exactly representing the meaning of that

question it looks into a vector database that steamship hosts of fragments from

that PDF and then it pulls out a document and then passes it to a prompt that says hey

you're an expert at answering questions someone has asked you what the cs50 teach please answer it using only the

source documents and Source materials I've provided now those Source materials materials are dynamically loaded into

汎用的な知識は持っていないかもしれませんが、あなたが返したいのは、あなたが書いた記事について何か具体的なことを言うことです。

について、あるいは授業のシラバスについて、あるいは特定のトピックに関する国連の特定の文書群について、です。

このように、あなたが本当に求めているのは、私たちがカスタマーサービス・スポットに期待しているようなものなのです。

私たちは皆、カスタマーサービスボットに接し、キーボードに頭をぶつけながら、こうなることを望んでいました。

しかし、もうすぐ、私たちと快適に対話できる非常に忠実度の高いボットが登場することになるでしょう。

これはエンジニアとしてのおおよそのやり方です。エンジニアとしてのゲームプランは次の通りです。

ボットに反応させたいドキュメントを手に入れる。

エンジニアであれば、このような切り分けは嫌なものでしょう。

きれいな文章、きれいな段落、意味的に一貫性のあるセクションに切り分けることができれば、それは本当に素晴らしいことです。

正直なところ、多くの人がやっている方法で、これは単純化したものですが、うまくいく傾向にあります。

ドキュメントを覆うスライド式のウィンドウを用意し、テキストの断片を抜き出す

テキストの断片を取り出したら、それを埋め込みベクターと呼ばれるものに変換します。

ベクターとは、ある意味での近似値である数値のリストです。

皆さんも普段の生活で埋め込みベクトルを扱ったことがあると思います。その理由は、誰もがYelpで料理を注文したことがあるからです。

Yelpで食べ物を注文するとき、どんなジャンルのレストランなのかを調べますよね。

ピザ屋なのか、イタリアンなのか、韓国焼肉なのか。

星がいくつあるか、1つ2つ3つ4つ5つ、どこにあるのか。

空間の中の点 空間の中の次元 韓国のバーベキューレストラン 私の家の近くの4つの星 それは3つの数のベクトルだ

3つの数字のベクトルであり、これがすべてである。

ベクトル 異なるモデルは異なるサイズのベクトルを生成します。

それをベクトルデータベースと呼ばれるものに格納します。ベクトルデータベースとは、単に数字を格納するデータベースです。

しかし、このデータベースがあれば、質問をしたときにデータベースを検索することができます。

cs50は何を教えているのだろう?

という質問に似たベクトルを持つテキストをデータベースから探し出すことができます。

この一般的なアプローチを改良することで、さまざまなトリックや帝国が作られましたが、最終的には開発者であるあなたが、このようにシンプルにモデル化します。

このように簡単にモデル化し、クエリができたらそれを埋め込んで、文書の断片を見つけ

そして、それをプロンプトに落とし込む。

プロンプトで、プロンプトは「あなたは質問に答える専門家です。

ユーザーが提供した質問に答えてください ソース文書のデータベースからの結果を使います 以上です

このように、何十年もかけて顧客サービス・スポットを設計してきた結果、数行のコードでこれを作ることができることがわかりました。

授業の直前にcs50のシラバスで作ったものをお見せしましょう。

PDFをここに追加しました。

正確かどうか、最近のシラバスかどうかわかりませんが、ウェブでcs50のシラバスを検索してみたんです。

cs50シラバスのPDFをウェブで検索して、そのURLをここに入れたら、ここに読み込まれた。

100行のコードが配置され、これと会話することで、cs50が何を教えてくれるかを知ることができます。

今、ボンネットの中で起こっていることは、先ほどのスライドで示したこととまったく同じで、「cs50は私に何を教えてくれるのか」という質問を、ベクトルに変えているのです。

そのベクトルは、その意味を正確に表現することなく近似している

その質問に対して、PDFから断片を集めたベクトルデータベースを調べます。

そして、そのPDFから文書を取り出し、それをプロンプトに渡す。

あなたは質問に答える専門家です 誰かがあなたにcs50の教えを尋ねたので、それだけを用いて答えてください。

私が提供したソース・ドキュメントとソース・マテリアルが動的にプロンプトにロードされます。

the prompt it's just basic prompt engineering and I want to keep harping back onto that what's amazing about

right now is Builders is that so many things just boil down to very creative

Tactical rearrangement of prompts and then using those over and over again in an

algorithm and putting that into software so the result and again it could be lying it could be making things up it could be hallucinating is cs50 will

teach students how to think algorithmically and solve problems efficiently focusing on topics such as abstraction and then it Returns the

source document from which it was found so this is another big bigory of which there are tons of potential applications because you can repeat for each context you know you can create arbitrarily many of these

once it's software because once it's software you can just repeat it over and over again so for your dorm for your

club for your slack for your telegram you can start to begin putting pieces of

information in and then responding to it and it doesn't have to be documents you can also load it straight into the

prompt I think I have it pulled up here and if I don't I'll just skip it

oh here we go one other way you can do question answering

because I I think it's healthy to always encourage the simplest possible approach to something

you don't need to engineer this giant system it's great to have a database it's great to use embeddings it's great

to use this big approach it's fancy it scales you can do a lot of things but you can also get away with a lot by just

pushing it all into a prompt and as a as an engineer I'm you know yes one of our teammates here always says like

Engineers should aspire to be lazy and I couldn't agree more you as an engineer should want to set yourself up so that

you can pursue the lazy path to something so here's how you might do the

equivalent of a question answering system with a prompt alone let's say you have 30 friends and each friend is good

at a particular thing or you can you know this isomorphic to many other problems you can simply just say hey I

know certain things here's the things I know a user is going to ask me something

how should we respond and then you load that into an agent that agent has access to GPT

you can shift deploy it and now you've got a bot that you can connect to telegram you can connect to slack and

that bot now it won't always give you the right answer because at a certain level we can't control the variance of

the model underneath but it will tend to answer with respect to this list and and the degree to which

it tends to is to a certain extent something that both industry is working on to just give everybody as a capacity

but also you doing prompt engineering to tighten up the the error bars on it

so I'll show you just a few more examples uh and then in about eight minutes I'll turn it over to questions

because I'm sure you've got a lot about how to build things so just to give you a sense of of where we are

foreign this is one I don't have a demo for you but if you were to come to me and you

were to say Ted I want a weekend Hustle Man what should I build holy moly there are a set of

applications that I would describe as utility functions I don't like that name because it doesn't sound exciting and

this is really exciting and it's it's low hanging fruits that automate tasks that require basic

language understanding so examples for this are generate a unit tests I don't

know how many of you have ever been writing tests and you're just like oh come on I can get through this I can get

through this if you're a person who likes writing tests you're a lucky individual looking up the documentation for a function rewriting a function making

something conform to your company guidelines doing a brand check all of these things are things that are

kind of relatively context-free operations or scoped context operations on a piece of

information that requires linguistic understanding and really you can think of them as

something that is now available to you as a software Builder as a weekend project Builder as a startup Builder

and you just have to build the interface around it and presented to other people in a context

in which it's meaningful them for them to consume and so the space of this is

extraordinary I mean it's the space of all human endeavor now with this new tool I think is the way to the way to

think about it people often joke about how in when you're building a company when you're building a project you don't want to start with a hammer because you

want you want to start with a problem instead and it's generally true but my God like we've just got a really cool

new hammer and to a certain extent I would encourage you to at least casually on the weekends run around and hit stuff

with it and see what can happen from a Builders from a tinkerers from experimentalists point of view

プロンプトは、基本的なプロンプトエンジニアリングであり、そのことを繰り返し強調したい。

今、ビルダーがすごいのは、多くのことが、非常に創造的なプロンプトの再配置に集約されることだ。

プロンプトを戦術的にアレンジし、それをアルゴリズムで何度も何度も使い、それをソフトウェアに落とし込む。

その結果、嘘かもしれないし、作り物かもしれないし、幻覚かもしれない。

アルゴリズム的な考え方と、抽象化などのトピックに焦点を当てた効率的な問題解決の方法を学生に教える。

これはもう1つの大きな特徴で、たくさんの潜在的な用途があります。なぜなら、それぞれの文脈で繰り返すことができるからです。

一旦ソフトウェアになれば、何度でも繰り返すことができるからです。

クラブに、スラックに、電報に......情報の断片を入れ始めることができます。

文書である必要はなく、そのままプロンプトに読み込ませることもできます。

プロンプトに直接読み込むこともできます。私はここでそれを引き出したと思いますが、もしそうでなかったら、私はそれをスキップします。

そうだ、もう一つ、質問に答える方法を紹介しよう。

というのも、何かに対して可能な限りシンプルなアプローチを常に奨励することは健全なことだと思うからです。

巨大なシステムを構築する必要はない データベースがあるのは素晴らしい 埋め込みデータを使うのも良いし

この大きなアプローチを使うのもいいし、スケールするのもいいし、いろいろなことができる。

エンジニアとして、私は、そう、ここのチームメイトの一人がいつもこう言うんだ。

エンジニアは怠け者になることを目指すべきだ。

エンジニアとして、怠惰な道を追求できるような環境を整えたいものです。

例えば、30人の友達がいて、それぞれの友達が特定のことを得意としているとします。

あるいは、これは他の多くの問題と同型であり、単純に「私はあることを知っている」と言うこともできます。

あることを知っていて、ユーザが私に何かを尋ねようとしていることを知っている。

それをエージェントにロードし、エージェントはGPTにアクセスできる。

ボットはテレグラムに接続でき、スラックに接続できます。

ボットは常に正しい答えをくれるわけではありません。あるレベルでは、モデルの分散をコントロールできないからです。

しかし、このリストに沿った答えを出す傾向があります。

このような傾向は、ある程度、両業界が取り組んでいることで、すべての人に能力として提供することができます。

また、エラーバーをより細かくするために、エンジニアリングを行うこともあります。

では、もう少しだけ例をお見せしましょう。それから8分後に質問を受け付けます。

というのも、皆さんはモノの作り方についていろいろとご存知だと思うので、私たちが今どのような状況にあるのかを知っていただくために。

デモはありませんが、もしあなたが私のところに来て、「テッド、週末を過ごしたい」と言ったとします。

テッド、週末のハッスルマンが欲しいんだけど......」と言われたら、何を作ればいいのでしょう。

ユーティリティ・ファンクションと呼ばれるアプリケーションの一群があります。

これは本当にエキサイティングで、基本的な言語理解が必要なタスクを自動化する、低空飛行の果実のようなものです。

例えば、ユニットテストの生成です。

テストを書いたことがある人がどれだけいるかわからないが、「ああ、もういいや、これならなんとかなる。

もしあなたがテストを書くのが好きな人なら、あなたは幸運な人だと思います。

会社のガイドラインに準拠させる ブランドチェックをする これらのことはすべて

言語的な理解を必要とする情報に対して、比較的文脈にとらわれない操作、あるいは文脈にとらわれない操作をすることです。

言語的な理解を必要とする情報に対して、比較的文脈にとらわれない操作や、範囲にとらわれない文脈の操作を行うものです。

ソフトウェアビルダーとして、週末プロジェクトビルダーとして、スタートアップビルダーとして、利用できるようになったものです。

として利用できるものであり、その周りにインターフェイスを構築し、他の人々にコンテクストで提示するだけでよい。

この空間は並外れたものです。

この新しいツールを使って、私はこう考えています。

よく冗談で、会社を作るとき、プロジェクトを立ち上げるとき、ハンマーから始めるのは嫌だと言う人がいます。

という冗談をよく聞きますが、それは一般的に正しいのです。

しかし、せっかくかっこいいハンマーを手に入れたのだから、週末に気軽に使ってみてください。

それで何が起こるか見てみることです。実験家として、いじり屋として。

and then the final creativity this is another huge mega app now I'm primarily live in the text world

and so I'm going to talk about text-based things I think so far this is mostly uh been growing in the imagery

world because we're such visual creatures and the the images you can generate are just staggering with AI

certainly brings up a lot of questions too around IP and artistic style

but the template for this if you're a builder that we're seeing in in the wild is approximately the following and the

thing I want to point out is domain knowledge here this is really the purpose of this slide is to to touch on

the importance of the domain knowledge so many people

approximately find the creative process as follows come up with a big idea

over generate possibilities edit down what you over generated repeat

right like anybody who's been a writer knows when you write you write way too much and then you have to delete lots of

it and then you revise and you write way too much and you have to delete lots of it this particular task is fantastic for

AI one of the reasons it's fantastic for AI is because it allows the AI to be wrong you know you've pre-agreed you're

going to delete lots of it and so if you pre-agree hey I'm just going to build you know generate five possibilities of

the story I might tell five possibilities of the advertising headline five possibilities of what I might write what I might write my thesis

on you pre-agreed it's okay if it's a little long because you are going to be the editor that steps in and and here's

the thing that you really should bring to the table is don't think about this as a technical activity think about this

as your opportunity not to put GPT in charge instead for you to grasp the steering

wheel tighter I think at least in python or the language you're using to program because you have the domain knowledge to

wield GPT in the generation of those so let me show you an example of what I mean by that so

this is a a cool app that someone created for the writing Atlas project so

writing Atlas is a set of short stories and you can think of it as Goodreads for

short stories so you can go in here you can browse different stories and this was something somebody created where you

can type in a story a description that you like and this is going to take about a minute to generate so I'm going to talk while it's generating and

while while it's working what it's doing and I'll show you the code in a second is

it's searching through the collection of stories for similar stories and here's what the domain knowledge part comes in then it uses GPT to look at what it was

that you wanted and use knowledge of how an editor how a Bookseller thinks to

generate a set of suggestions specifically through the lens of that perspective with the goal of writing

that beautiful handwritten note that we sometimes see in a local bookstore tacked on underneath a book and so it

doesn't just say hey you might like this here's a general purpose reason why you might like this but specifically here's

why you might like this with respect to what you gave it it's either stalling out or it's taking a long time oh there

we go so here's its suggestions and in particular these things these are

things that only a human could know at least for now uh two humans specifically the human who said they wanted to read a

story that's the text that came in and then the human who added domain knowledge to script a sequence of

interactions with the language model so that you could provide very targeted reasoning over something that was

informed by that domain knowledge so for these utility apps bring your bring your domain knowledge

let me actually show you how this looks in code because I think it's it's useful to see how simple and accessible this is

this is really a set of prompts so why might they like a particular location well here's

the prompt that did that this is an open source project and and it has a bunch of examples and then it says well here's the one that

we're interested in here's the audience here's a couple of examples of why might people like a

particular thing in terms of audience it's just another prompt

same for topic same for explanation and if you go down here and look at how it was done

suggesting the story is what is this line 174 to line 203 it really is and

again like over and over again I want to impress upon you this really is Within Reach it's really just

what 20 odd lines of Step One search in the database for similar stories step

two given that I have similar stories pull out the data step three with my

domain knowledge in Python now run these prompts step four prepare that into an

output so the thing we're scripting itself is some approximation of human cognition

if you're willing to go there metaphorically we're not you know we're not sure I'm not going to weigh in on on where we are in the is open AI uh

そして、最終的なクリエイティビティですが、これも巨大なメガアプリで、私は主にテキストの世界に住んでいます。

なので、テキストベースのものについて話そうと思います。

というのも、私たちは視覚的な生き物で、AIによって生成できる画像は驚異的だからです。

しかし、IPや芸術的なスタイルに関する多くの疑問があります。

しかし、もしあなたがビルダーなら、私たちが実際に見ているこのテンプレートは、およそ次のようなものです。

このスライドの目的は、ドメイン知識の重要性に触れることです。

ドメイン知識の重要性に触れることです。

創造的なプロセスは次のようなものです。 大きなアイデアを思いつく

可能性を過剰に生成する 過剰に生成したものを編集する 繰り返す

作家であれば誰でも知っていることですが、文章を書くと、書きすぎてしまい、その多くを削除しなければなりません。

そして修正し、また書きすぎて削除する......このような作業は、AIにとって素晴らしいことです。

AIにとって素晴らしい理由の1つは、AIが間違いを犯すことができるからです。

を削除してしまうからです もしあなたが事前に同意したのなら、私はただ5つの可能性のある物語を

広告の見出しの5つの可能性です。

というのも、あなたが編集者になるのですから。

技術的な活動として考えるのではなく、GPTを搭載しない機会として考えてほしいのです。

GPTを担当させるのではなく、あなたがハンドルを握る機会だと考えてください。

少なくともパイソンやプログラミングに使っている言語では、GPTの生成に必要なドメイン知識を持っているのですから。

というのも、あなたはGPTを生成するためのドメイン知識を持っているからです。

これは、writing Atlasプロジェクトのために誰かが作ったクールなアプリです。

ライティング・アトラスは短編小説のセットで、短編小説のGoodreadsのようなものだと考えてください。

短編小説のGoodreadsのようなもので、ここに入ってさまざまな物語を閲覧できます。

これは誰かが作ったもので、ストーリーに自分の好きな説明を入力することができます。

生成している間、何をしているかというと、すぐにコードをお見せします。

ストーリーのコレクションから似たようなストーリーを探します。ここでドメイン知識の部分が登場します。

編集者がどのように考えるか、書店員がどのように考えるか、といった知識を使って

編集者の考え方や書店員の考え方の知識を使って、その観点で具体的な提案のセットを生成します。

地元の書店で本の下に貼ってある美しい手書きのメモを書くことを目的としています。

単に「これが好きかもしれませんよ」という一般的な理由だけでなく、「なぜこれが好きなのか」という具体的な理由が書かれています。

この本が気に入るかもしれない一般的な理由ではなく、具体的に、あなたが与えたものに関して、これが気に入るかもしれない理由です。

特に、これらのことは、人間しか知り得ないことです。

人間だけが知りうることです。少なくとも今のところは......2人の人間、特に「物語を読みたい」と言った人間は

を読みたいと言った人間、そして言語モデルとの一連のやり取りをスクリプト化するためにドメイン知識を追加した人間です。

言語モデルとの一連のやりとりをスクリプト化することで、ドメイン知識から得た情報をもとに、非常に的を絞った推論を提供することができます。

このようなユーティリティアプリでは、ドメイン知識を持ってくることで、そのドメイン知識に基づいた推論を行うことができます。

実際にコードでどのように見えるかをお見せしましょう。これがいかにシンプルでアクセスしやすいかを見ていただくのに役立つと思います。

これは本当にプロンプトのセットで、なぜ特定の場所が好きなのか。

これはオープンソースのプロジェクトで、たくさんの例があり、その中から私たちが興味を持ったものを選びます。

私たちが興味をもっているのは、観客のことです。

視聴者という点では、別のプロンプトに過ぎません。

トピックも説明も同じで、ここに降りて、どのように行われたかを見てみると

この174行目から203行目までがどのようなストーリーなのかを提案し

何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も何度も本当に「Within Reach」であることを印象付けたい。

20数行のステップ1 類似のストーリーをデータベースで検索する ステップ2 類似のストーリーがあるとして

ステップ2 似たような話があるとして、データを取り出すステップ3 Pythonのドメイン知識で

Pythonのドメイン知識で、プロンプトを実行するステップ4。

つまり、スクリプトを書くこと自体が、人間の認知に近いということです。

もし、あなたがそこに行くことを望んでいるならば、比喩的に言えば、私たちは、オープンAIが生命体であるかという議論において、私たちがどのような位置にいるのかについて、意見を述べるつもりはありません。

a life form argument all right uh one kind of really far out

there thing and then I'll uh tie it up for questions because I know there's probably a lot and I also want to make

sure you get a great pizza in your bellies and that is a baby AGI Auto GPT

is what you might have heard them called on Twitter I think of them as multi-step planning bots so everything I showed you

so far was approximately One-Shot interactions with GPT so this is the user says they want

something and then either python mediates interactions with GPT or GPT itself does

some things with the inflection of a personality that you've added from some prompt engineering really useful

pretty easy to control if you want to go to production if you want to build a weekend project if you want to build a company that's a great way to do it

right now this is wild and if you haven't seen this stuff on Twitter I would definitely

recommend going to search for it this is what happens the simple way to put it is if you put GPT in a for Loop if you let

GPT talk to itself and then tell itself what to do so

it it's an emergent Behavior like and like all emergent behaviors it starts with a few simple steps the Conway's

Game of Life many elements of reality turn out to be math equations that fit on a t-shirt but then

when you play them forward in time they generate DNA they generate human life so

this is approximately step one take a human objective step two your first task is to write

yourself a list of steps and here's the critical part repeat now do the list of steps now you have to

embody your agent with the ability to do things so it's really only limited to do what you give it the tools to do and

what it has the skills to do so obviously this is still very much a set of experiments that are running right

now and and but it's something that we'll see unfold over the coming years and this is the scenario in which python

stops becoming so important because we've given it the ability to actually self-direct what it's doing and then it

finally gives you a result and I want to give you an example still of just again impressing upon you how much of this is

prompt engineering which is wild how little code this is let me show you what

baby AGI looks like so here is a baby AGI that you can

connect to Telegram and this is an agent that has two tools

so I haven't explained to you what an agent is I haven't explained to you what tools are I'll give you a quick one sentence description an agent is just a

word to mean GPT plus some bigger body in which it's living maybe that body has

a personality maybe it has tools maybe it has python mediating its experience with other things tools are simply ways

in which the agent can choose to do things like imagine if GPT could say order a pizza and instead of you seeing

the text order a pizza that caused the pizza to be ordered that's a tool so these are two tools it has one tool

is generated to-do list one tool is do a search on the web

and then down here it has a a prompt saying hey your goal

is to build a task list and then do that task list and then this is just placed into a harness that does it over and

over again so after the next task kind of uncue the results of that task and and keep it going

and so in doing that you get this kickstarted Loop where essentially you kick start it and then the agent is

talking it to itself talking to itself so this unless I'm wrong I don't think this has yet reached production in terms

of what we're seeing in the field of how people are deploying software but if you want to dive into sort of the wildest

part of experimentation this is definitely one of the places you can start and it's really within reach all

you have to do is download one of the starter projects for it and you can kind of see right in the prompting here's how

you kick start that process of of iteration

all right so I know that was super high level uh I hope it was useful uh it's I think from the field from the bottoms up

what we're seeing and what people are building kind of the this high level categories of apps that people are

making all of these apps are apps that are within reach to everybody which is really really exciting uh and there's I

suggest Twitter is a great place to hang out and uh build things uh there's a lot of AI builders on Twitter uh publishing

and if I think we've got a couple minutes before Pizza is arriving maybe 10 minutes keep on going oh so if

there's any questions why don't we uh kick it to that because I'm sure there's some uh uh questions that you all have I

guess I ended a little early yes

生命体に関する議論ですが......1つ、本当に遠い話です。

そして、質問もたくさんあると思いますので、この辺で終わりにします。

このピザは、AGIオートGPTと呼ばれています。

という呼び方をTwitterで聞いたことがあるかもしれませんが、これはマルチステップ・プランニング・ボットだと考えています。

GPTを使ったワンショットのインタラクションを紹介しました。

を言うと、pythonがGPTとのインタラクションを仲介するか、GPT自身が何かしてくれる。

プロンプトエンジニアリングから追加されたパーソナリティの抑揚を利用すると、本当に便利です。

生産に移行したい場合、週末にプロジェクトを立ち上げたい場合、会社を立ち上げたい場合など、コントロールが非常に簡単です。

もしあなたがTwitterでこのようなものを見たことがなければ、ぜひ検索してみることをお勧めします。

このようなことが起こるのです。簡単に言うと、GPTをforループに入れると、GPTが自分自身と会話して

GPTが自分自身と対話し、自分自身に何をすべきかを指示する。

これは、他の創発的行動と同じように、いくつかの簡単なステップから始まるのです。

現実の多くの要素は、Tシャツに収まるような数学の方程式であることが判明しています。

それを時間軸で再生すると、DNAが生成され、人間の生命が生成されます。

これはおよそステップ1、人間という目的を持つステップ2、最初の仕事は、自分自身にステップのリストを書くことです。

ステップのリストを自分で書くことです。ここが重要なのですが、ステップのリストを繰り返し実行することです。

エージェントができることを具現化することです。

これはまだ、現在進行中の実験にすぎません。

しかし、これは今後何年もかけて展開されるもので、Pythonがそれほど重要でなくなるシナリオなのです。

というのも、実際にやっていることを自己管理する能力を与えてしまって、最終的に結果を出してくれるからです。

この例では、いかにこれがプロンプトエンジニアリングであるかということを再度印象づけたいと思います。

プロンプトエンジニアリングであることを改めて印象付けます。これはワイルドなことで、コードはほとんどありません。

これはTelegramに接続できるAGIの赤ちゃんです。

Telegramに接続できるエージェントで、2つのツールを持っています。

エージェントとは何か、ツールとは何か、まだ説明していませんでしたが、簡単に一文で説明しますと、エージェントは、GPTに加え、より大きなものを意味する言葉です。

GPTと、そのGPTが生きている大きな体を意味する言葉です。その体には人格があるかもしれません。

人格があり、ツールがあり、パイソンがあり、他のものとの経験を媒介する ツールとは、単に方法です。

例えば、GPTがピザを注文して、あなたがピザを見るのではなく、ピザを注文するというテキストを見ることができたらどうでしょう。

ピザを注文するというテキストを見る代わりに、ピザを注文させたとしたら、それはツールです。

一つはToDoリストの作成、もう一つはウェブでの検索です。

そしてこの下には、「あなたの目標はタスクリストを作ることです」というプロンプトが表示されています。

タスクリストを作成し、そのタスクリストを実行する。

次のタスクの後に、そのタスクの結果をアンキューして、それを継続させるのです。

そうすることで、キックスタート・ループが実現します。

だから、間違っていなければ、これはまだ生産に至っていないと思うんです。

しかし、もしあなたが、最もワイルドな実験に飛び込みたいのであれば、これは間違いなく一つの方法です。

実験に挑戦したいのであれば、これは間違いなく始められる場所の1つで、本当に手の届くところにあるんだ。

スターター・プロジェクトをダウンロードすれば、プロンプトが表示され、そのプロセスを開始することができます。

反復のプロセスを開始することができます。

というわけで、超ハイレベルな話になってしまいましたが、お役に立てれば幸いです......。

私たちが見ているもの、そして人々が作っているもの、このようなアプリのハイレベルなカテゴリーを紹介します。

これらのアプリはすべて、誰にでも手の届くところにあるアプリであり、とてもエキサイティングです。

Twitterは、みんなで集まって何かを作るのに最適な場所だと思いますし、TwitterにはたくさんのAIビルダーがいますし、出版もされています。

ピザの到着まであと2~3分、10分くらいでしょうか、続けてください。

何か質問があれば、それにしましょうか。

少し早く終わってしまったようです。

40 of the time yeah do you have any like actual recommendations uh

of so the question was how approximately

how do you manage the hallucination problem like if you give it a physics lecture and you ask it a question on the

one hand it appears to be answering you correctly on the other hand it appears to be wrong to an expert's eye 40 of the

time 70 of the time 10 of the time it's a huge problem and then what are some ways as developers practically you can

use to mitigate that I'll give an answer still you may have some specific things too so one high level answer is the same

thing that makes these things capable of synthesizing information is part of the reason why it hallucinates for you so it's hard to have your cake and eat it

too to a certain extent so this is part of the game in fact humans do it too like people talk about you know uh just

folks who kind of are too aggressive in their assumptions about knowledge I can't remember the name for that phenomenon where you'll just say stuff

right so we do it too um some things you can do are kind of a

range of activities depending on how much money you're willing to spend how much technical expertise you have that can range from fine-tuning a model to

practically so I'm in the applied world so I'm very much in a world of duct tape and sort of how developers get stuff

done so some of the answers I'll give you are sort of very duct tape answers giving it examples tends to work for

acute things if it's behaving in wild ways the more examples you give it uh the better that's not going to solve the

domain of all of physics so for the domain of all the physics I'm gonna I'm gonna bail and give it to you because I

think you are far more equipped than me to speak on that sure so the model doesn't have a ground truth it doesn't

know anything any sense of meaning that is derived from the training process is purely out of differentiation one word

is not another word words are not used in the same context it understands everything only through examples given

through language it's like someone who learned English or how to speak but they grew up in a featureless gray room

they've never seen the outside world they have nothing to rest on that tells them something is true and something is

not true so from the models perspective everything that it says it's true it's trying its best to give you the best

answer possible and if it lying a little bit or conflating two different topics

is the best way to achieve that then it will decide to do so it's a part of the architecture we can't get around it there are a number of

cheap tricks that surprisingly get it to confabulate or hallucinate less one of them includes recently there was a paper

that's a little funny if you get it to prepend to its answer my best guess is that will actually

improve or reduce hallucinations by about 80 percent so clearly it has some

sense that some things are true and other things are not but we're not quite sure what that is to add on to what Ted was saying a few cheap things you can do

include letting it Google or Bing as in Bing chat what they're doing it cites

this information asking it to make sure its own response is good if you've ever had shotgpt generate a program

there's some kind of problem and you ask Chachi PT I think there's a mistake often it'll locate the mistake itself

why it didn't produce the right answer at the very beginning we're still not sure but we're moving in the direction

of reducing hallucinations now with respect to physics you're going to have to give it an external database to rest

on because internally for really really domain specific knowledge it's not going to

be as deterministic as one would like these things work in continuous spaces

these things they don't know what is wrong what is true and as a result we have to give it

to us so everything that Ted demo today is really striving at reducing hallucinations

actually really and giving it more abilities I hope that answers your question and one of the ways too that I

mean I'm a simple guy like I I tend to think that all of the world tends to be just a few things repeated over and over

again and we have human systems for this you know in a team like companies work are a team playing Sport and we're not

right all the time even when we aspire to be and so we have uh systems that we've developed as humans to deal with

things that may be wrong so you know human number one proposes an answer human number two checks their work human

number three provides the follow final sign off this is really common anybody who's worked in a company has seen this

in practice the interesting thing about the state of software right now we tend to be in this mode in which we're just talking to GPT as one entity

40 of the time ええ、実際に推奨するようなことはありますか?

ということで、その質問は、およそ

幻覚の問題をどのように管理するかということです。例えば、物理学の講義をしているときに、ある質問をすると、一方では正しく答えているように見え、他方では専門家の目には間違っているように見えます。

一方では正しく答えているように見えるが、他方では、専門家の目には間違っているように見える。

70%の確率で、10%の確率で間違っているとしたら、それは大きな問題です。

それを軽減するために、開発者が実践的に使える方法は何でしょうか。

このようなものが情報を合成できるのは、幻覚を見せるのと同じことなので、ケーキを食べながら食べるのは難しいのです。

これはゲームの一部であり、実際、人間も同じようなことをします。

知識に対する思い込みが激しすぎる人たち、その現象の名前は思い出せないのですが、ただ物を言うだけになってしまいます。

そう、私たちもそうなのです。

どれだけお金をかけられるか、どれだけ技術的な専門知識があるかによって、モデルの微調整から実用的なものまで、さまざまな活動をすることができます。

私は応用の世界に身を置いているので、ダクトテープのような、開発者が何かを成し遂げる方法のようなものにとても関心があるのです。

そのため、私がお伝えする回答の中には、例を挙げて説明するような、まさにガムテープのような回答もありますが、急性期のものには効果があるような気がします。

物理学の全領域を解決するわけではありませんが、そのような場合、例をあげればあげるほどいいのです。

物理学の全領域を解決することはできないので、物理学の全領域を解決するために、私は会釈してあなたに譲ります。

なぜなら、あなたは私よりもずっと、そのことについて話す能力があると思うからです。

学習プロセスから得られる意味は、純粋に差別化されたものである。

言葉は同じ文脈で使われることはない 言語を通して与えられた例によってのみすべてを理解する

英語とか話し方を学んだ人が、特徴のない灰色の部屋で育ったようなものです。

外の世界を見たことがなく、何かが真実で何かが真実でないという根拠がない。

だから、モデルの視点からは、それが言うことはすべて真実であり、最高の答えを出そうと最善を尽くしているのです。

もし、少し嘘をついたり、2つの異なるトピックを混同したりするのであれば

をするのがベストだと判断すれば、そうすることになる。

そのうちの1つに、最近、ある論文がありました。

ちょっと面白い論文があって、その答えの前置きをさせると、私の予想では、実際に

幻覚を約80%改善または減少させるというものです。

あるものは真実で、あるものはそうではないという感覚を持っていることは確かですが、それが何であるかはよくわかりません。

GoogleやBingのチャットのように、この情報を引用させることです。

この情報を引用して、自分自身の応答が良いものであることを確認するように頼むのです。

何か問題があって、チャチPTに「間違いがあると思うんだけど」と聞くと、その間違いを自ら見つけてくれることがよくあります。

なぜ最初から正しい答えが出なかったのか、それはまだわからないが、幻覚を減らす方向に進んでいる。

物理学に関しては、外部データベースを与える必要がありそうです。

というのも、本当に領域固有の知識は、内部では思うように決定論的にならないからです。

というのも、本当に本当に領域固有の知識は、内部では思うように決定論的にならないからです。

何が間違っているのか、何が真実なのかがわからないのです。

だから、今日のテッドのデモはすべて、幻覚を減らすために努力しているんだ。

そのため、今日のテッドのデモはすべて、幻覚を減らし、より多くの能力を与えることに努めています。

私は単純な人間なので、世の中のことはすべて、いくつかのことが何度も何度も繰り返されていると考える傾向があります。

そのために人間のシステムがあるのですが、会社のようなチームでは、スポーツをするチームです。

だから、人間には、間違っていることに対処するために開発されたシステムがある。

そのため、私たちは人間として開発した、間違っている可能性のあることに対処するためのシステムを備えています。つまり、人間1号が答えを提案し、人間2号がその仕事をチェックし、人間3号が最終的なサインを出すのです。

3番が最終的なサインをする これは、会社で働いたことのある人なら誰でも見たことがあるはずです。

実際のところ、今のソフトウェアの状態で興味深いのは、私たちはGPTを1つのエンティティとして話すというモードになりがちだということです。

but once we start thinking in terms of teams so to

speak where each team member is its own agent with its own set of objectives and skills I suspect we're going to start

seeing a programming model in which the way to solve this might not necessarily be make a sing single brain smarter but

instead B draw upon the collective intelligence of multiple software agents each playing a role and and I think that

that would certainly follow the human pattern of how we deal with this to give an analogy space shuttles things that go

into space spacecraft they have to be good if they're not good people die they

have like no no margin for error at all and as a result we over engineer in those systems most spacecraft have three

computers and they all have to agree in unison on a particular step to go forward if one does not agree then they

recalculate they recalculate they recalculate until they arrive at something the good thing is that hallucinations are generally not a

systemic problem in terms of its knowledge it's often a one-off the model something tripped it up and it just

produced a hallucination in that one instance so if there's three models working in unison just instead of saying

that will generally speaking improve your success yeah yeah so hey Siri

what's the mechanism by which that influences this

sure I'm going to give you what might be an unsatisfying answer which is it tends to work but I think we know why it tends

to work and again it's because these language models approximate how we talk to each other so if I were to say to you

hey help me out I need you to mock interview me that's a direct statement I can make that kicks you into a certain

mode of interaction or if I say to you help me out I'm trying to apologize to my wife she's really mad at me can you

role play with me that kicks you into another mode of interaction and and so it's really just a shorthand that people

have found to kick the agent in to kick the llm into a certain mode of interaction that tends to work in the

way that I as a software developer am hoping it would work and to really quickly add on to that

um being in the digital Humanities that I am I like to think of it as a narrative a narrative will have a few

different characters talking to each other their roles are clearly defined two people are not the same

this interaction with GPT it assumes the personality it can simulate personalities it itself is not cautious

in any way but it can certainly predict what a conscious being would react like in a particular situation so

we when we're going u r x it is drawing up that personality and talking as

though it is that person because it is it is like completing a transcript or completing a story in which that

character is present and interacting and is active so yeah

I think we've got about five minutes until the the pizza outside anyways

yes sir all right yes so but um it's been fun playing with this

and I understand the sort of word by word generation and the sort of vibe the feeling of it you know the narrative

some of my friends and I have tried giving problems like things from the LSAT for

example and it doesn't work like and I'm just wondering why that would be so it like it will generate answers that sound

very plausible rhetorically like given this condition yeah why why but it'll

often like even contradict itself in its answers but it's almost never correct so

I was wondering what why that would be like it just can't reason it can't like think and

like can you would we get to a place where you can I mean not you know what I mean

I don't even think like it's conscious I mean like have thoughts you want to talk about react

so gpt4 one when gpt4 released back in March I think it was it was passing LSAT

it was yeah yes yes it just passed as I understand it

because that's one of the weird things is that yeah if you pay for job GPT they give you

access to the better model and one of the interesting things with it is prompting it's so finicky if you it's

very sensitive to the way that you prompt there were earlier on when gpt3 came out some people were going look I

can pass literacy tests or no it can't pass literacy tests and then people who are pro or anti-gpt would be like I

modified The Prompt a little bit suddenly it can or suddenly it can't these things are not cautious their

ability to reason is like an aliens they're not us they don't think like people they're not human but they

certainly are capable of passing some things empirically which demonstrates some sort of rationale or logic within

the model but we're still slowly figuring out like a prompt Whisperer what exactly the right approach is

have you seen instances where it's directly create some sort of business value in

AI appsしかし、チーム単位で考えるようになれば

しかし、チームという観点から考えるようになると、チームメンバーはそれぞれ独自の目的とスキルを持ったエージェントであると考えるようになります。

この問題を解決する方法は、必ずしも一人の脳を賢くすることではなく、複数のソフトウェア・エージェントの集合知を利用することです。

その代わりに、複数のソフトウェア・エージェントの集合知を利用し、それぞれが役割を果たすようになる。

これは、私たちがこの問題にどう対処するかという人間のパターンに確実に従うことになると思います。

宇宙船は、良いものでなければなりませんが、良いものでなければ人が死んでしまいます。

その結果、宇宙船のシステムには過剰なエンジニアリングが施されています。

コンピュータが3台あり、特定のステップに進むには、全員が一致しなければなりません。1台が一致しない場合は、再計算を行います。

再計算し、再計算し、再計算し、何かにたどり着くまで再計算し続ける。

よくあることだが、幻覚は知識という点ではシステム的な問題ではなく、1回限りのものであることが多い。

だから、もし3つのモデルが一体となって働いていれば、「これが成功の秘訣だ」というのではなく

と言うよりも、3つのモデルが一体となって働いている方が、一般的に言えば成功率が上がります。

それがどのようなメカニズムで影響するのか?

という不満足な答えが返ってきそうですが、なぜそうなるのかはわかっているつもりです。

この言語モデルは、私たちがお互いにどのように話すかを近似的に示しているからです。

手伝ってくれ、模擬面接をしてくれ」と言えば、直接的な表現で、あなたをある種の相互作用に向かわせることができるのです。

また、「妻に謝りたいんだけど、怒っているんだ」と言えば、「一緒にロールプレイしてくれない?

と言えば、別のインタラクションモードに移行することができます。

というのは、エージェントがILMをある種のインタラクションモードに誘導し、それがソフトウェア開発者である私と同じように機能する傾向があることを発見したのです。

ソフトウェア開発者である私が期待するような方法で、さらに手っ取り早く付け加えれば

デジタル・ヒューマニティーに身を置く私は、これを物語として考えたいのですが、物語にはいくつかの登場人物がいて、それぞれの役割があります。

その役割分担は明確で、二人の人間が同じであることはありません。

GPTは人格を想定しており、人格をシミュレートすることができる。

しかし、ある特定の状況において、意識のある人がどのような反応を示すかを予測することはできる。

私たちがU R Xをするとき、その人格を描き出し、その人であるかのように話している。

というのも、その人物の人格を描き出し、その人物であるかのように話すことは、その人物が存在し、交流し、活動する、1つの記録や物語を完成させるようなものだからです。

その人物が存在し、交流し、活動しているのですから。

外のピザまであと5分くらいかな?

そうですね......そうですね......それで......これで遊ぶのは楽しいです。

一語一語生成し、その雰囲気や感覚を理解し、物語を理解する。

友人と一緒にLSATのような問題を出題してみたことがあるんですが、例えば

なぜそうなるのか不思議です。

この条件なら、なぜそうなるのか」というような、非常にもっともらしいレトリックに基づいた答えを出すのですが、その答えが

その答えが矛盾していることもよくありますが、正しいことはほとんどありませんから。

なぜだろうと考えていました。

というようなことができるようになるのでしょうか?つまり、私の言っている意味がわかるでしょうか?

意識しているわけでもない、つまり思考があるわけでもない。

gpt4が発売された3月当時は、LSATに合格していたと思う。

そうだ、そうだ、そうだ......合格したんだ。

というのも、不思議なことに、ジョブGPTにお金を払うと、より良いモデルにアクセスできるようになるのです。

というのも、ジョブGPTにお金を払うと、より良いモデルにアクセスできるようになるのですが、このモデルで面白いのは、プロンプトがとても繊細なことです。

プロンプトの出し方に非常に敏感なんです。

識字テストに合格できるとか、いや、識字テストには合格できないとか、gptに賛成する人も反対する人も、「私はこう思う」と。

プロンプトを少し変えただけで、突然できるようになったり、突然できなくなったりするのですが、このようなものは用心深くありません。

理性的な能力は宇宙人のようなもので、私たちとは違うし、人間のように考えることもない。

しかし、ある種の合理性や論理性を実証的に示すことができるのです。

しかし、私たちはまだ、プロンプト・ウィスパラーのように、どのようなアプローチが正しいのかをゆっくりと見極めているところです。

AIアプリで直接的に何らかのビジネス価値を生み出した事例を見たことがありますか?

AIアプリ

yeah I mean we host companies on top of us who that's their their primary product uh the the value that it adds is

like any company I mean it's you know what is the Y combinator mono make something people want I mean I wouldn't

think of this as GPT inherently provides value for you as a builder like that's their product that's Open the Eyes

product you pay chat GPT for prioritized access where your product might be is

how you take that and combine it with your data somebody else's data some domain knowledge some interface uh that

then helps apply it to something it is two things are both true there are a lot of experiments going on right now uh

both for fun and people trying to figure out where the economic value is but but folks are also spinning up companies

that are 100 supported by applying this to data

I I I think that it is likely that today we call this GPT and today we call these

llms and tomorrow it will just slide into The Ether I mean imagine what the imagine what the progression is going to

be today there's one of these that the people are primarily playing with there's many of them that exist but one people are primarily bidding atop

tomorrow we can expect that there will be many of them and the day after that we can expect they're going to be on our

phones and they're not even going to be connected to the internet and for that reason I think that like today we don't

call our software microprocessor tools or microprocessor apps like the processor just exists I think that one

useful model five years out ten years out is to even if it's only metaphorically true and not literally

true I I think it's useful to think of this as a second processor we had this before with uh with with floating point

co-processors and Graphics co-processors already as recently as the 90s where it's useful to think of the trajectory

of this as just another thing that computers to do can do and it will be incorporated into absolutely everything

hence the term Foundation model which also crops up I'm sorry so

pizza is ready one more question maybe one more and then uh then we'll break for some food

in the glasses right there

I was just being told we need to get two more so yeah

it's hard to get it to do that reliably it's incredibly useful to get it to do reliably so some tricks you can use are

you can give it examples you can just ask it directly uh those are two common tricks

um and and look at the prompts that others have used to work I mean there's a lot of art to finding the right prompt

right now a lot of it is Magic incantation another thing you can do is post process it so that you can do some

checking and you can have a happy path in which it's a one shot and you get your answer and then a sad path in which

maybe you fall back on other prompts so then you're going for the diversity of approach where it's it's fast by default

そうですね......つまり、私たちは自分たちの上に、それが主要な製品である企業を受け入れているのです。

どの会社でもそうですが、Yコンビネーターの「モノ作り」は、人が欲しがるものを作ることです。

これは、GPTが本来、ビルダーとしての価値を提供するもので、それが彼らの製品であり、Open the Eyesであると考えることができます。

製品であり、GPTにチャットを支払うことで優先的にアクセスできる。

それを自分のデータと組み合わせたり、他の人のデータと組み合わせたりするわけです。

そして、それを何かに応用する手助けになる。

経済的な価値がどこにあるのかを探ろうとする人々や、遊びのための実験が行われていますが、その一方で、これを応用して100%支援する企業を立ち上げる人々もいます。

データへの応用で100%支持されている

今日、私たちはこれをGPTと呼び、今日、私たちはこれをllmsと呼びます。

明日にはイーサに移行してしまうかもしれません。つまり、どのような展開になるのか想像してみてください。

今日、人々が主に遊んでいるのはこのうちの1つで、多くのものが存在しますが、人々が主に入札しているのは1つです。

明日になれば、このようなものがたくさん出てきて、明後日には私たちの携帯電話にも搭載されるようになると予想されます。

そのため、私たちは今日と同じように、ソフトウェアをマイクロプロセッサーとは呼ばないと思います。

そのため、今日、私たちはソフトウェアをマイクロプロセッサー・ツールやマイクロプロセッサー・アプリケーションと呼ばず、プロセッサーがただ存在するようなものだと考えています。

5年後、10年後に役立つモデルとして、たとえそれが比喩的なものであって、文字通りのものではないとしても、「5年後、10年後に役立つモデル」というのがあると思います。

たとえ比喩的な意味しかなく、文字通りの意味ではないとしても......これを第2のプロセッサと考えるのは有効だと思います。

90年代にはすでに浮動小数点演算プロセッサやグラフィック・プロセッサがありました。

コンピュータができることのひとつに過ぎず、あらゆるものに組み込まれることになる。

だから、ファウンデーション・モデルという言葉も出てくるのです。

ピザができたので、もう一問、もう一問、それから......食事をしましょう。

グラスの中に

あと2つ必要だと言われたところです。

それを確実に実行させるのは難しいですが、確実に実行させるのはとても便利です。だから、いくつかのトリックを使うことができます。

例をあげてみたり、直接聞いてみたり......この2つが一般的なトリックです。

そして、他の人が使ってうまくいったプロンプトを見てみる。

今、その多くは魔法の呪文である。

一発で答えが出るハッピーパスもあれば、他のプロンプトに戻るかもしれないサッドパスもある。

他のプロンプトに戻るかもしれないので、デフォルトでは高速だが最終的には収束するという多様なアプローチを目指すことになる。

it's slow but ultimately converging upon higher likelihood of success if it fails and then something that I'm sure we'll

see people do later on is is fine tune instruction tuning style models which are more likely to respond with the

computer partsable uh output so I guess one one last question so sure um so the

one you talked a couple of things one is as you talk about domain expertise

you're encoding a bunch of domain expertise in terms of the prompts that you're doing what is that where do those

prompts and is there

that's a great question so the question was and I apologize I just realized we haven't been repeating all the questions for the the YouTube listeners so I'm

sorry for the folks on YouTube if you weren't able to hear some of the questions uh the question was what are the Privacy implications of some of

these prompts if one of the messages is so much depends upon your prompt and the fine-tuning of this prompt what does

that mean with respect to my IP maybe the prompt is my business I can't offer you the exact answer but I

can paint for you what approximately the landscape looks like so in all of software and so too with AI what we see

is they're the SAS companies where you're using somebody else's API and you're trusting that their terms in

service will be upheld there's the set of companies in which they provide a model for hosting on one of the big

cloud providers and this is a version of the same thing but I think with slightly different mechanics this tends to be

thought of as the Enterprise version of software and by and large the industry has moved over the past 20 years from

running my own servers to trusting that Microsoft or Amazon or Google can run servers for me and they say it's my

private server even though I know they're running it and I'm okay with that and you're gonna you've already started to see that Amazon with hugging

face Microsoft with open AI Google 2 with their own version of Bard are going to do these where you'll have the SAS

version and then you'll also have the private VPC version and then there's a third version that I think we haven't yet seen practically emerge but this

would be the the maximalist I want to make sure my IP is maximally safe version of events in which you are

running your own machines you are running your own models and then the question is is the open source and or

privately available version of the model as good as the publicly hosted one and does that matter to me and the answer is

right now realistically it probably matters a lot in the fullness of time you can think of any one particular task

you need to achieve as requiring some fixed point of intelligence to achieve and so over time what we'll see is the

privately obtainable versions of these models will cross that threshold and with respect to that one task yeah sure

use the open source version run it on your own machine but we'll also see the SAS intelligence get smarter it'll

probably stay ahead and then you're question is which one do I care more about do I want like the better aggregate intelligence or is my task

somewhat fixed point and I can just use the open source available one for which I know it'll perform well enough because

it's crossed the threshold so to answer your question specifically yes uh you

might be glad to know if childcpt recently updated their privacy policy to not use prompts for the training process

but up until now everything went back into the bin to be trained on again

and that's just a fact so I think Pizza is now Pizza time let's go get some

pizza I hope this was useful uh we'll be around two days questions

その結果、失敗しても成功する可能性が高くなり、さらに、後々、このようなことをする人が出てくると思います。

そして、この後、人々が行うであろうことは、コンピュータの部品化でより反応しやすいインストラクションチューニングスタイルのモデルを微調整することです。

コンピュータの部品に対応できるような......出力......最後に1つだけ質問させてください。

1つは、ドメインの専門知識について話すとき、あなたは多くのことを符号化しています。

あなたは、プロンプトという点で、多くの領域の専門知識をエンコードしているのです。

プロンプトはどこにあるのでしょうか?

質問ですが、YouTubeのリスナーへの質問をすべて繰り返していないことに気がつきました。

YouTubeのリスナーには申し訳ないのですが、質問の一部が聞き取れなかったとしたら、それは質問です。

このプロンプトのメッセージのひとつに、「プロンプトとプロンプトの微調整に大きく依存する」というものがありますが、これは私のIPに関してどのような意味があるのでしょうか。

プロンプトは私のビジネスなのかもしれない。

ソフトウエア全般、そしてAIでもそうですが、おおよそどのような風景になるかは描けます。

SASのような企業は、他人のAPIを利用し、そのAPIの利用規約が守られることを信頼しているのです。

また、大手クラウドプロバイダーでホスティングするモデルを提供している企業もあります。

これは同じことのバージョンですが、仕組みが少し違っていて、これはソフトウェアのエンタープライズ版と考えられる傾向があります。

この業界は、過去20年間で、自前のサーバーを運用することから信頼することへと移行してきました。

この20年間で、業界は、自分でサーバーを運営することから、マイクロソフトやアマゾン、グーグルが私のためにサーバーを運営してくれることを信頼し、彼らがそれを私のプライベートサーバーだと言ってくれるようになりました。

その結果、Amazonがハグしているように見えるでしょう。

マイクロソフトはオープンなAIを提供し、グーグルはバードの独自バージョンを提供しています。

SASバージョンとプライベートVPCバージョンがあり、さらに3つ目のバージョンがあります。

これは、自分のIPを最大限に安全な状態に保ちたい、という最大公約数的なもので、自分のマシンを走らせたり、自分のマシンを走らせたりするイベントです。

自分のマシンで自分のモデルを動かし、その上で、オープンソースや個人で利用可能なバージョンのモデルはどうなのかということです。

オープンソースや個人で利用可能なバージョンのモデルは、一般にホストされているものと同じくらい優れているのか、そしてそれは私にとって重要なことなのか、ということです。

今現在は現実的に、おそらく大いに問題でしょう。

を達成するためには、ある一定の知能が必要であると考えることができます。

民間で入手可能なバージョンのモデルは、その閾値を超えるでしょう。

しかし、SASのインテリジェンスがより賢くなり、おそらく先んじることになるでしょう。

しかし、SASのインテリジェンスはより賢くなり、おそらくこの先も進化し続けるでしょう。そして、どちらがより重要なのか、より優れたインテリジェンスを求めるのか、それとも私のタスクはある程度固定されていて

オープンソースのものを使えばいいのですが、その場合、十分なパフォーマンスが得られることが分かっています。

質問には具体的に答えますと、そうですね......。

最近、Childcptがプライバシーポリシーを更新し、トレーニングプロセスでプロンプトを使用しないようにしたことを知ったら喜ぶかもしれません。

しかし、これまでは、すべてビンに戻して、またトレーニングしていました。

というわけで、ピザの時間です。

ピザを食べに行こう これが役に立てばいいが......また2日後に質問することにしよう。