LLMは決して革命的なものではなく、ネット上の達人たちが信じ込ませているようなゲームチェンジでもありません。

私の無料ニュースレター「AI Made Simple」を通じて、3万2000人以上の人々と一緒に、AIにおける最も重要なアイデアに関する洞察を直接受信することができます。

最近、サム・アルトマンの「大規模言語モデルの時代は終わった」という告白がインターネット上で話題となりました。Wired-によるこのレポートによると

しかし、同社のCEOであるサム・アルトマンは、さらなる進歩はモデルを大きくすることでは得られないと言います。「先週末にMITで開催されたイベントで、彼は聴衆に「私たちは、このような、巨大で巨大なモデルになる時代の終わりにいると思います。"他の方法でより良いものにする "と。

- 記事-OpenAIのCEO、巨大なAIモデルの時代はすでに終わったと語る

このことは、オンライン空間に顕著な波紋を投げかけている。2022年11月以降、AI Expert(具体的にはGPT Expert)の数が顕著に増えているのを確認しています。これらのGPT/LLMの戦士たちは、何兆ものパラメータとより多くのデータを追加することが、人々が思っているよりも早く終焉を迎えるかもしれないということに基づいて、AGIと100倍の生産性に基づくAIを約束してきました。アレックス・ホルモジは今、平和な日々を送ることができるようだ。

この記事では、AI分野の多くの人々にとって冒涜的と思われるようなことを主張したいのです。データを見て、実際に結果を比較してみると、より多くのデータを投入し、パラメータサイズを大きくすることは、GPT-4のようなスケーリングの限界にぶつかり始めるずっと前から、常に失敗する運命にあることが明らかです。この問題をどのように予見できたかを理解することで、今後このような間違いを犯さないようにすることができ、多くの時間、お金、注意を節約することができるのです。

ChatGPTやDall-E 2といった人気の言語モデルを開発したAI研究会社OpenAIは、チャットボットの開発費の高騰により、2022年の損失が5億4000万ドルに倍増したと報じられています。同社は現在、自らの能力を向上させるほど高度なAIである人工一般知能(AGI)の開発という目標に向けて、今後数年間で1000億ドルもの資金を調達しようとしています。

-ソースはこちら これらのモデルの誇大広告は、大きなバブルを引き起こしています。巻き込まれないように気をつけましょう

楽しそうでしょう?さっそく始めてみましょう。

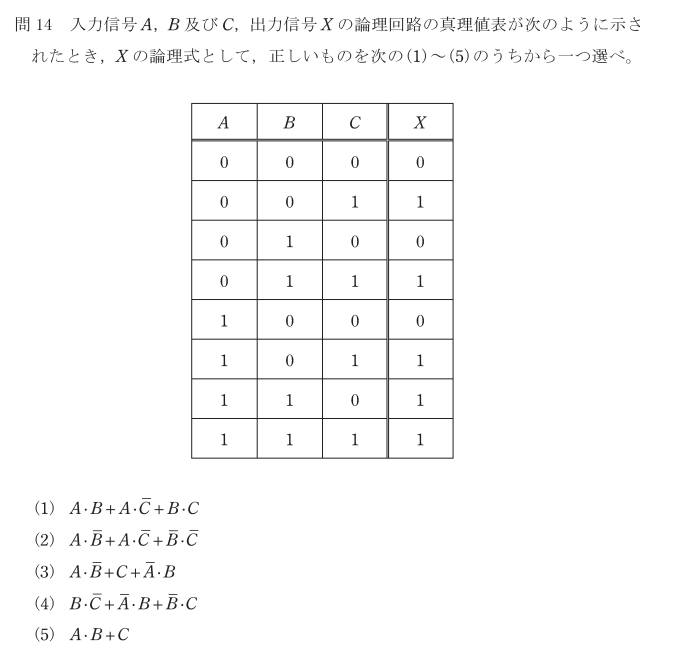

Saturation of Benchmarks

One of the most important cornerstones of the hype behind AI was the performance increases that LLMs hit with multiple benchmarks. Every week, we found that GPT/a new Language Model was able to match/beat SOTA performance on a new benchmark or task. Who can forget the hype that we hit when we learned that GPT can pass the Bar Exam and even act as a doctor?

This led to a lot of speculation on AGI and how these models were developing so-called emergent abilities. However, peering behind the hood tells you a very different story.

In earlier years, people were improving significantly on the past year’s state of the art or best performance. This year across the majority of the benchmarks, we saw minimal progress to the point we decided not to include some in the report. For example, the best image classification system on ImageNet in 2021 had an accuracy rate of 91%; 2022 saw only a 0.1 percentage point improvement.

-Source

People involved in deep learning for a while will know an uncomfortable truth- AI performance has been increasingly saturated for a few years, way before we had investors and social media influencers blindly pushing the hype behind large language models. Machine Learning Researchers have burned more and more computation for increasingly smaller gains (sometimes under a percentage point).

AI continued to post state-of-the-art results, but year-over-year improvement on many benchmarks continues to be marginal. Moreover, the speed at which benchmark saturation is being reached is increasing.

- Stanford AI Index Report 2023

Seen from this perspective, you should be less excited about these so-called amazing architectures. When it comes to performance- sure they can hit benchmarks- but at what cost? Deploying these models at any kind of scale would have you running out of computing budgets quicker than Haaland breaking goal-scoring records. Don’t forget, the scale that makes these models powerful also makes them extremely expensive to deploy in contexts where you have to make a lot of inferences ( Amazon Web Services estimates that “In deep learning applications, inference accounts for up to 90% of total operational costs”.).

According to researchers who wrote, Estimating the Carbon Footprint of BLOOM, a 176B Parameter Language Model[3], it took roughly 50.5 tons of CO2 equivalent to train the large-language model BLOOM. GPT-3 released over 500 tons of CO2 equivalent.

- Once you’re done with article, check out my article on the ethics of Copilot

However, that is far from the only issue that made GenAI far less promising than the internet would have led you to believe. Let’s now cover something that would come as a surprise to a lot of people who have graduated from ChatGPT University.

ベンチマークの飽和状態

AIの宣伝の最も重要な基礎の1つは、LLMが複数のベンチマークで性能向上を達成したことです。毎週、GPTや新しい言語モデルが、新しいベンチマークやタスクでSOTAと同等かそれ以上のパフォーマンスを発揮していることがわかりました。GPTが司法試験に合格し、医師として活動できることを知ったときの誇大広告を忘れることはできないでしょう。

そのため、AGIに関する多くの憶測が飛び交い、これらのモデルがいわゆる創発的な能力をどのように開発しているかが話題になりました。しかし、フードの裏側を覗き込むと、非常に異なるストーリーが見えてきます。

それ以前の年では、人々は過去1年間の最先端技術や最高のパフォーマンスを大幅に向上させていました。しかし、今年はほとんどのベンチマークで、報告書に掲載しないことを決めたほど、わずかな進歩しか見られません。例えば、2021年にImageNetで最も優れた画像分類システムの精度は91%でしたが、2022年には0.1%ポイントしか向上していません。

-出典

投資家やソーシャルメディアのインフルエンサーが大規模な言語モデルの誇大広告を盲目的に押し付けるようになるずっと前から、AIの性能は数年前からますます飽和状態になっていました。機械学習の研究者たちは、ますます小さな利益(時には1%ポイント以下)のために、より多くの計算を消費してきました。

AIは最先端の結果を出し続けましたが、多くのベンチマークで前年比の向上はわずかなものでした。さらに、ベンチマークが飽和状態に達するスピードも速くなっている。

- スタンフォードAIインデックスレポート2023

このような観点から見ると、いわゆる素晴らしいアーキテクチャについては、あまり期待しないほうがよいでしょう。パフォーマンスに関しては、確かにベンチマークを達成することができますが、その代償は?これらのモデルをどのような規模で展開しても、Haalandがゴール記録を更新するよりも早く、コンピューティング予算が尽きてしまうでしょう。忘れてはならないのは、これらのモデルを強力にする規模は、多くの推論を行う必要がある状況で展開するには非常に高価になるということです(Amazon Web Servicesは、「深層学習アプリケーションでは、推論が運用コスト全体の最大90%を占める」と推定しています)。

Estimating the Carbon Footprint of BLOOM, a 176B Parameter Language Model[3]を書いた研究者によると、大規模言語モデルBLOOMを訓練するために、およそ50.5トンのCO2換算が必要だった。GPT-3では、500トン以上のCO2が排出されました。

- この記事を読み終えたら、「Copilot」の倫理に関する私の記事もご覧ください。

しかし、GenAIがネットの情報よりもはるかに期待できないのは、この問題だけではありません。ChatGPT大学を卒業した多くの人にとって驚きであろうことを、次に取り上げましょう。

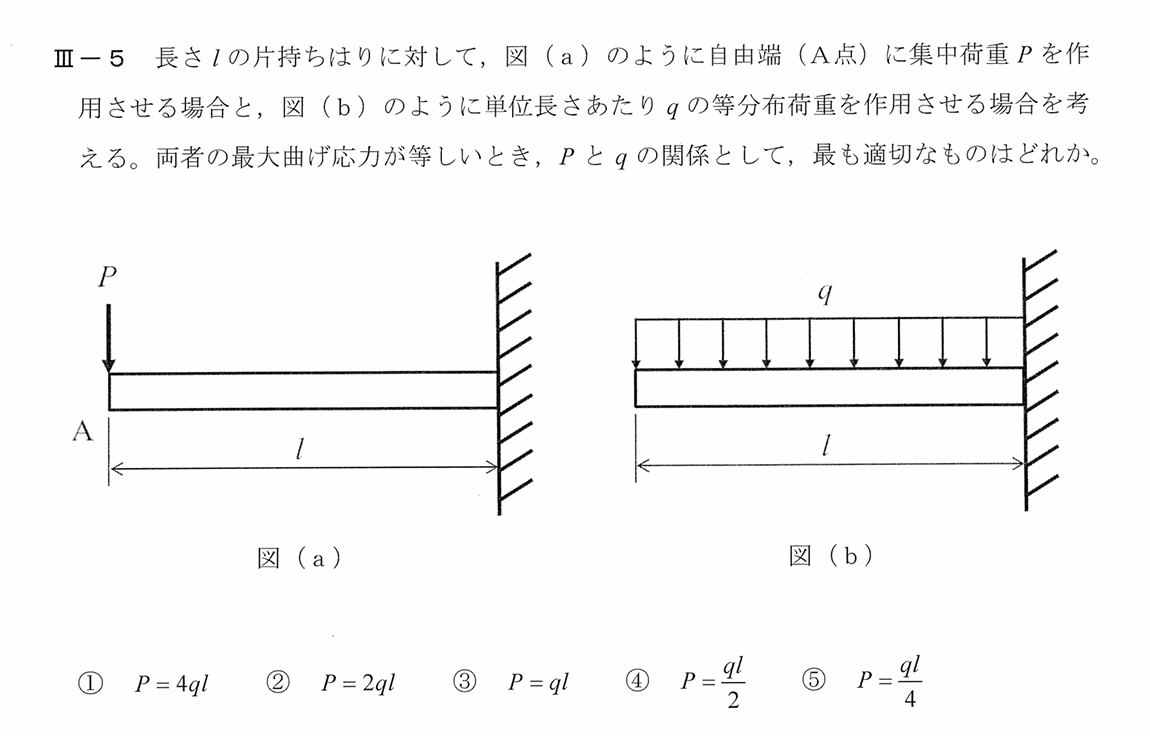

Performance

Here’s something that would surprise you if you only read about GPT from online influencers telling you how to get ahead of 99% of people- these models are just not very good. When it comes to practically implementing Large Language Models into systems that are useful, efficient, and safe- these structures fall apart.

When it comes to business use cases, these models are often lose to very simple models. The authors of “A Comparison of SVM against Pre-trained Language Models (PLMs) for Text Classification Tasks” compared the performance of LLMs with a puny SVM for text classification in various specialized business contexts. They fine-tuned and used the following models-

These models were stacked against an SVM and some old-fashioned feature engineering. The results are in the following table-

This extends beyond just text classification. Fast AI has an exceptional write-up investigating Github Copilot. One of their stand-out insights was- “According to OpenAI’s paper, Codex only gives the correct answer 29% of the time. And, as we’ve seen, the code it writes is generally poorly refactored and fails to take full advantage of existing solutions (even when they’re in Python’s standard library).” Just to drill home how overrated these models can be for coding, here are some of the problems with these models that the amazing Luca Rossi explored in his insightful AI & The Future of Coding 🤖. In it, he attempted to create the following with in Node-

Write a Telegram bot that answers my questions like ChatGPT, using OpenAI API

-a relatively simple task, for any competen t developer

The code generated in Node didn’t work. Below is Luca’s analysis of the situation- It turns out, the AI used methods that do not exist in the Node library, probably inspired by the Python ones.

Below is Luca’s experience with Debugging-

I replaced them and things worked fine. Two considerations:

Debugging the code required me to study the openai and telegraf libraries, undoing 90% of the benefit of using the AI in the first place.

Debugging was surprisingly hard, because these were not the kind of mistakes a normal person makes. When we debug, our brain is wired for looking at things we are more likely to get wrong. When you debug AI code, instead, literally anything can be wrong (maybe over time we will figure out the most common AI mistakes), which makes the work harder. In this case, AI completely made a method up — which is not something people usually do.

Along with this, Luca has some great insights into how using AI Coders would cause a lot of duplication of work in bug fixing and system design, would destroy innovation, use outdated methods, and a few other concerns. Would highly recommend checking out his work here-

Let’s beyond ChatGPT and onto the allegedly early signs of AGI that were discovered in Microsoft’s 155 Page report- Sparks of Artificial General Intelligence: Early experiments with GPT-4. In it, we GPT-4 failing at some relatively simple tasks when it comes to a very simple task-

We see GPT-4 adding new information to the note, even though the prompt explicitly states- using exclusively the information above (and keep in mind this is Microsoft’s hype piece on GPT-4, so we don’t see the real disasters). Show this to the people that want to use GPT for doctors. If these systems are implemented recklessly, people will suffer. Regular readers know that I prefer not making sensational statements, but this is not me click-baiting you about AI’s existential threat. This is me telling you about a very real issue with these systems. If you’d like to read more about my investigation into GPT-4 and understand how the writers of the GPT-4 report ignored very real problems with their claims of AGI- read Observations on Microsoft’s Experiments with GPT-4.

パフォーマンス

GPTについて、ネット上のインフルエンサーから99%の人に差をつける方法を聞いただけでは、驚かないかもしれません。ラージ・ランゲージ・モデルを実用的で効率的、かつ安全なシステムに実装しようとすると、これらの構造は破綻します。

ビジネスのユースケースになると、これらのモデルは、しばしば非常に単純なモデルに負けてしまう。A Comparison of SVM against Pre-trained Language Models (PLMs) for Text Classification Tasks」の著者は、様々な特殊なビジネスコンテクストにおけるテキスト分類について、LLMと貧弱なSVMのパフォーマンスを比較しました。彼らは以下のモデルを微調整して使用しました。

これらのモデルは、SVMや昔ながらの特徴工学と比較されました。結果は次の表の通りです。

これは、単なるテキスト分類にとどまりません。Fast AIは、Github Copilotを調査した優れた記事を掲載しています。OpenAIの論文によると、Codexは29%の確率で正しい答えを出しています。そして、私たちが見てきたように、Codexが書くコードは一般的にリファクタリングが不十分で、既存のソリューション(たとえそれがPythonの標準ライブラリにある場合でも)を十分に活用できていない。これらのモデルがコーディングにとっていかに過大評価されうるかを叩き込むために、素晴らしいルカ・ロッシが洞察に満ちた『AI & The Future of Coding 🤖』で探求した、これらのモデルの問題点をいくつか紹介します。その中で、彼はNode-で次のようなものを作ろうとしました。

OpenAI APIを使って、ChatGPTのように私の質問に答えてくれるTelegramボットを書く

-比較的簡単な作業で、有能な開発者であれば誰でもできます。

Nodeで生成されたコードは動作しませんでした。AIはNodeのライブラリにないメソッドを使い、おそらくPythonのメソッドにインスパイアされていることがわかりました。

以下は、Lucaのデバッグの経験です。

私はそれらを置き換えたところ、物事はうまくいきました。2つ注意点があります:

コードのデバッグには、openaiとtelegrafのライブラリを勉強する必要があり、そもそもAIを使う利点の90%を取り消してしまった。

デバッグは意外と大変でした。なぜなら、これらは普通の人がするようなミスではないからです。デバッグをするとき、私たちの脳は、自分が間違えやすいところを見るようにできています。その点、AIのコードをデバッグする場合は、文字通り何でもありなので、作業が大変です(もしかしたら、そのうちAIのよくある間違いがわかってくるかもしれません)。今回のケースでは、AIが完全にメソッドを作り上げてしまいましたが、これは通常人がすることではありません。

また、ルカは、AIコーダーを使うことで、バグフィックスやシステム設計に多くの重複作業が発生すること、イノベーションを破壊すること、時代遅れの方法を使うこと、その他いくつかの懸念について、素晴らしい洞察を示しています。彼の作品はこちらでご覧ください。

ChatGPTを越えて、マイクロソフトの155ページのレポート「Sparks of Artificial General Intelligence」で発見された、AGIの初期兆候とされるものを見ていきましょう: GPT-4による初期の実験。このレポートでは、GPT-4が比較的簡単なタスクで失敗していることが紹介されています。

GPT-4がノートに新しい情報を追加しているのがわかりますが、プロンプトには「上記の情報のみを使用する」と明示されています(これはマイクロソフトのGPT-4の宣伝記事なので、実際の災害は見られません)。GPTを医者に使おうとしている人たちに、これを見せてあげてください。これらのシステムが無謀に実装されれば、人々は苦しむことになる。私がセンセーショナルな発言を好まないことは常連の読者ならご存知でしょうが、これはAIの存亡の危機についてクリックベイトするものではありません。これは、このようなシステムに関する非常に現実的な問題についてお話ししているのです。GPT-4に関する私の調査についてもっと読みたい方は、「マイクロソフトのGPT-4実験に関する考察」をお読みください。

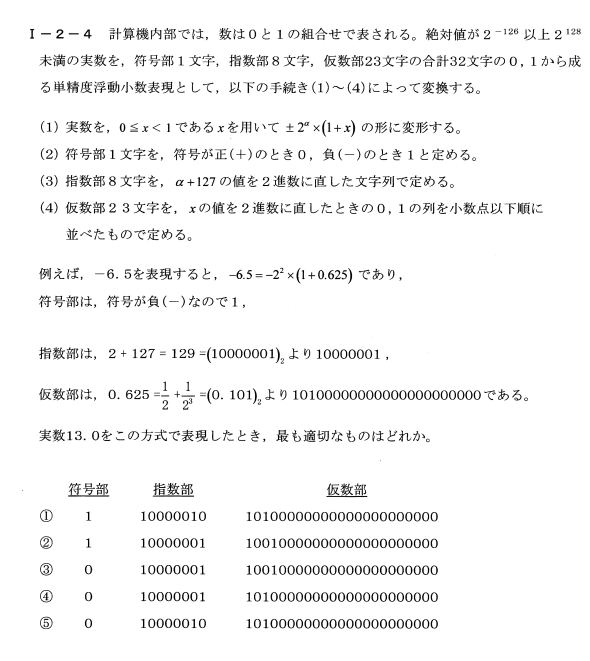

Data-Centric AI

Prior to this ‘bombshell’ admission and GenAI capturing the attention of everyone, there was another trendy buzzword that was moving through the Data Field- ‘Data-Centric AI’. The premise was relatively- we had spent a lot of time building better models and not enough time on improving our data transformation processes. Take a look at this quote from Andrew Ng at an event by MIT-

AI systems need both code and data, and “all that progress in algorithms means it’s actually time to spend more time on the data,” Ng said at the recent EmTech Digital conference hosted by MIT Technology Review.

Once you’re done being wowed by the big names in the statement, tell me what part of that is truly surprising. It’s been well-known that data processing and curation is the most important part of the pipeline since the beginning. The reason that we saw this giant emphasis on models in research was two-fold-

We have big benchmarks/datasets (ImageNet for eg) for many of the standard tasks. In this case, the problem was in the architectures themselves. By standardizing datasets, we could test the effectiveness of various changes to the training pipelines.

Streetlight Effect- The streetlight effect, or the drunkard’s search principle, is a type of observational bias that occurs when people only search for something where it is easiest to look. Combining this with the confirmation bias we see the mess of mindless scaling model size without attention given to other factors- people simply funding/copying whatever is already being done (in our case tweaking architectures). If all you see is working focused on changing architectures, then people will likely create work along a similar vein.

But the unsustainable nature of simply scaling up architectures has been well known to anyone who even remotely understands the field. Once you step outside the bubble of ML Academia and Big Tech AI- you will see that organizations lack the expertise/budgets/inclination to invest into implementing large models because the ROIs are not worth it.

We additionally do not utilize GPUs for inference in production. At our scale, outfitting each machine with one or more top-class GPUs would be prohibitively expensive, … that our models are relatively small compared to state-of-the-art models in other areas of deep learning (such as computer vision or natural language processing), we consider our approach much more economical.

-This is from a writeup by the engineers at Zemanta, a leading advertising firm. Even at their level, SOTA DL isn’t really worth it. To learn more read- How to handle 300 million predictions per second over here

This is why we have seen the move away from bigger models and obscenely big data sets and instead focus on more intelligent design. Intelligent design was explicitly mentioned as one of the reasons Open Source was beating big companies like Google and Open in the infamous ‘Google has no Moat’ document-

Open-Source companies are doing things in weeks with $100 and 13B params that we struggle with at $10M and 540B.

-Read my analysis of the situation here

データセントリックAI

この「爆弾発言」によってGenAIが注目を集める以前、データ分野では「データ中心AI」という別の流行語がありました。より良いモデルの構築に多くの時間を費やし、データ変換プロセスの改善には十分な時間を割けなかった、というのがその前提でした。MITのイベントでのAndrew Ngの言葉を見てください。

AIシステムにはコードとデータの両方が必要です。「アルゴリズムの進歩は、実はデータにもっと時間をかけるべき時なのです」と、MIT Technology Reviewが主催する最近のEmTech DigitalカンファレンスでNgは述べています。

発言の大御所に驚かされたところで、そのどこが本当に驚くべきことなのか、教えてください。データ処理とキュレーションがパイプラインの中で最も重要な部分であることは、当初からよく知られていたことだ。研究においてモデルを重視するようになったのは、次の2つの理由からです。

標準的なタスクの多くには、大きなベンチマークやデータセット(例えばImageNet)がある。この場合、問題はアーキテクチャそのものにありました。データセットを標準化することで、学習パイプラインに様々な変更を加えた場合の有効性を検証することができました。

ストリートライト効果 - ストリートライト効果(酔っぱらいの検索原理)は、人が最も探しやすい場所でしか何かを探さない場合に生じる観察バイアスの一種です。これを確証バイアスと組み合わせると、他の要素に注意を払わず、無心にモデルサイズを拡大すること、つまり、すでに行われていること(この場合はアーキテクチャの調整)に資金を提供したり、コピーしたりすることが、混乱につながることがわかります。もしあなたが、アーキテクチャの変更に焦点を当てた仕事しか見ていないのなら、人々は同じような系統の仕事を作るでしょう。

しかし、単にアーキテクチャを拡張するだけでは持続不可能であることは、この分野を少しでも理解している人なら誰でも知っていることです。MLアカデミアやビッグテックAIのバブルの外に出れば、組織には専門知識、予算、大規模モデルの実装に投資する意欲がなく、ROIがそれに見合わないことが分かるでしょう。

また、私たちは本番で推論にGPUを利用することはありません。我々の規模では、各マシンに1つ以上のトップクラスのGPUを装備することは法外に高価です。...我々のモデルは、深層学習の他の分野(コンピュータビジョンや自然言語処理など)の最先端のモデルと比較して比較的小さいので、我々のアプローチははるかに経済的であると考えています。

-これは、大手広告会社Zemantaのエンジニアが書いたものです。彼らのレベルでも、SOTA DLは本当に価値がない。詳しくは、「1秒間に3億件の予測を処理する方法」をご覧ください。

このような理由から、より大きなモデルや膨大なデータセットから離れ、よりインテリジェントな設計にフォーカスする動きが見られるのです。インテリジェント・デザインは、悪名高い「Google has no Moat」文書の中で、オープンソースがGoogleやOpenのような大企業に勝っている理由の1つとして明確に言及されました。

オープンソースの会社は、100ドルや13Bのパラメータで、私たちが1000万ドルや540Bで苦労していることを、数週間でやっている。

-この状況についての私の分析は、こちらでご覧ください。

Closing

Combining this together, here is a question I want to ask you- when exactly did we have an era of scaling up? At what point was it ever a good idea to implement more and more scaling- as opposed to focusing on better data selection, using ensembles/mixture of experts to reduce errors, or constraining the system to handle certain kinds of problems to avoid errors? People have been calling this unsustainable for a long time, way before general-purpose LLMs were a mainstay in ML.

Rather than an insightful statement about the future of AI, Sam Altman’s statement is a face-saving maneuver. As is becoming clear- the market is becoming increasingly saturated and OpenAI has no clear direction for making money. Even if they did corner the market, they can’t raise prices because customers can always switch to open-source models (and this assumes that the OpenAI models are meaningfully better- which is debatable). The bubble is bursting, the chickens have come home to roost, and this statement is Sam Altman is now scrambling to maintain the facade that these problems are under control.

That is it for this piece. I appreciate your time. As always, if you’re interested in reaching out to me or checking out my other work, links will be at the end of this email/post. If you like my writing, I would really appreciate an anonymous testimonial. You can drop it here. And if you found value in this write-up, I would appreciate you sharing it with more people. It is word-of-mouth referrals like yours that help me grow.

Save the time, energy, and money you would burn by going through all those videos, courses, products, and ‘coaches’ and easily find all your needs met in one place at ‘Tech Made Simple’! Stay ahead of the curve in AI, software engineering, and the tech industry with expert insights, tips, and resources. 20% off for new subscribers by clicking this link. Subscribe now and simplify your tech journey!

Using this discount will drop the prices-

800 INR (10 USD) → 640 INR (8 USD) per Month

8000 INR (100 USD) → 6400INR (80 USD) per year

Get 20% off for 1 year

Reach out to me

Use the links below to check out my other content, learn more about tutoring, reach out to me about projects, or just to say hi.

If you like my writing, I would really appreciate an anonymous testimonial. You can drop it here.

To help me understand you fill out this survey (anonymous)

Small Snippets about Tech, AI and Machine Learning over here

Check out my other articles on Medium. : https://rb.gy/zn1aiu

My YouTube: https://rb.gy/88iwdd

Reach out to me on LinkedIn. Let’s connect: https://rb.gy/m5ok2y

My Instagram: https://rb.gy/gmvuy9

My Twitter: https://twitter.com/Machine01776819

Very similar to Crypto

クロージング

スケーリングアップの時代はいつから始まったのでしょうか?より良いデータ選択、アンサンブルや混合エキスパートを使ってエラーを減らすこと、あるいはシステムを特定の種類の問題を扱うように制限してエラーを回避することに焦点を当てるのではなく、より多くのスケーリングを実施することが良いアイデアであったのはどの時点からでしょうか。汎用LLMがMLの主流になるずっと以前から、人々はこれを持続不可能と呼んできました。

サム・アルトマンの発言は、AIの将来についての洞察に満ちた発言というよりも、むしろ面目を保つための作戦といえるでしょう。明らかになりつつあるように、市場は飽和状態になりつつあり、OpenAIはお金を稼ぐための明確な方向性を持っていません。仮に市場を制覇したとしても、顧客はいつでもオープンソースモデルに乗り換えることができるため、価格を上げることはできません(これは、OpenAIのモデルが有意義に優れているという前提での話ですが、議論の余地はありますね)。バブルは崩壊し、鶏はねぐらに帰ってきた。この発言は、サム・アルトマンが、これらの問題がコントロールされているという見せかけを維持するために奔走していることを示している。

以上、本編を終わります。お時間をいただき、ありがとうございました。いつものように、私に連絡を取ったり、私の他の作品をチェックしたりすることに興味があれば、このメールや記事の最後にリンクを貼っておきます。もしあなたが私の文章を気に入ってくれたなら、匿名の証言にとても感謝しています。ここに書き込んでください。そして、もしあなたがこの書き出しに価値を見出したのなら、より多くの人にシェアしていただけるとありがたいです。あなたのような口コミによる紹介が、私を成長させてくれるのです。

ビデオ、コース、製品、コーチなど、あらゆるものを見て回ることで消費する時間、エネルギー、お金を節約し、「Tech Made Simple」で簡単にすべてのニーズを1か所で満たすことができます!専門家の洞察、ヒント、リソースで、AI、ソフトウェアエンジニアリング、テック業界のカーブを先取りしてください。このリンクをクリックすると、新規購読者が20%オフになります。今すぐ購読して、技術の旅をシンプルにしましょう!

この割引を利用すると、価格が下がります

800 INR (10 USD) → 640 INR (8 USD) /月

8000 INR (100 USD) → 6400INR (80 USD)/年

1年間は20%オフ

お問い合わせはこちら

以下のリンクから、私の他のコンテンツをチェックしたり、家庭教師について詳しく学んだり、プロジェクトについて連絡を取ったり、単に挨拶したりすることができます。

私の文章を気に入っていただけたなら、ぜひ匿名の証言をお願いします。ここに書き込むことができます。

あなたのことを理解するために、このアンケートに答えてください(匿名)。

技術、AI、機械学習に関する小さな小ネタ集はこちら

Mediumで私の他の記事をチェックする。 : https://rb.gy/zn1aiu

私のYouTube: https://rb.gy/88iwdd

LinkedInで私に連絡を取ってください。つながりましょう: https://rb.gy/m5ok2y

私のInstagram: https://rb.gy/gmvuy9

私のツイッター: https://twitter.com/Machine01776819

Cryptoとよく似ている