https://www.theinformation.com/articles/microsoft-reveals-2-seller-ai-apps-behind-openai?utm_source=ti_app&rc=01qtpq

📌 概要

コパイロットのサブスクはどのようなことができますか?

Microsoft Copilot(コパイロット)のサブスクで何ができるかを、用途別に整理します👇

🧠 Microsoft Copilotとは?

Microsoft 365、Windows、Edge、GitHub などに

深く統合された生成AIで、

「文章作成・資料作成・分析・検索・コード生成」を

業務フローの中でそのまま行えるのが最大の特徴です。

💰 主なサブスク体系(代表例)

① Copilot Pro(個人向け)

- 月額 約3,200円($20)

- Word / Excel / PowerPoint / Outlook / OneNote で利用可

- GPT-4系モデル優先利用

- 生成回数制限が緩い

👉

個人研究・資料作成・ブログ・投資分析などに向く

② Copilot for Microsoft 365(法人向け)

- 月額 約4,500円/人

- Teams / Outlook / SharePoint / OneDrive と完全連携

- 社内データ(権限ベース)を横断検索・要約

- 会議要約・議事録・ToDo自動生成

👉

組織業務の“AI秘書”

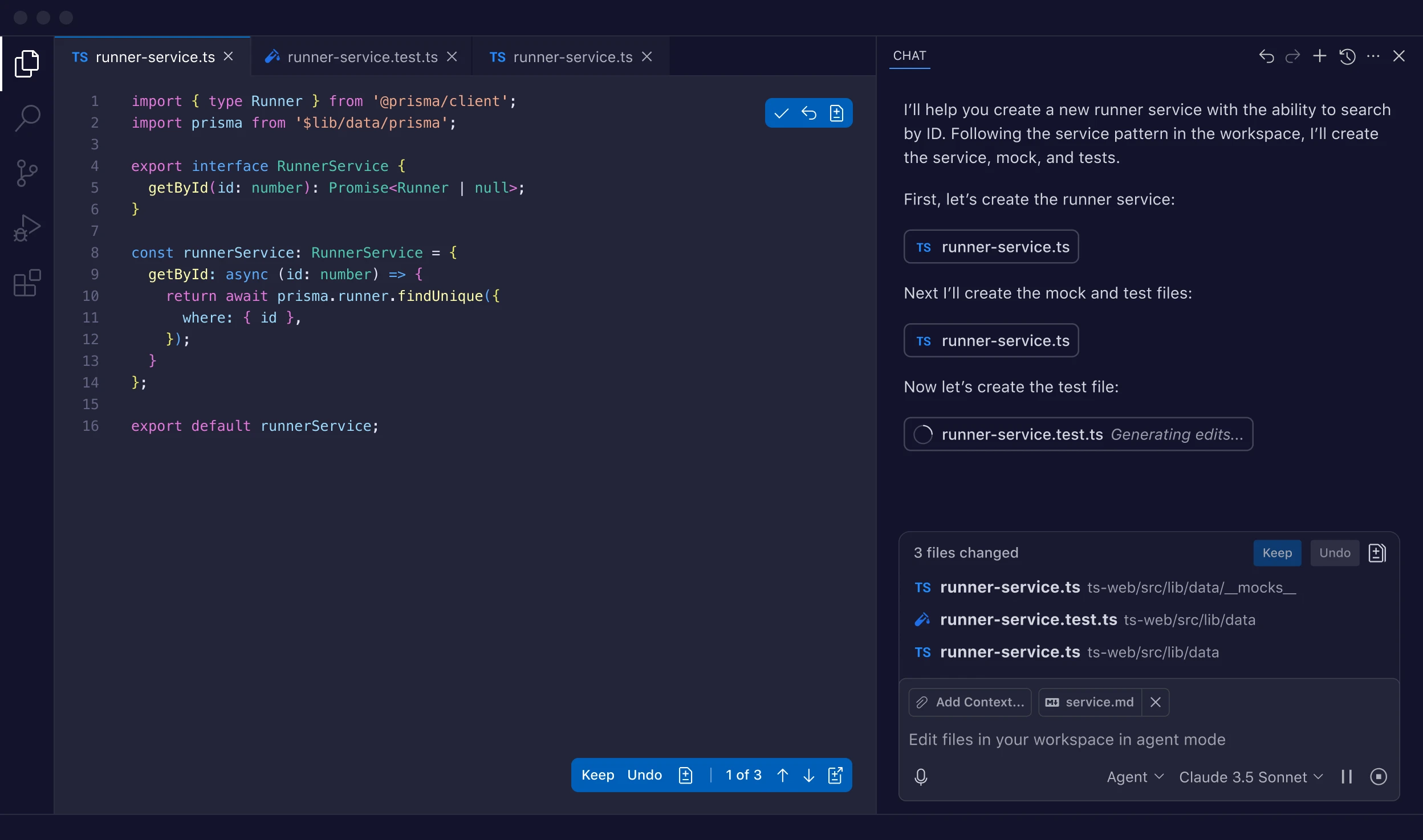

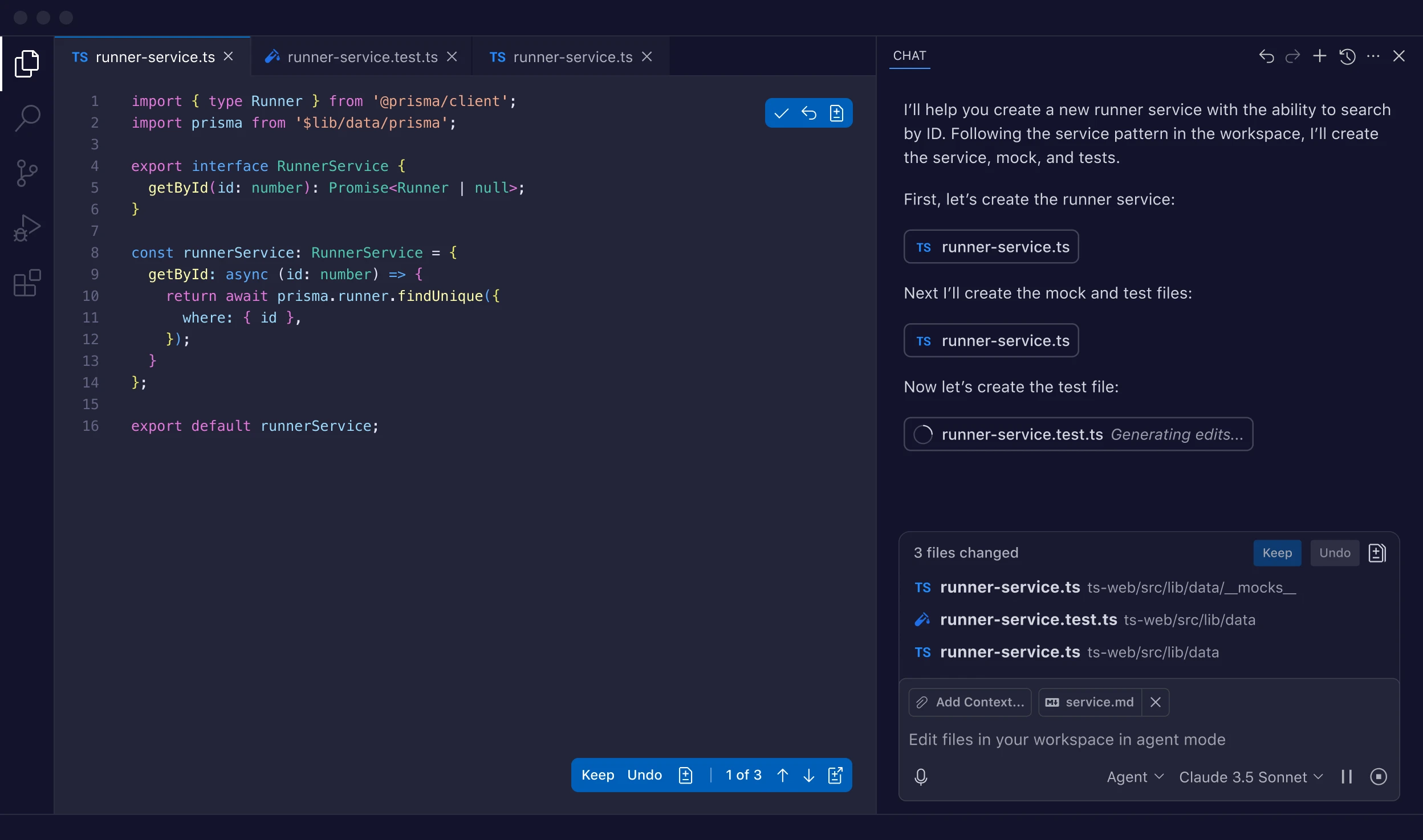

③ GitHub Copilot

- 月額 約10〜19ドル

- コード補完・関数生成・テスト生成

- コメント→コード化

- ROS / Python / C++ / MATLAB など対応

👉

研究・ロボティクス・制御コードと相性抜群

✨ できること(具体例)

📝 文書・論文・レポート

- Wordで

👉「この章を学術論文調に書き直して」

👉「査読コメントへの回答文を作って」

- 長文PDFや特許の要約

📊 Excel分析(かなり強力)

- 「この売上データの異常値を説明して」

- 「ROICとWACCを計算してグラフ化」

- 数式・ピボット・VBA補助

📽 PowerPoint自動生成

- 「このWord原稿から学会発表用スライドを作成」

- 図構成・箇条書き・話す内容まで提案

📧 Outlook / Teams

- メール下書き・要点抽出

- 会議内容 →

要約+決定事項+次のアクション

- 「先週の◯◯議論をまとめて」

💻 コーディング(GitHub Copilot)

- ROSノード生成

- Python分析コード

- コメント → 実装

- テスト・例外処理の自動補完

🔐 ChatGPTとの決定的な違い

| 観点 |

Copilot |

ChatGPT |

| Office連携 |

◎ 完全統合 |

△ コピペ |

| 社内データ |

◎ 権限付き参照 |

✕ |

| 会議・メール |

◎ 実務特化 |

△ |

| 自由度 |

△ |

◎ |

| 研究ブレスト |

◯ |

◎ |

👉

Copilot = 実務AI

👉

ChatGPT = 思考・研究AI

🎯 あなたの用途に当てはめると(参考)

- 論文執筆・特許整理 → Copilot Pro + ChatGPT

- Excelでの投資分析 → Copilot Pro

- ROS / VPR / SCOUT-E 開発 → GitHub Copilot

- 研究室・組織運用 → Copilot for M365

必要なら

- どのプランが最適かの判断

- ChatGPTとの併用戦略

- 研究・ロボティクス用途に特化した使い分け

まで具体的に整理しますよ。

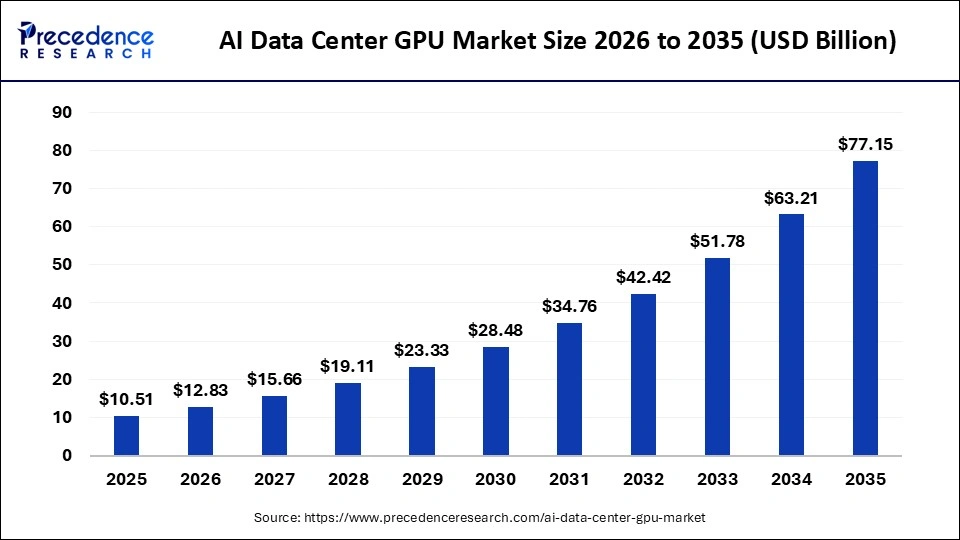

どこの企業もGPUの能力は足りてないですか?

結論から言うと、

はい。ほぼすべての主要AI企業で「GPU能力は足りていません」。

ただし「同じ不足」ではなく、

不足の質と深刻度が企業ごとに違うのが重要です。

なぜ「どこも足りない」のか(構造的理由)

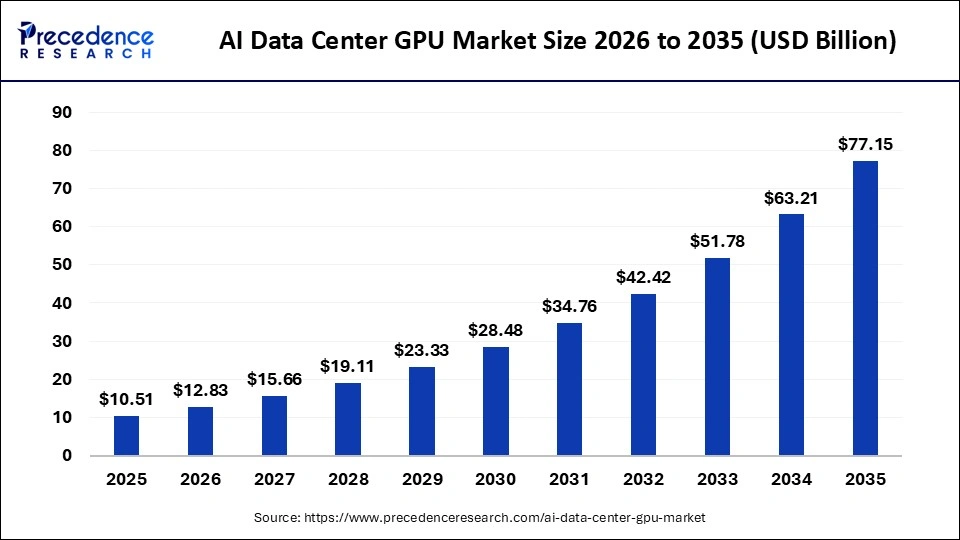

① GPU需要が“想定外”に爆発

- 生成AI(学習+推論)が常時GPUを消費

- 従来:学習中心

- 現在:学習+24時間推論(Copilot / ChatGPT / API)

👉 GPUが「一時的資源」から

恒常的インフラに変わった

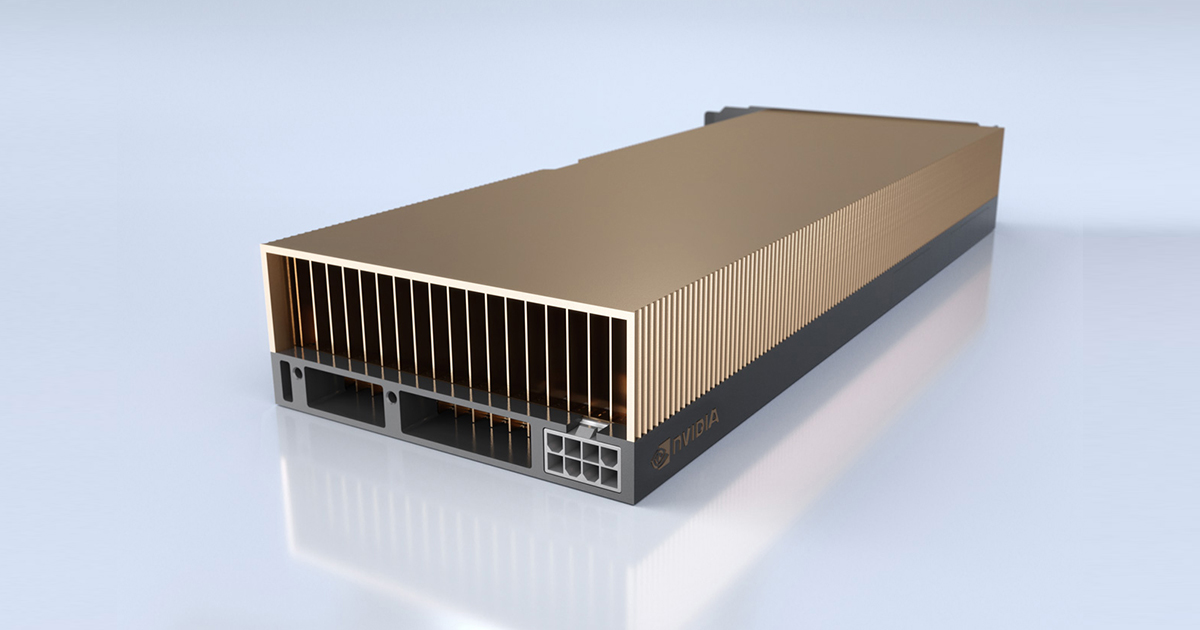

② 実質的な高性能GPU供給元は NVIDIA しかない

- H100 / H200 / B100 などは数か月〜1年待ち

- AMD・Intelはまだ代替になり切れていない

👉

世界的な供給制約

③ GPUは「お金」だけでは解決しない

必要なのは:

- 電力

- 冷却

- データセンター用地

- ネットワーク

- 運用人材

👉

資本力 × インフラ整備力 × 設計力が必要

企業別の「GPU不足の質」

🟦 Microsoft

- 状態:需要>供給

- 特徴:

- 戦略:

- GPUを 外販(Azure)と内製AI(Copilot等)で奪い合い

- → 足りていないが、最も戦略的に配分

🟧 Google

- 状態:GPU不足をTPUで一部回避

- 特徴:

- 問題:

- → GPU依存は減らせているが、計算資源は依然タイト

🟨 Amazon(AWS)

- 状態:供給能力は最大級だが需要も最大

- 特徴:

- AWS Trainium / Inferentia

- 課題:

- → 量はあるが、欲しいGPUが足りない

🟥 OpenAI

- 状態:常にGPU不足

- 理由:

- → Microsoftの供給が生命線

🟩 Meta

- 状態:自社向けでも不足

- 特徴:

- 問題:

- → 「持っているが足りない」

🟪 xAI

- 状態:極端に足りない

- 特徴:

- → 資金はあるが、GPUが来ない

重要な整理(誤解しやすい点)

❌「GPUが足りない=AIが失速」

⭕「GPUが足りない=

AI需要が強すぎる」

❌「Microsoftが39%成長=限界」

⭕「

GPUを配分した結果の数字」

今後どうなる?

短期(〜1年)

中期(2〜4年)

👉

「GPUの量」から「GPUの使い方」競争へ

一文でまとめると

主要AI企業は例外なくGPUが足りていない。

ただし勝敗を分けるのは「持っている量」ではなく、

「誰に・何に・いつ使うか」を決める戦略である。

もし次に進むなら、

- NVIDIA一強はいつ崩れるか

- AIチップ内製は本当に勝てるか

- GPU不足はバブル崩壊の前兆か?

どれを深掘りしますか?

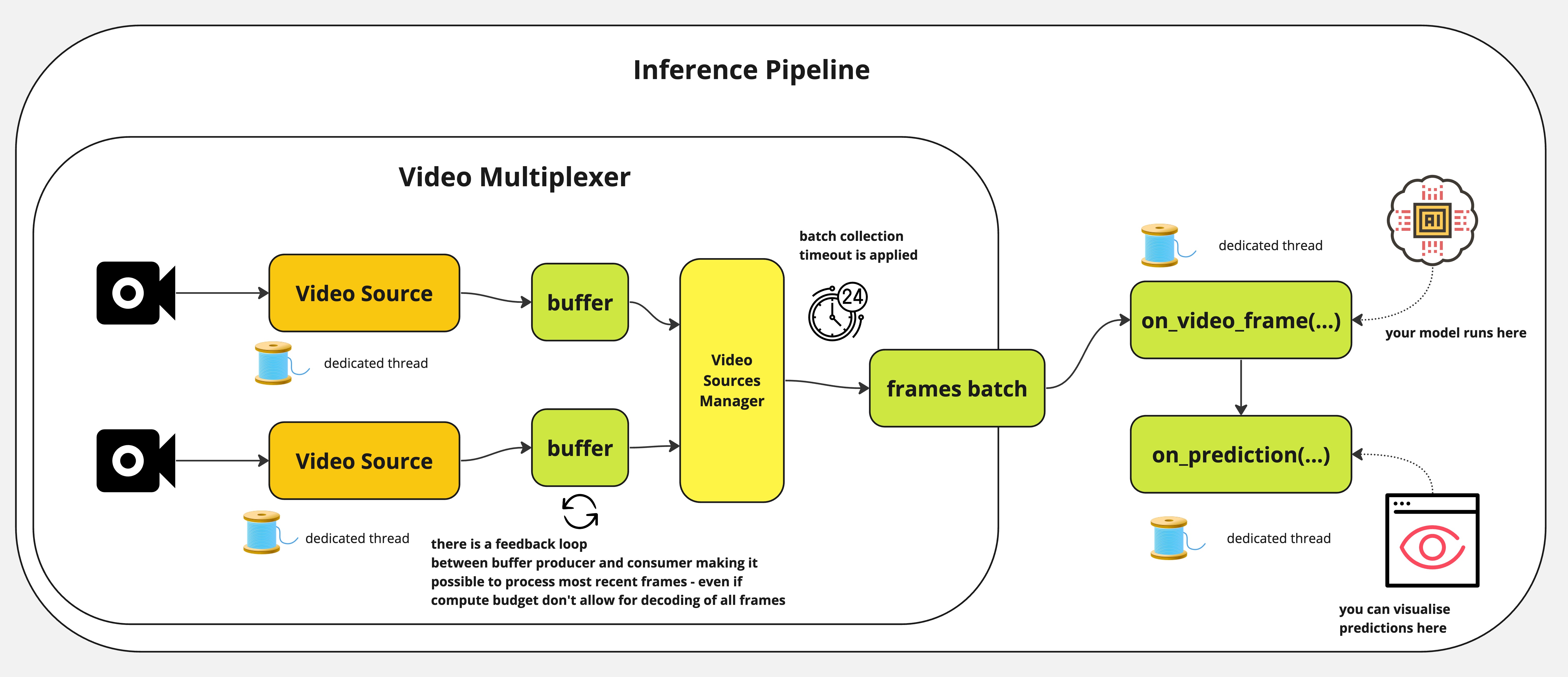

推論部もかなりGPUを必要としていますか?

はい、

推論(Inference)も現在は「かなりGPUを必要としています」。

むしろ

多くの企業では、すでに「学習より推論の方がGPUを食う段階」 に入りつつあります。

なぜ推論がGPUを大量に使うのか

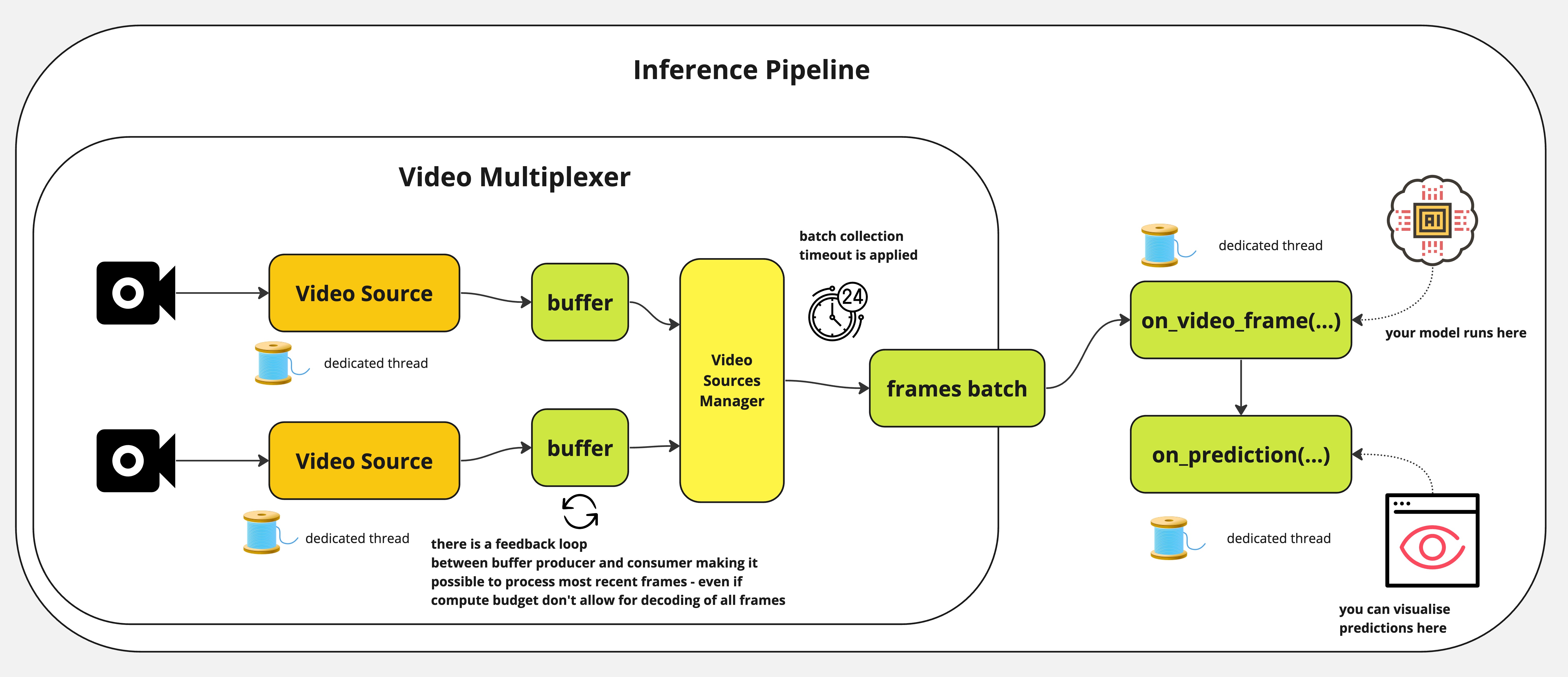

① 生成AIは「1回で終わらない」

- 画像分類(旧来AI)

→ 1回の推論で終了

- LLM / 生成AI

→ トークンを1つずつ順次生成

👉

1リクエスト=数百〜数千回の小推論

② 同時ユーザー数が桁違い

- 学習:夜間・バッチ・計画的

- 推論:24時間・リアルタイム・突発的

👉

ピーク対応のためGPUを遊ばせる必要がある

③ 大規模モデルは「載せるだけでGPU占有」

- モデルサイズ:

- 70B → 数十GB

- 100B超 → 100GB以上

- 1GPUに1モデル常駐が普通

👉

GPUは“メモリ占有資源”

学習 vs 推論:GPU消費の逆転

| 観点 |

学習(Training) |

推論(Inference) |

| 実行形態 |

バッチ |

常時 |

| GPU利用率 |

高いが一時的 |

低めでも常駐 |

| 需要の伸び |

鈍化 |

爆発的 |

| 売上 |

間接 |

直接(API / サブスク) |

👉

事業化すると推論が本体

企業事例(実態)

🟦 Microsoft

- Copilot / Azure OpenAI

- 推論がGPU消費の主役

- GPUを「外販 or 内製AI」で奪い合い

🟥 OpenAI

- ChatGPT

- 学習より 推論がボトルネック

- 無料ユーザーですらGPUコストが重い

🟩 Meta

- Llama推論

- 広告・推薦に組み込み

- 常時推論地獄

🟨 Amazon(AWS)

- Bedrock

- 顧客推論需要が急増

- Inferentiaでも追いつかない場面

「じゃあCPUでは無理?」

原理的には可能、でも…

👉

商用サービスはGPU(または専用AIチップ)必須

今後の流れ(重要)

① 推論最適化が最大テーマ

- 量子化(INT8 / INT4)

- KVキャッシュ圧縮

- バッチ化・分割推論

- MoE(必要部分だけ計算)

② 「学習用GPU」と「推論用GPU」が分離

- 高精度・高帯域 → 学習

- 省電力・高効率 → 推論

一文でまとめると

生成AI時代では、推論は“軽い処理”ではなく、

事業のボトルネックになるほどGPUを消費する中核処理である。

次に進むなら、

- 推論コストはいつ下がるのか

- エッジ推論は本当に来るのか

- GPU以外(ASIC)は勝てるのか

どれを掘りますか?

エッジ推論は本当に来るのか?

結論から言うと、

エッジ推論は「来る」けれど、

“クラウドを置き換える形”では来ません。

正確には、

用途を限定して、すでに静かに広がっています。

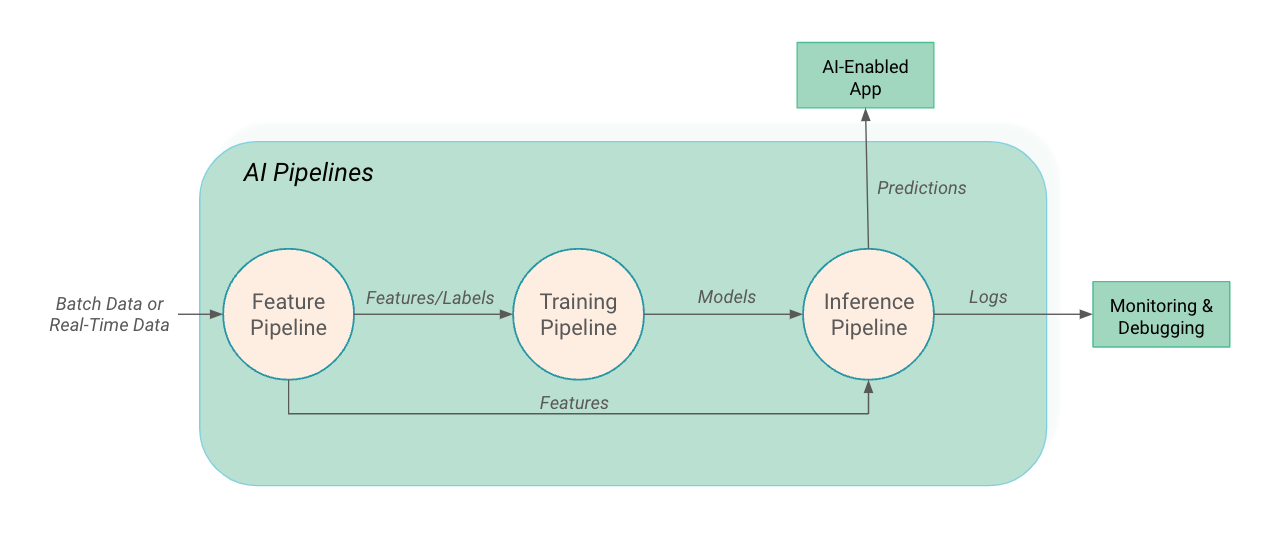

エッジ推論とは何か(整理)

エッジ推論

= 学習済みAIモデルを

**「クラウドに送らず、手元で実行」**すること。

すでに“来ている”分野(現実)

🚗 自動車・ロボット

- カメラ → 認識 → 制御

- 通信遅延ゼロが必須

- クラウド停止=事故はNG

👉

必須

例:

📱 スマホ・PC

- 音声認識

- 翻訳

- 画像補正

- Copilotの一部処理

👉

常時エッジ

🏭 工場・インフラ

👉

通信すら前提にしない

なぜ「全部エッジ」にはならないのか

① モデルが重すぎる

- GPT-4級モデル

- マルチモーダル

- 長文コンテキスト

👉

端末に載らない

② アップデート地獄

👉

集中管理はクラウドが楽

③ 学習は無理

現実解:ハイブリッドAI

| 処理 |

場所 |

| 即時判断 |

エッジ |

| 高度推論 |

クラウド |

| 学習 |

クラウド |

| フェイルセーフ |

エッジ |

👉

人間の脳(反射と熟考)に近い

なぜ今後エッジが増えるのか

① GPU不足の逃げ道

② 専用AIチップの進化

👉

推論専用は爆速

③ プライバシー規制

👉

外に出せない

Big Techのスタンス(重要)

- Microsoft

→ Windows / PC / Copilotの一部をエッジ化

- Apple

→ 原則オンデバイス

- Google

→ エッジ+クラウド併用

- NVIDIA

→ エッジGPU市場を本気で取りに来ている

ロボティクス視点(あなたの文脈で)

あなたがやっている

**T&R / VPR / 状態検出(HOLD / JUMP)**は、

👉

典型的なエッジAI向き

実際、

が

最も筋が良い構成です。

一文で結論

エッジ推論は確実に来るが、

クラウドを置き換える“主役”ではなく、

現実世界とAIをつなぐ“前線”として定着する。

次に掘るなら、

- エッジ用モデル設計の現実解

- どこまでエッジに載せるべきかの線引き

- ロボットAIの正解アーキテクチャ

どれに行きますか?

エッジ推論のGPU関連で有利な企業は?

エッジ推論(オンデバイス推論)で

GPU/AIチップの面から有利とされる企業・勢力を整理すると、以下のようになります👇

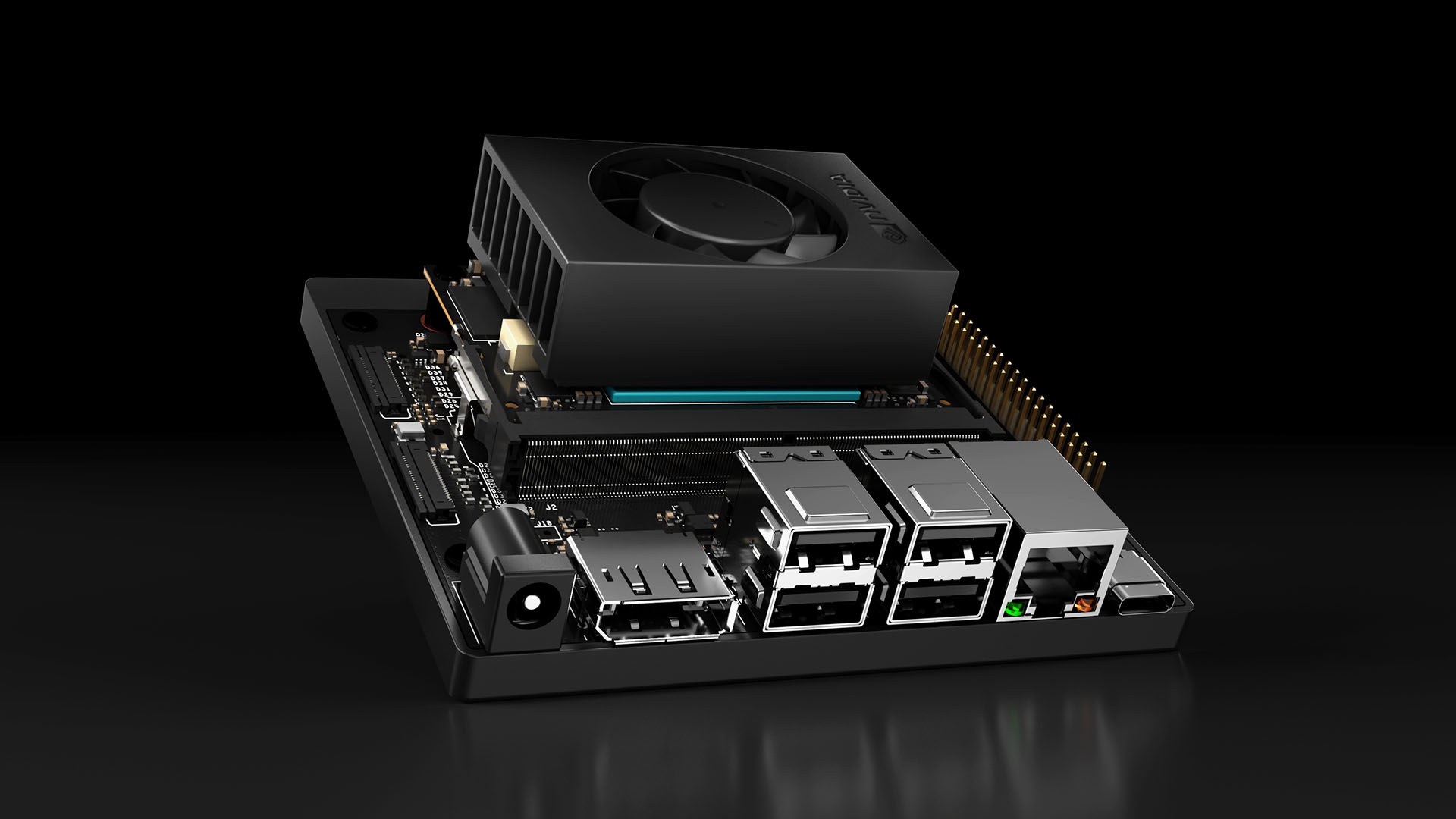

🚀 1. NVIDIA — 総合力トップ

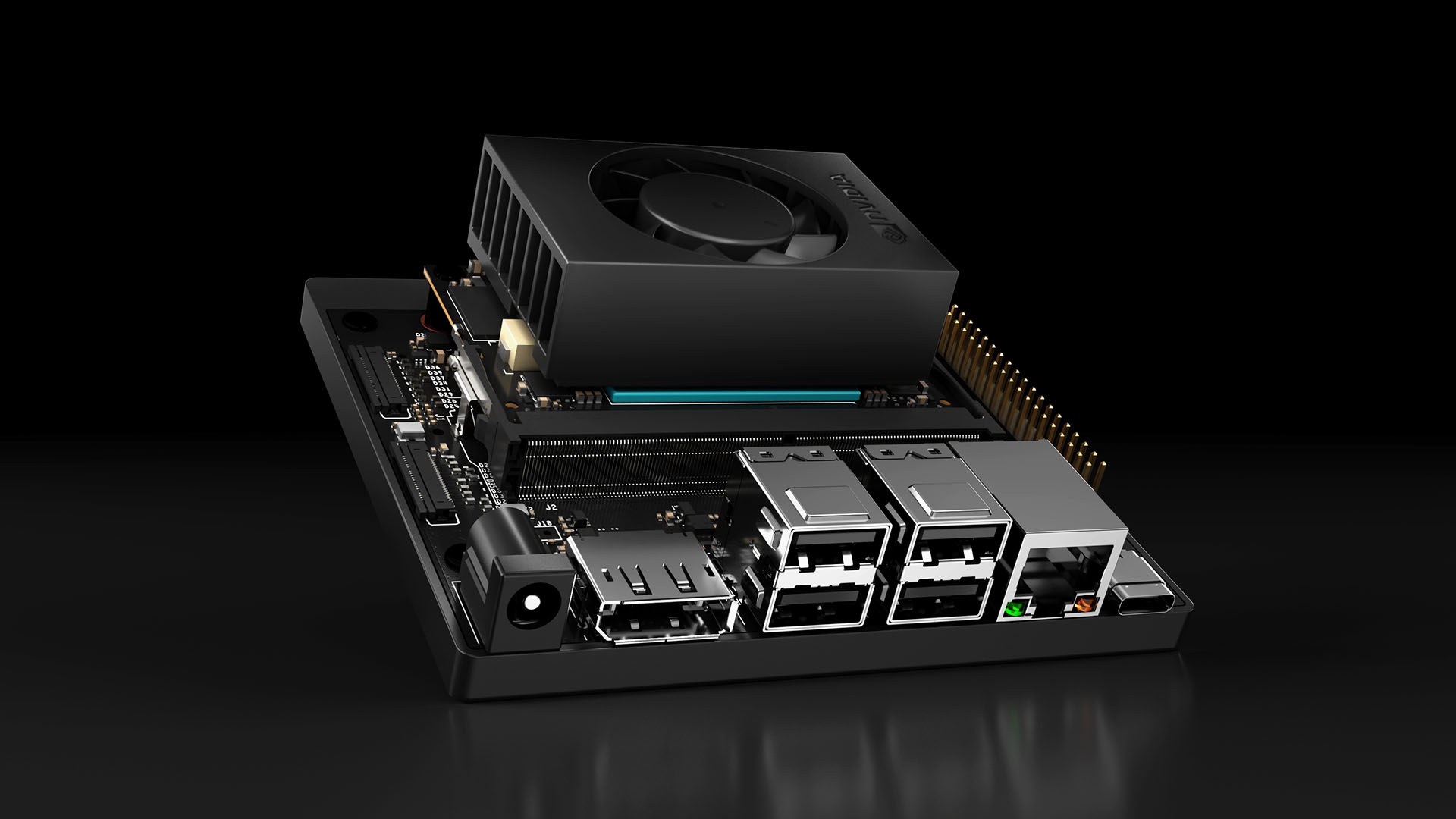

- エッジAI用SoC(Jetsonシリーズ)や、推論・ロボティクス向けモジュールでリード。

- 特にJetson AGX Orinはロボット・自動運転レベルの推論能力を持つエッジAIプラットフォームとして評価が高いです。(AIMultiple)

- クラウド・エッジ双方のGPUエコシステムが強く、開発者ツールやAIライブラリが豊富。(note(ノート))

👉 エッジ推論の幅広い用途で実績とエコシステムが強く、

第一候補。

📱 2. Qualcomm — モバイル/エッジAIの王者

- Snapdragon に搭載される NPU(Neural Processing Unit) がAI推論向けに最適化。

- エネルギー効率と量産性が高く、スマホ・車載・IoTデバイスに広く普及。(MarketsandMarkets)

- 同社はデータセンター向けAI加速器も開発し、NVIDIA・AMDに挑戦する動きもあります。(Precedence Research)

👉 エッジ推論の「実利用数」で最も強いポジション。

🍏 3. Apple — オンデバイスAIの牽引

- iPhone / Mac のチップ(A / Mシリーズ)に統合された ニューラルエンジン(NPU) で推論処理。

- オンデバイス推論の高い効率(低消費電力 + 性能)で差別化。(MarketsandMarkets)

👉 スマホ/PCエッジAIでは

内部最適化に非常に強い。

🤖 4. 自動車/ロボ向け勢力

(これもエッジ推論で影響力あり)

👉

特定分野向けの強みがあるため、用途によってはNVIDIAを上回ることも。

🧠 5. スタートアップ&カスタムASIC勢

👉

特化用途や地域ごとの強みで存在感を高めています。

📊 まとめ:用途ごとの有利企業

| 用途 |

有利な企業・勢力 |

| 高性能エッジ推論(ロボ・自動運転) |

NVIDIA, Qualcomm |

| スマホ/PC等モバイルエッジ |

Apple, Qualcomm, Samsung |

| 低消費電力/IoTエッジ |

Google (TPU / Coral), Intel (VPU) |

| 特化型 ASIC エッジ |

Huawei, Cambricon, 新興ASICベンダー |

| 全体GPUワールドリーダー |

NVIDIA(依然圧倒的シェア)(SQ Magazine) |

📌 要点

✅

NVIDIA:性能・エコシステムで総合1位

✅

Qualcomm / Apple:モバイル&量産エッジで強い

✅

Google / Intel / Samsung:特化用途や省電力で存在感

✅

新興ASIC勢:推論専用で差別化が進行中

🧠 一言で言うと

エッジ推論では「GPU一強」ではなく、

用途やサイズ(スマホ/車載/ロボ/工場)ごとに強いプレーヤーが分かれる。

ただし、NVIDIAの総合力は依然として高い。(SQ Magazine)

必要なら、

- 用途別おすすめチップ選び(例:ロボ・スマホ・IoT)

- GPU vs ASIC vs NPU の実際の性能比較

まで解説できますよ。どれ知りたいですか

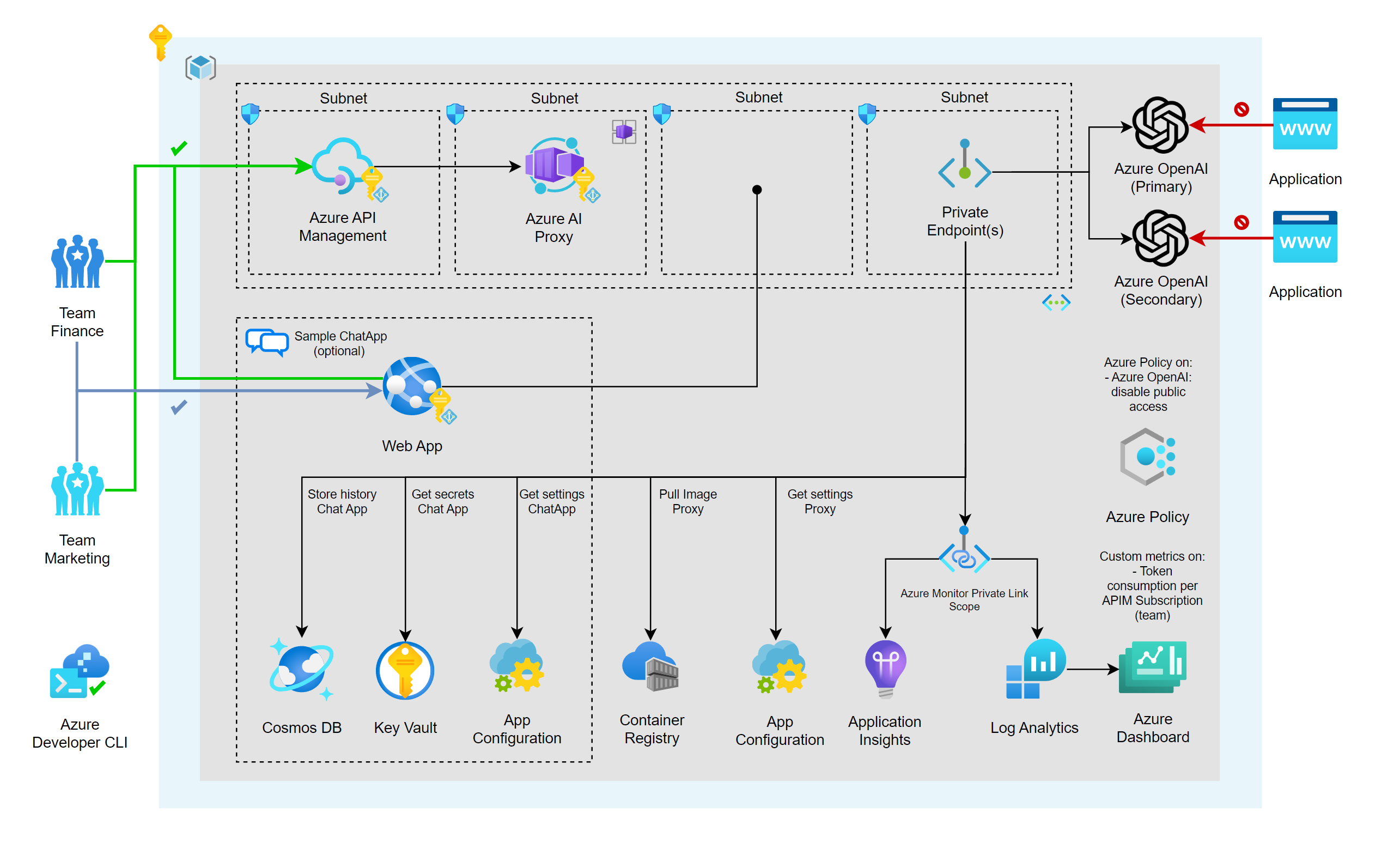

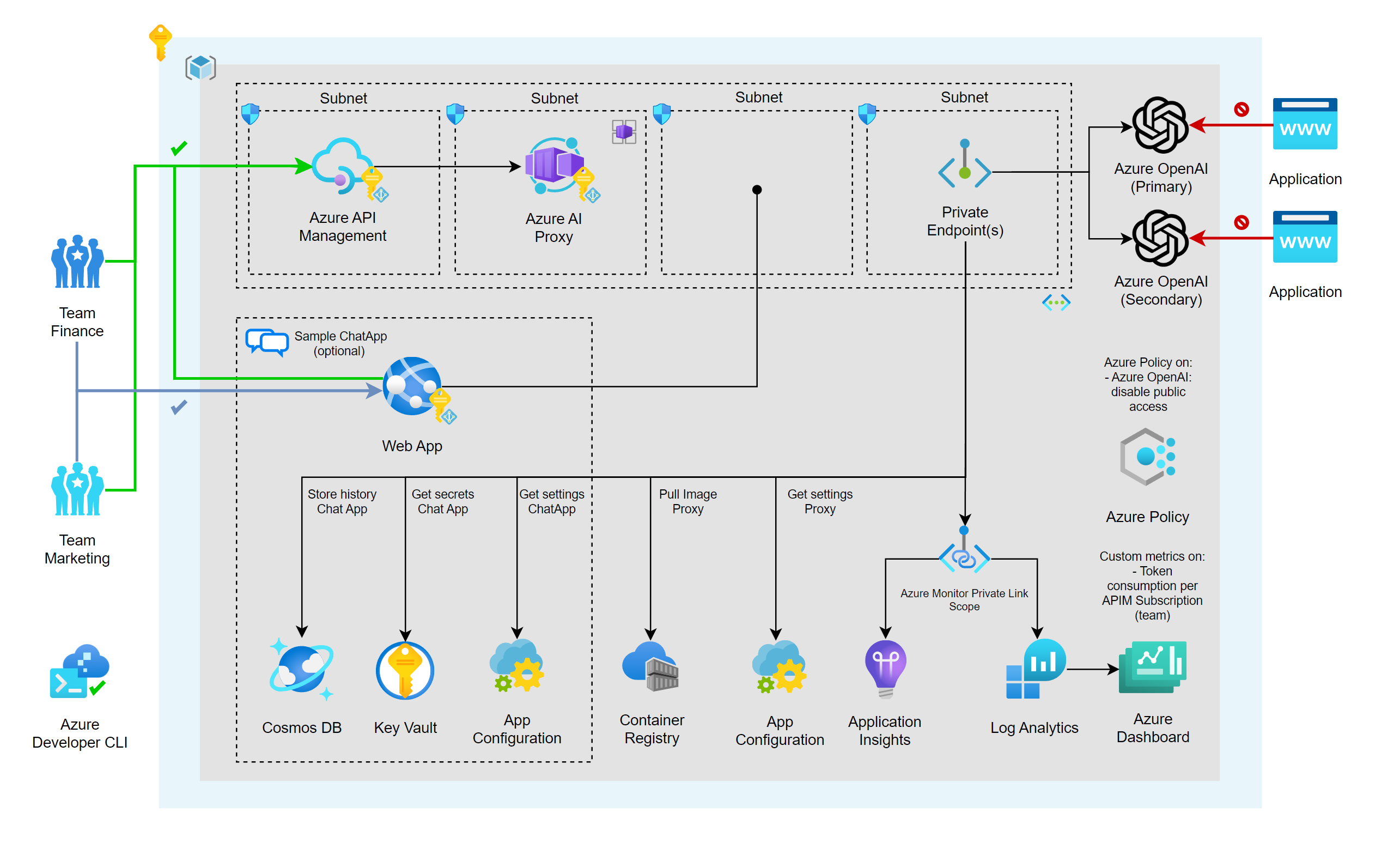

AZUREはいい立ち位置ですか?

結論から言うと、**Azure(Microsoft)は「かなり良い立ち位置」**です。

しかもそれは

短期(GPU不足時代)にも、中長期(エッジ・AI時代)にも効く位置です。

🟦 Microsoft Azureは今、どんな立ち位置か

一言で言うと:

「クラウド × AI × エッジ」を

“1つの企業でつなげられる、数少ないプレイヤー」

① GPU不足時代に「不利に見えて、実は有利」

表面上

- Azure成長率:39%

- AWSより鈍い?という見方

実態(重要)

- GPUは 足りていない

- しかし:

- Azure外販

- OpenAI

- Copilot(自社AI)

👉

GPUを“誰に使うか選べる立場”

これは

- GPUを「ただ貸す」AWS

- モデルを「作るだけ」のOpenAI

どちらにもできない強みです。

② Azureは「AIを売る場所」ではなく「AIを組み込む場所」

Azureの本質は👇

- ❌ AI API屋

- ❌ GPUレンタル屋

- ✅ 企業システムにAIを埋め込む基盤

具体例

- Office(Copilot)

- Teams

- Dynamics

- GitHub

- Windows

👉

AIが“自然に使われる導線”を持っている

これは

が最も苦戦している部分です。

③ エッジ時代との相性が非常に良い

Azureは **「全部クラウドでやらせない」**設計を取れます。

代表例

- Azure Arc

- Azure IoT Edge

- Windows + NPU(Copilot PC)

👉

- 即時判断:エッジ

- 高度推論:Azure

- 学習・管理:Azure

という

ハイブリッド前提の思想

これはあなたがやっている

ロボット / VPR / 状態検出の世界観と完全に一致します。

④ Microsoftは「勝ち筋を分かっている」会社

Microsoftの戦略は一貫しています:

- GPUは希少資源

- だから

- すべてをAzure売上に回さない

- 将来のAIプロダクトに回す

- 結果:

👉 Hood発言(あなたが聞いたやつ)は

「我々は分かってやっている」宣言です。

⑤ 他社との立ち位置比較(超重要)

| 企業 |

強み |

弱み |

| AWS |

規模 |

AI体験が弱い |

| Google |

モデル |

企業導線が弱い |

| OpenAI |

技術 |

プラットフォームがない |

| Microsoft / Azure |

全部つなげられる |

GPU配分が難しい |

👉

最も“全体最適”に近い

一文で結論

Azureは、GPU不足・AI競争・エッジ化という

すべての制約条件の中で、

「最も柔軟に勝ち筋を選べる立ち位置」にいる。

もし次に進むなら、

- AzureはAWSを本当に逆転できるか

- Copilotはどこまで“OS”になるか

- エッジ×Azureはロボット分野で勝てるか

どれを掘りますか?